基于Eureka搭建Springcloud微服务-章节内容合集

博客内容介绍

博客内容概述

本篇博客涉及主要内容有:

1.微服务简介

2.搭建项目基础设施

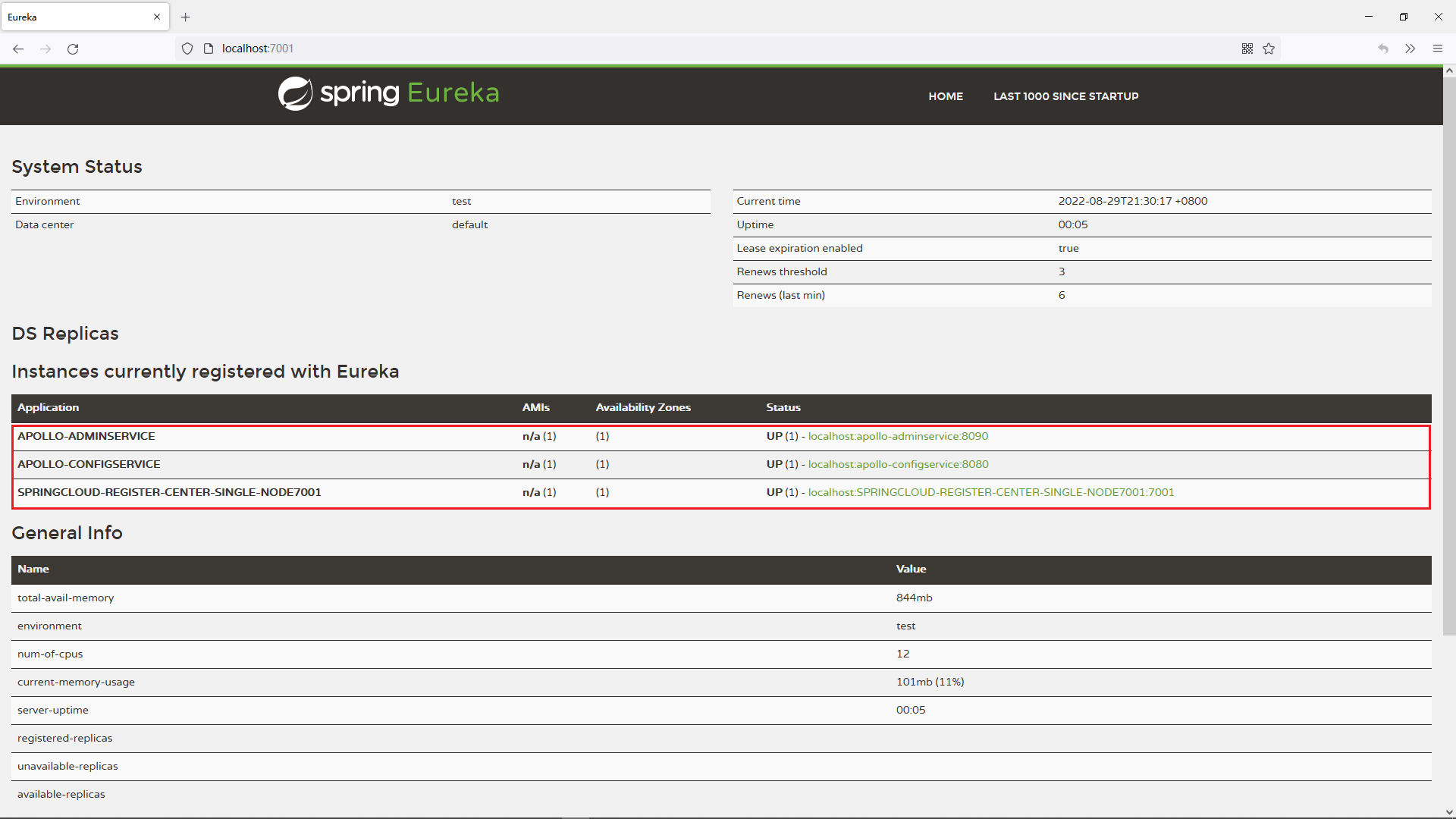

3.使用Eureka作为注册中心

4.搭建第一个微服务应用

5.使用Ribbon实现客户端负载均衡

6.使用OpenFeign实现客户端负载均衡

7.使用Hystrix实现服务降级和熔断

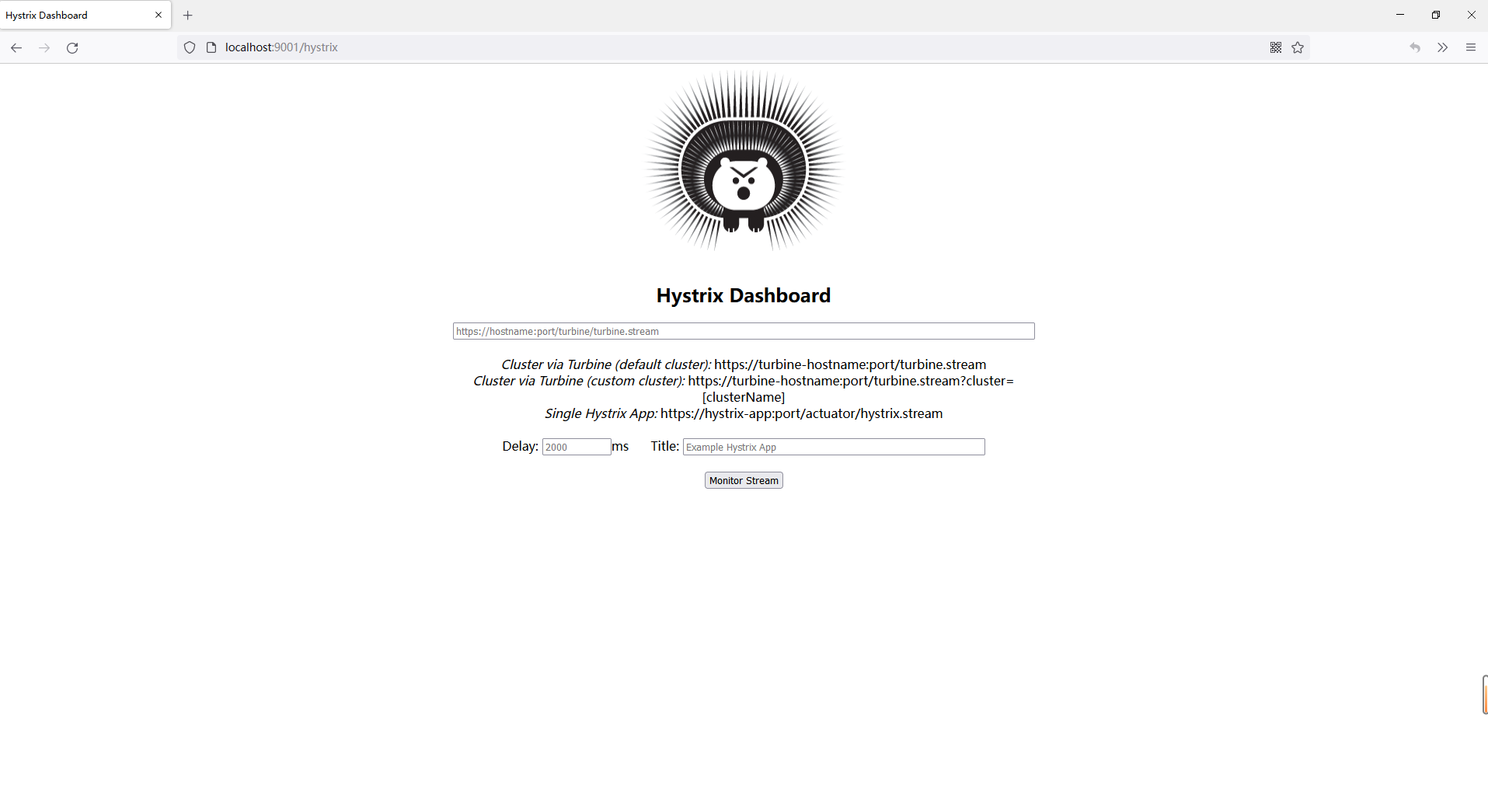

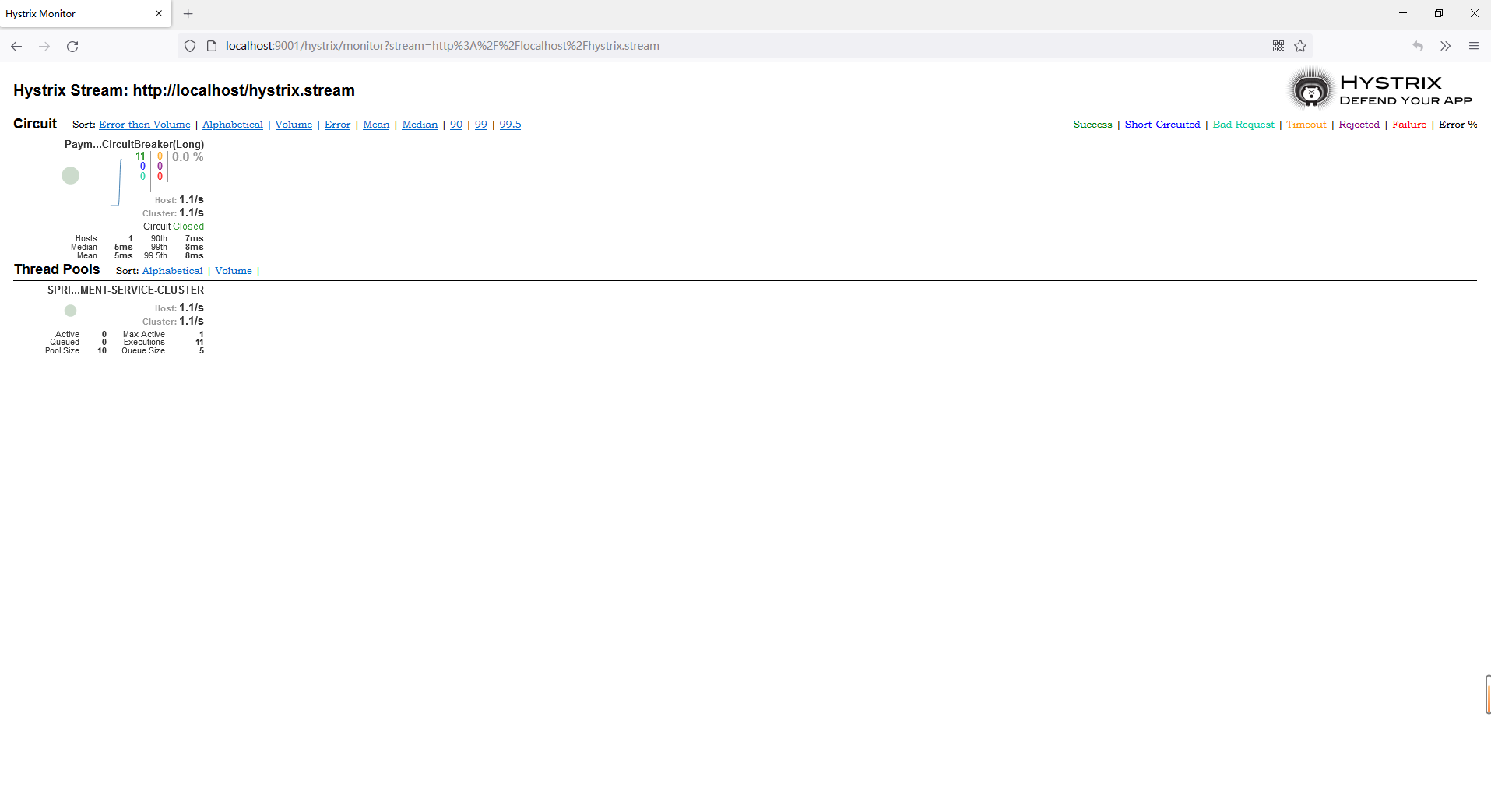

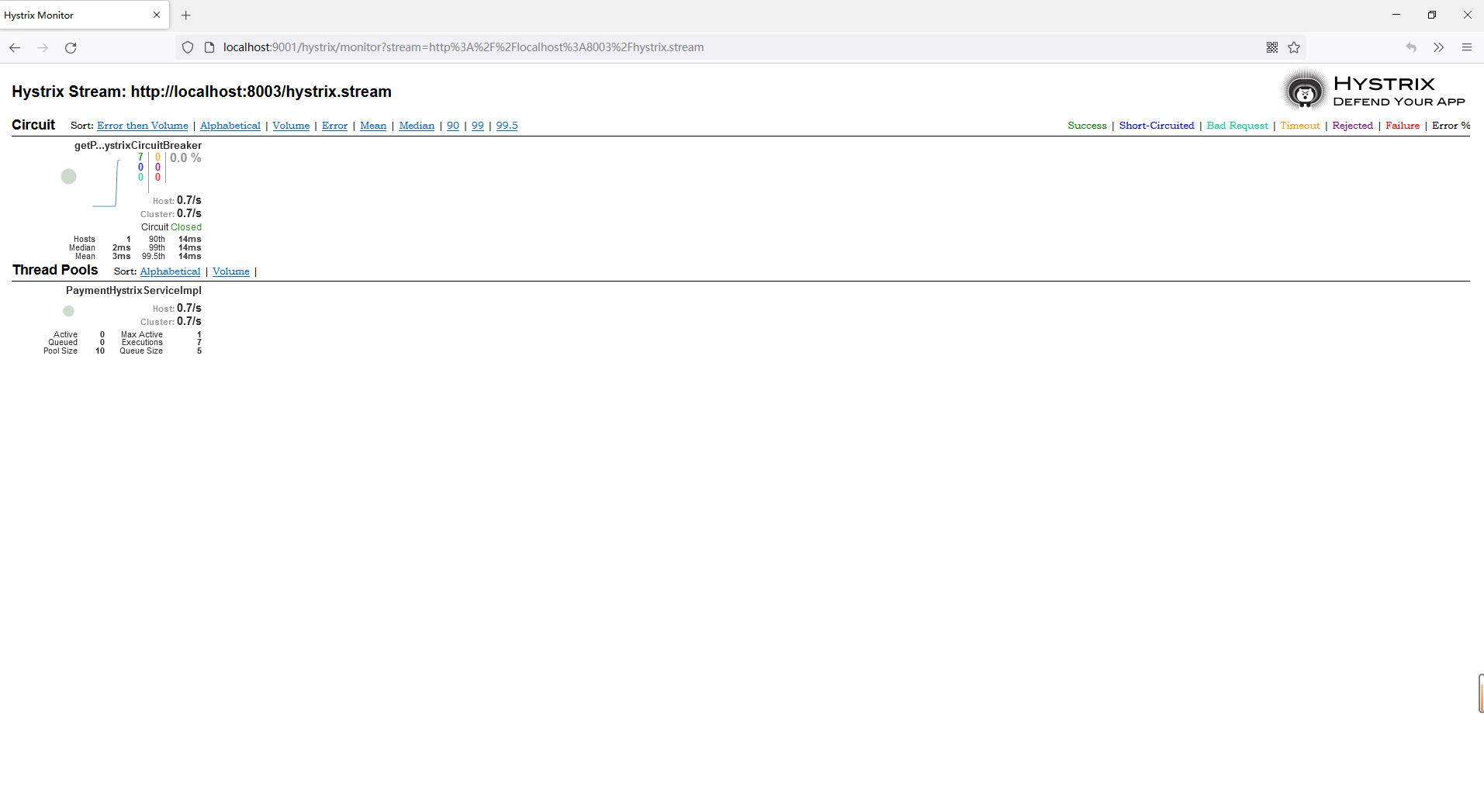

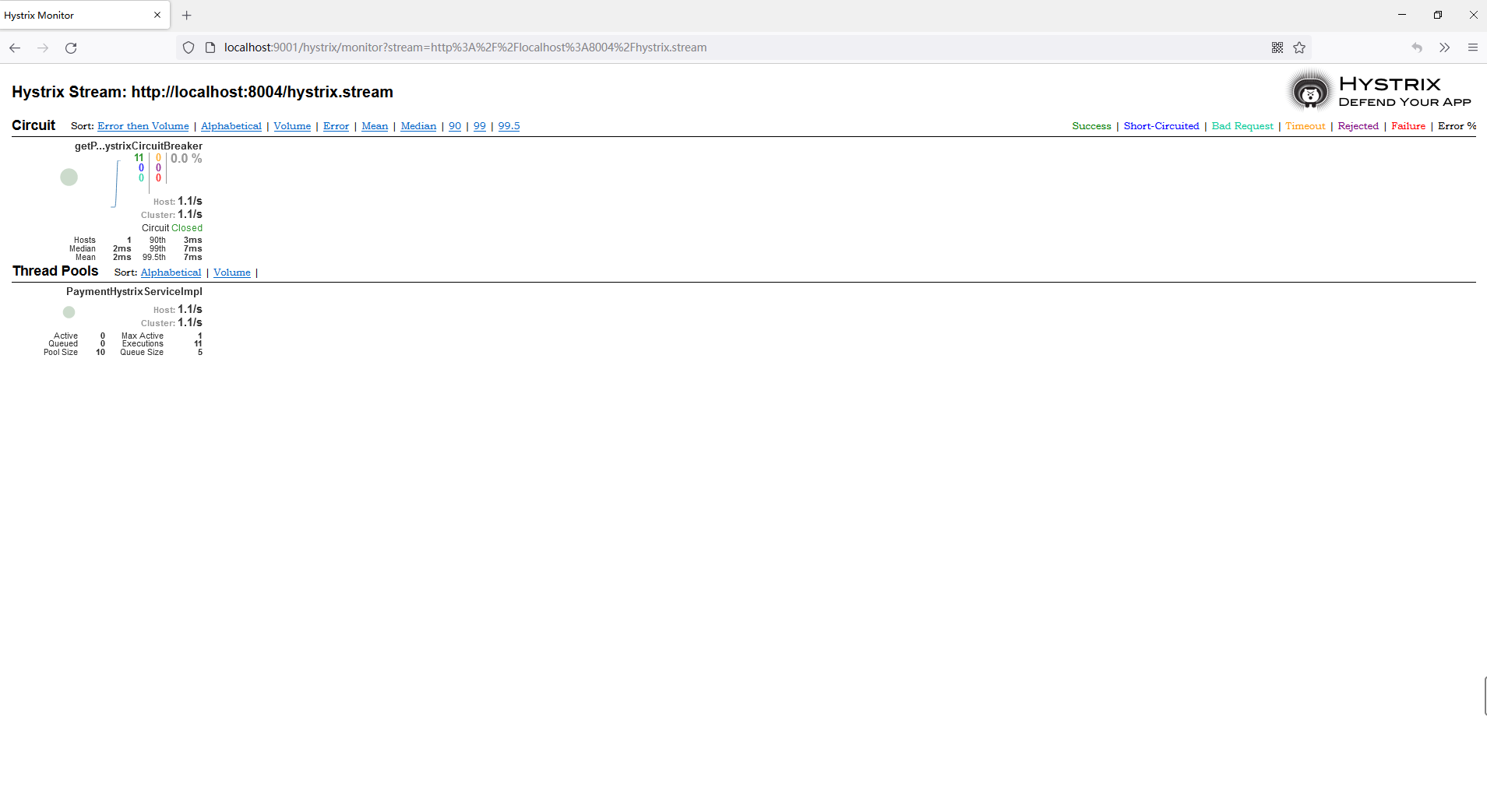

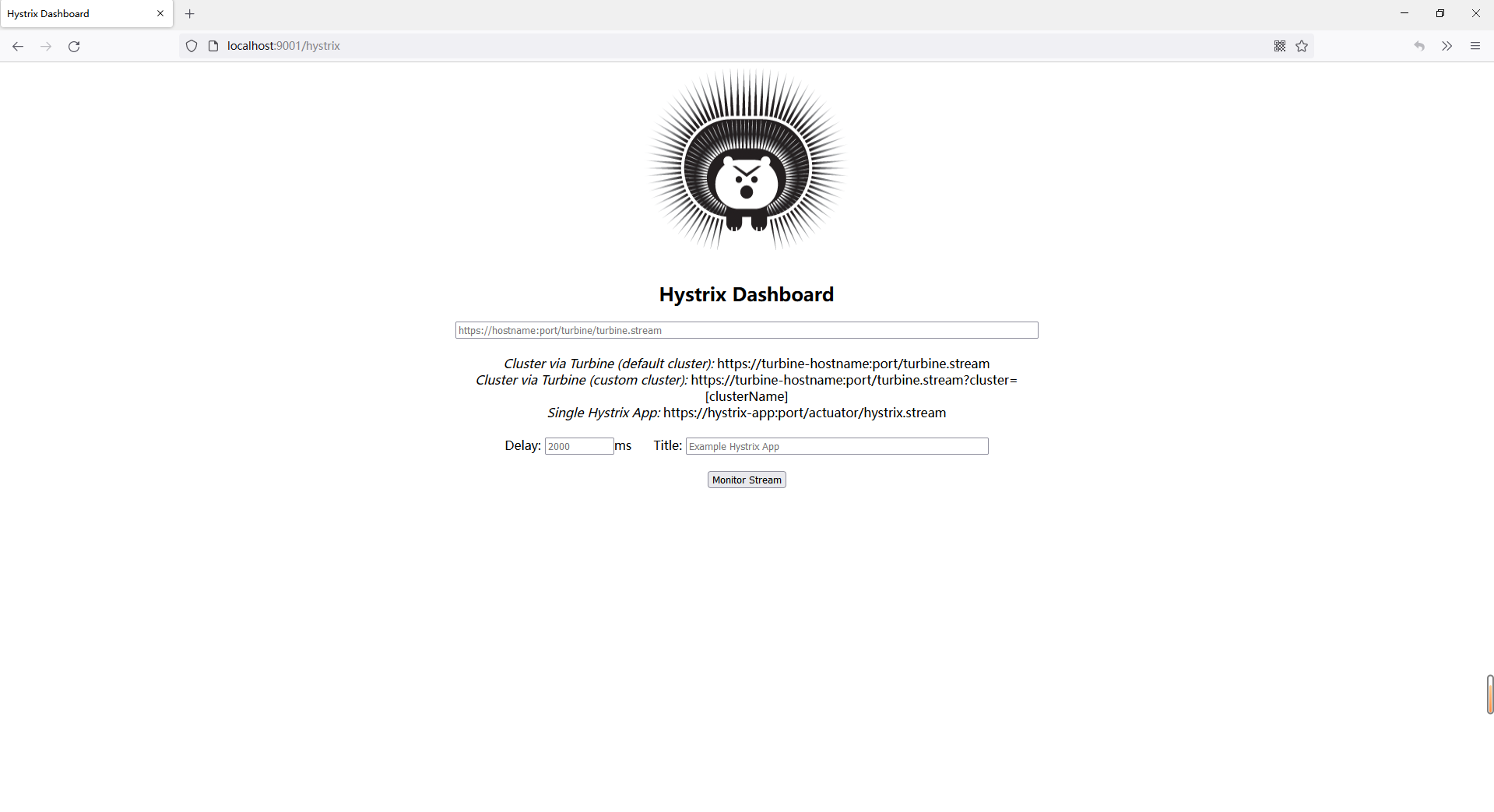

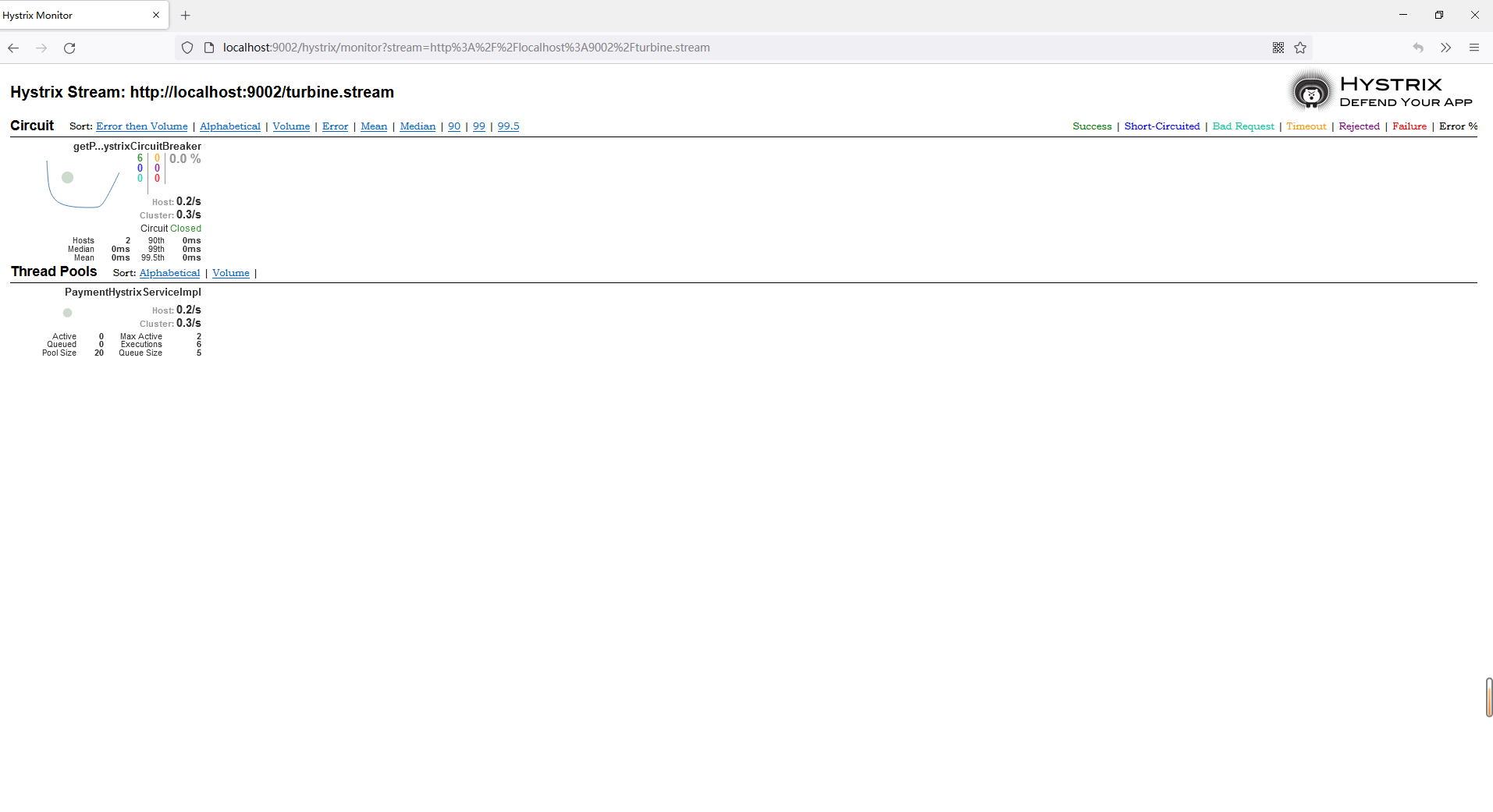

8.使用DashBoard和Turbine监控服务访问情况

9.使用GateWay实现网关功能

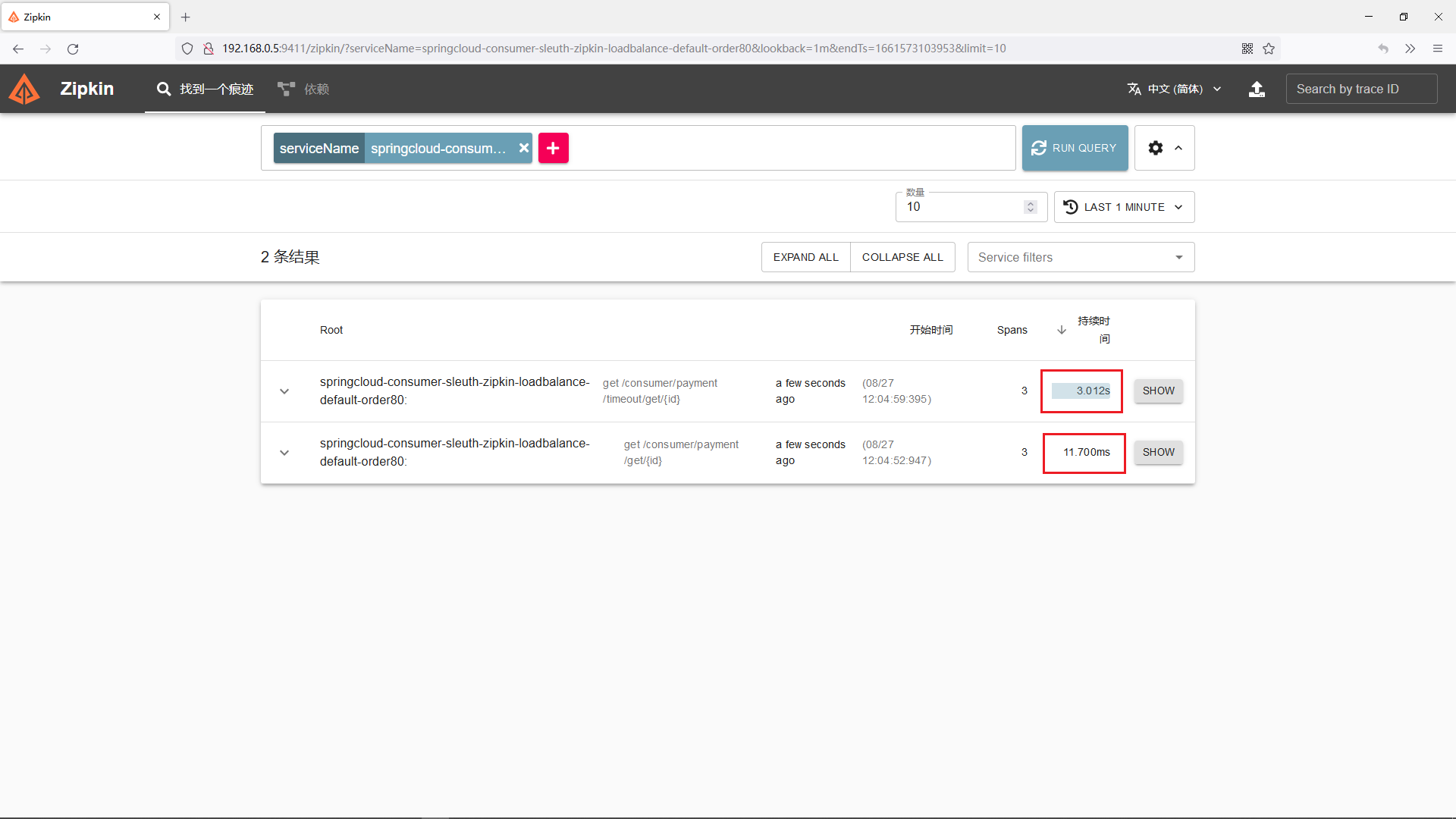

10.使用Zipkin+Sleuth实现调用链路追踪

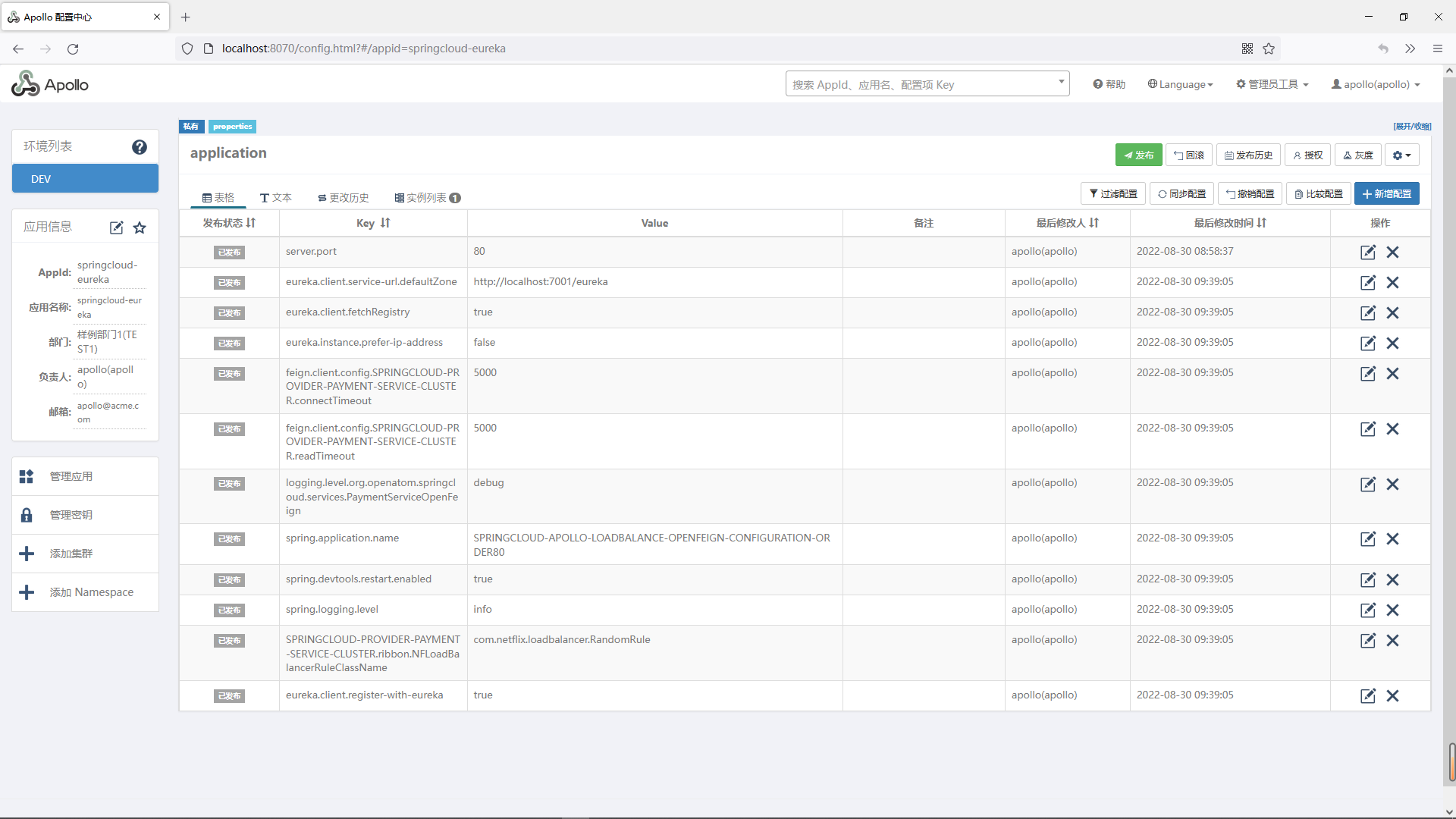

11.使用Apollo配置中心管理配置

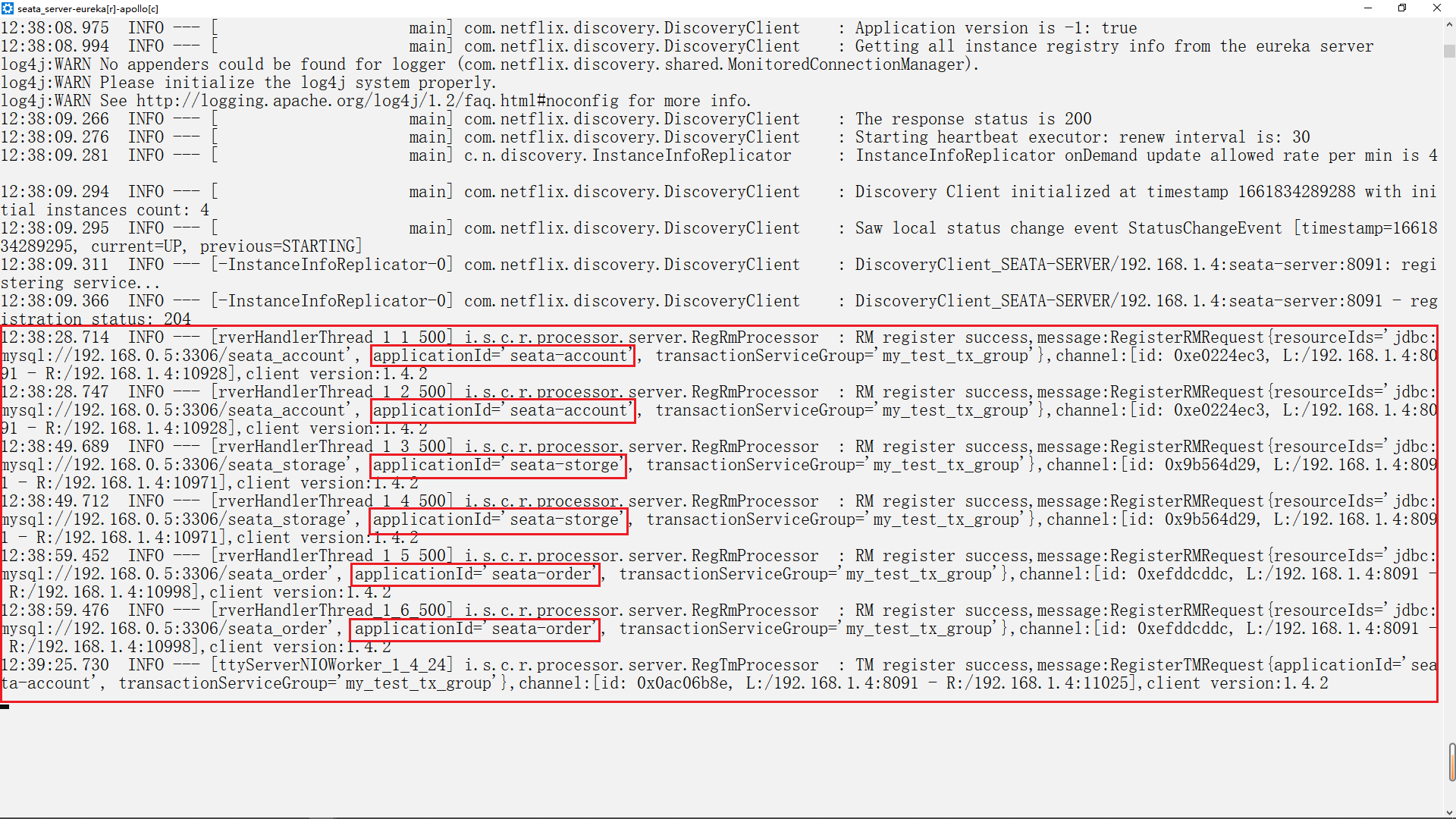

12.使用Seata进行分布式事务控制

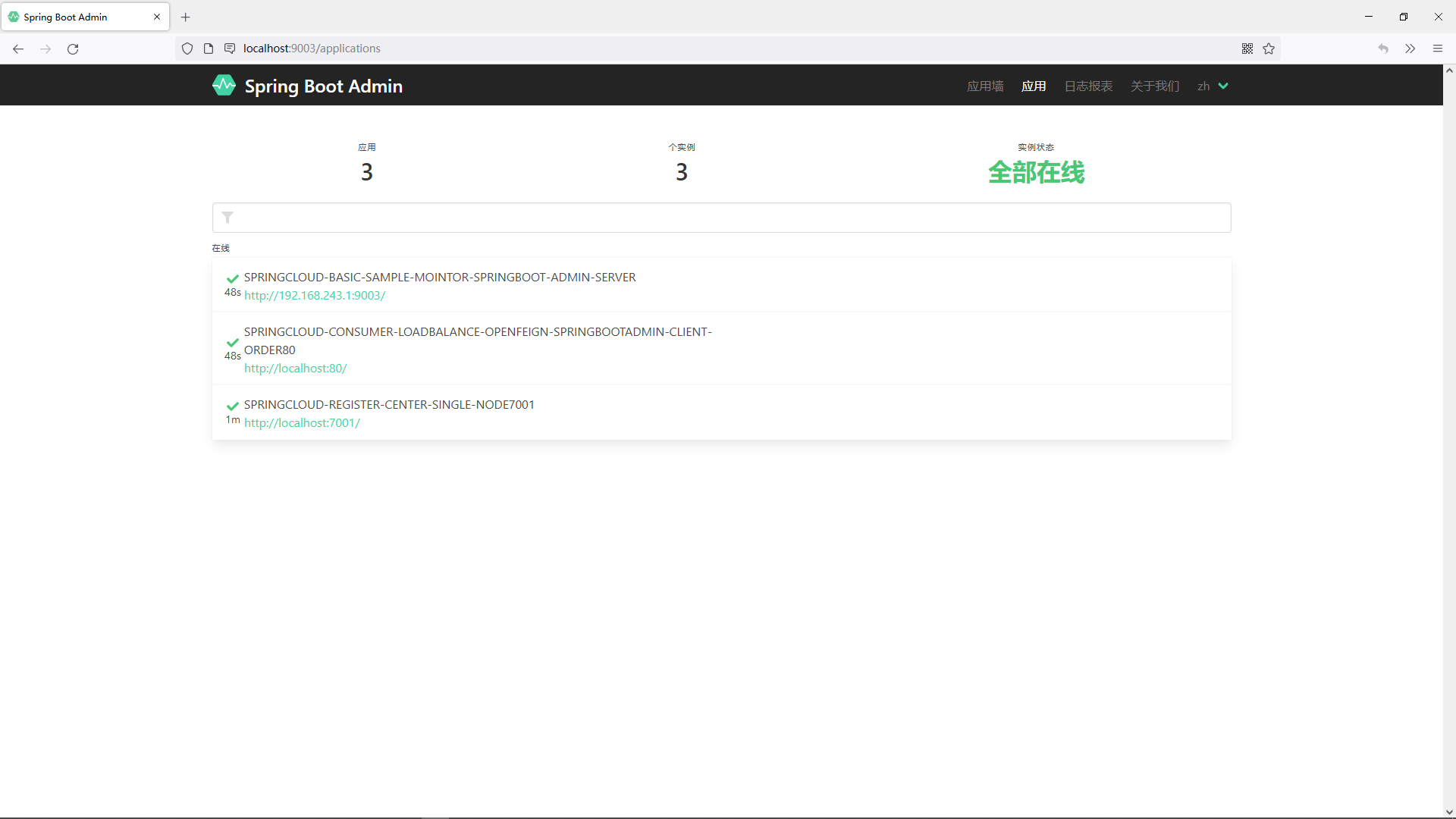

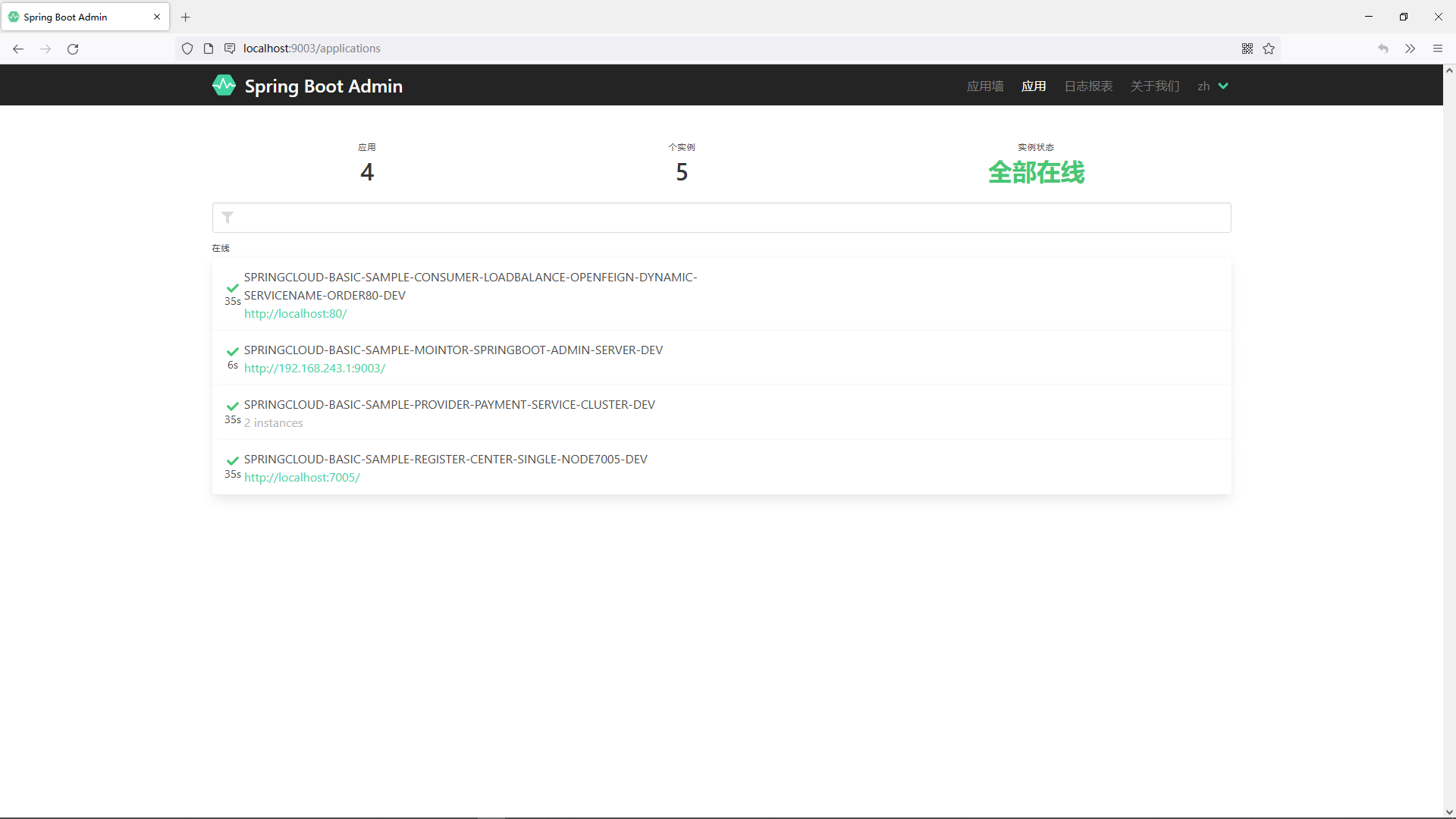

13.使用SpringBootAdmin监控服务

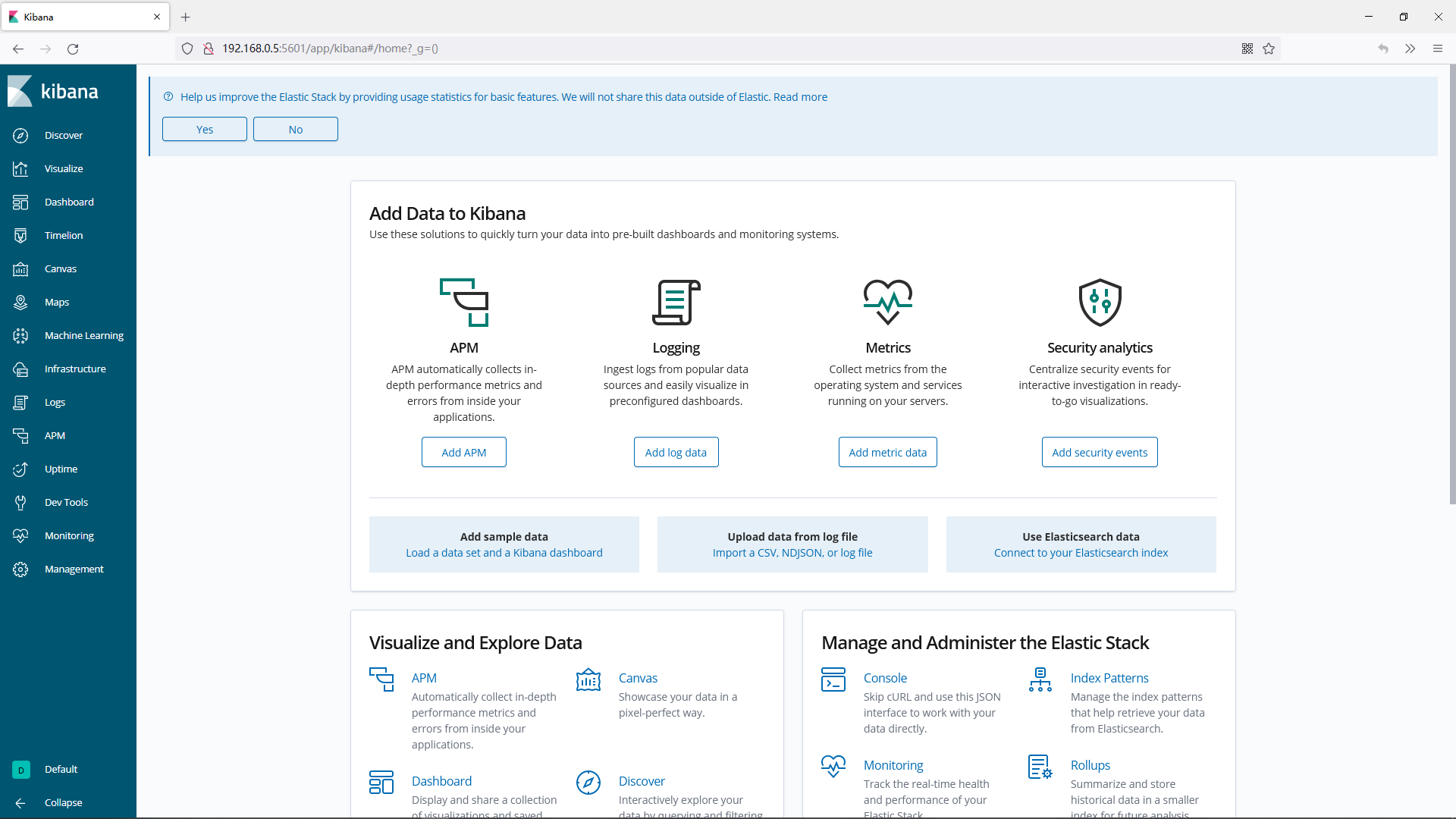

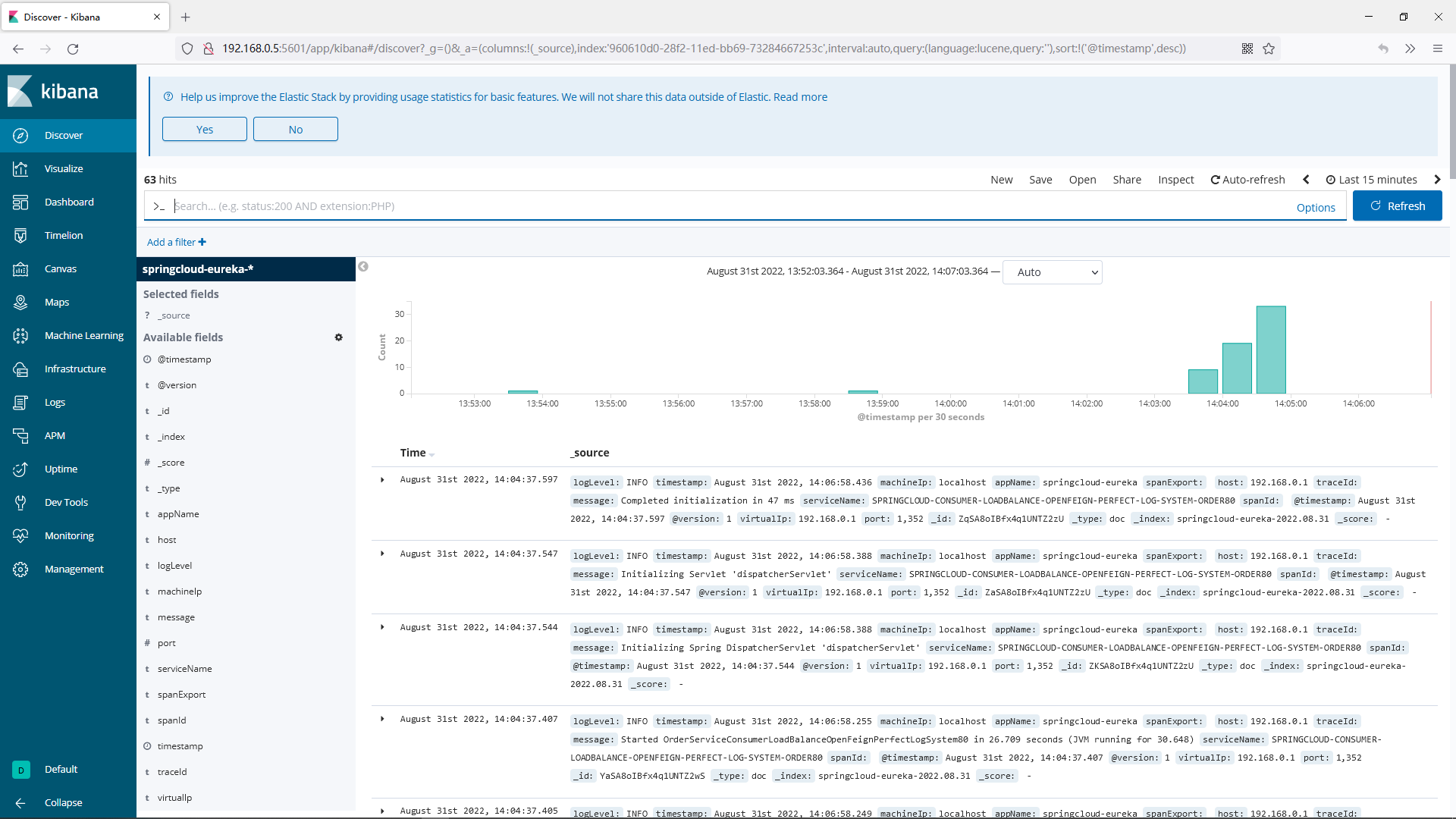

14.设计适用于生产环境的日志系统

15.OpenFeign高级用法

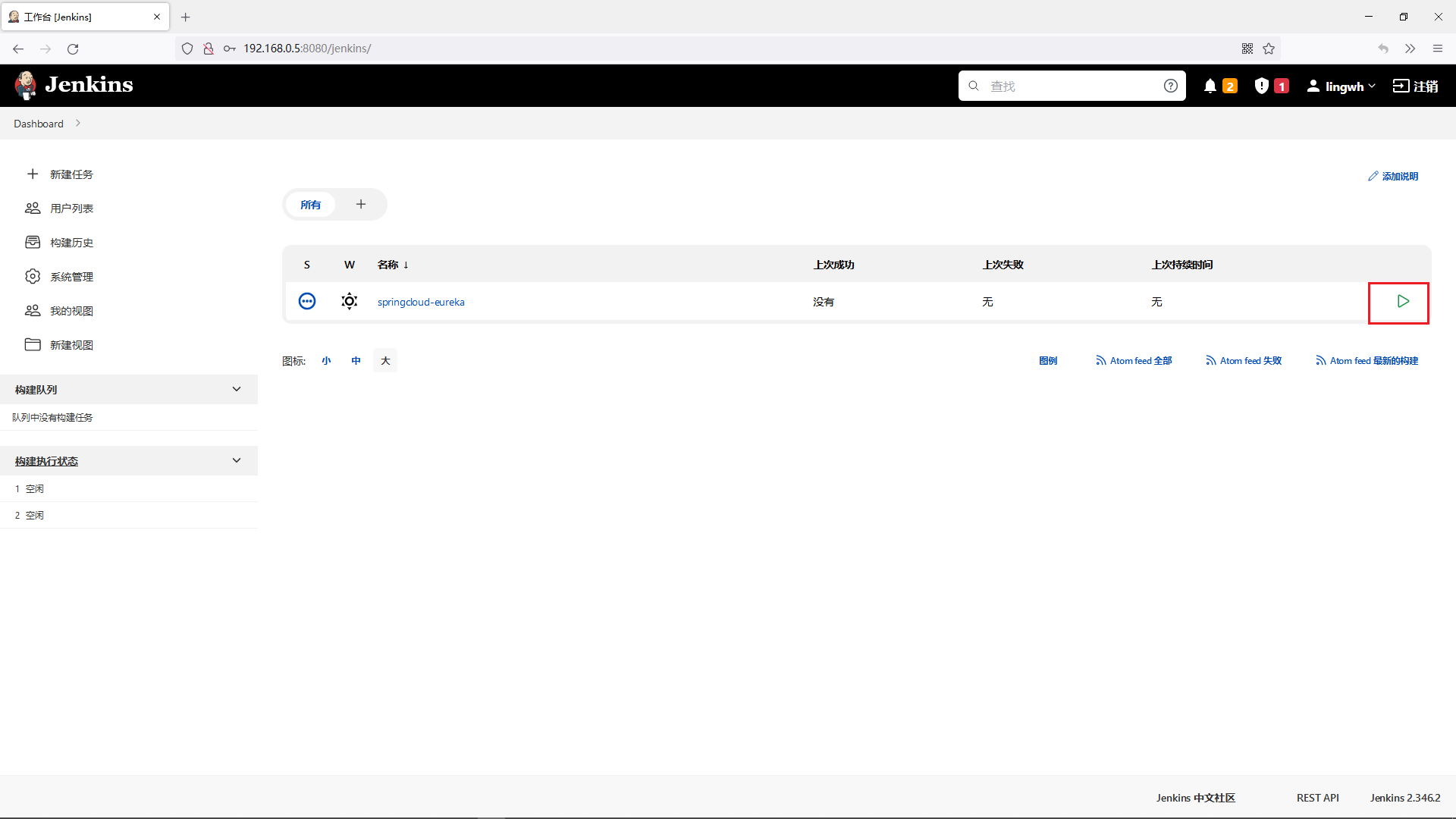

16.使用持续集成快捷部署服务

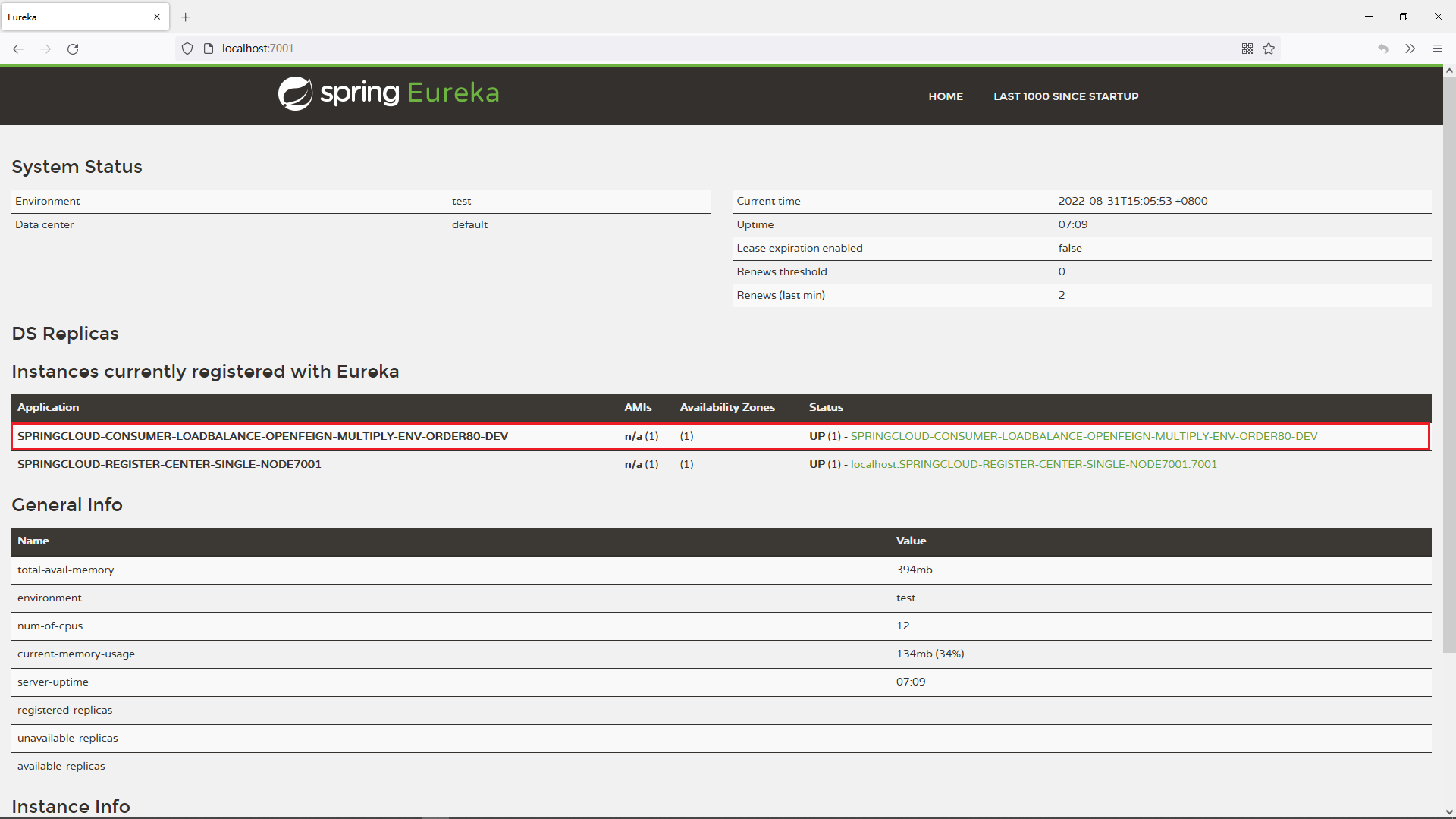

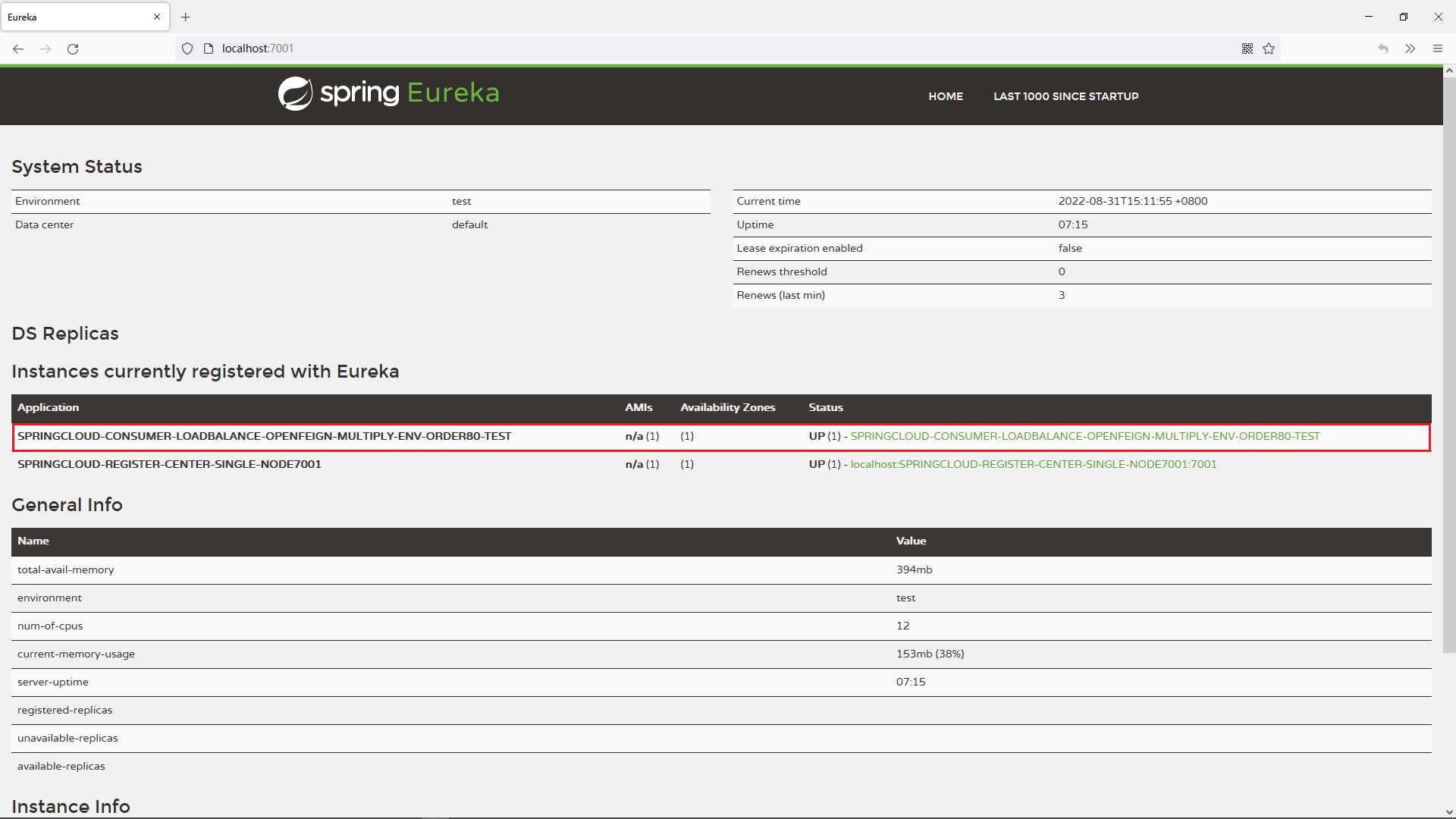

17.让微服务区分多种不同环境

18.使用mycat提升数据库吞吐能力

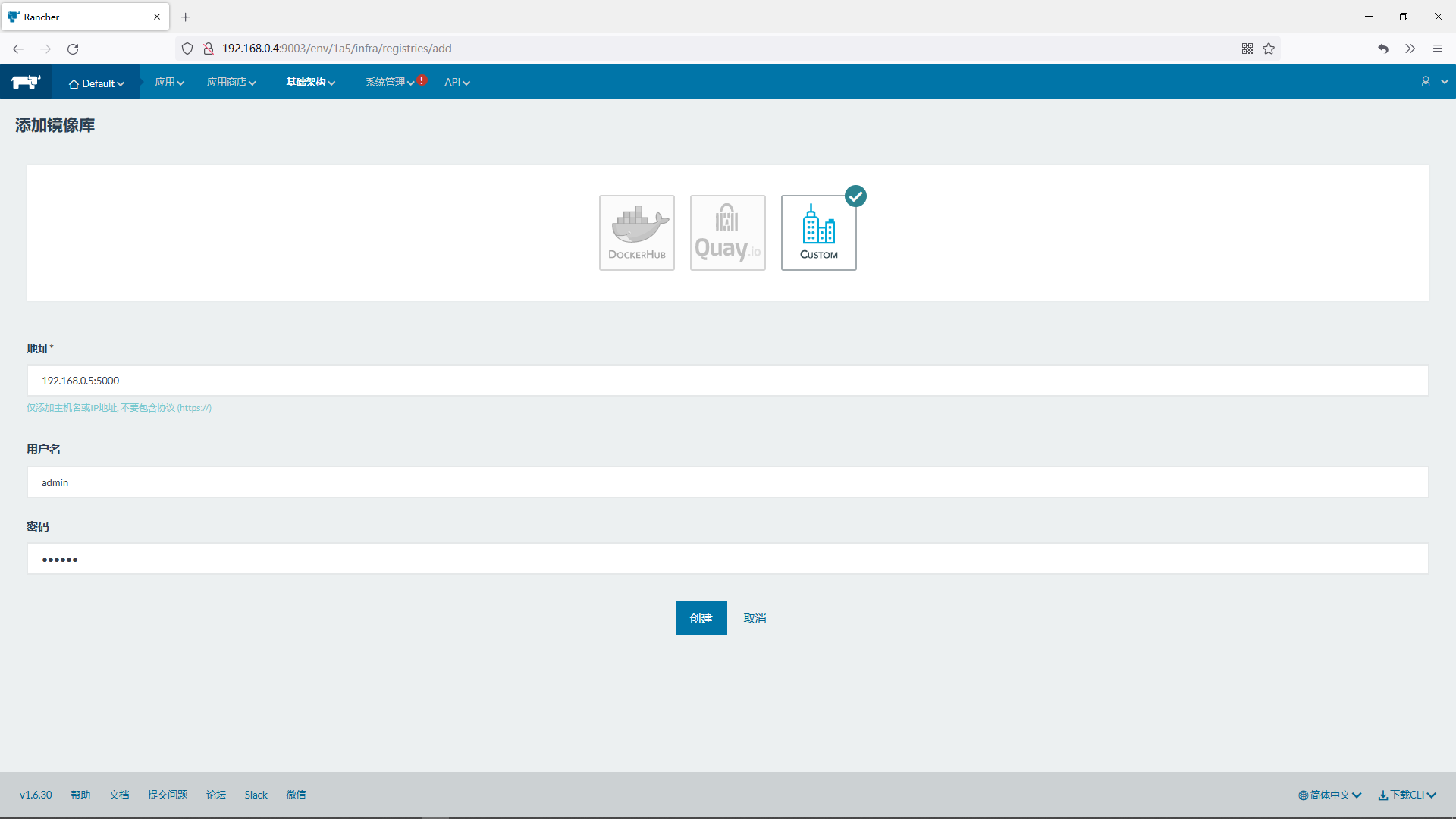

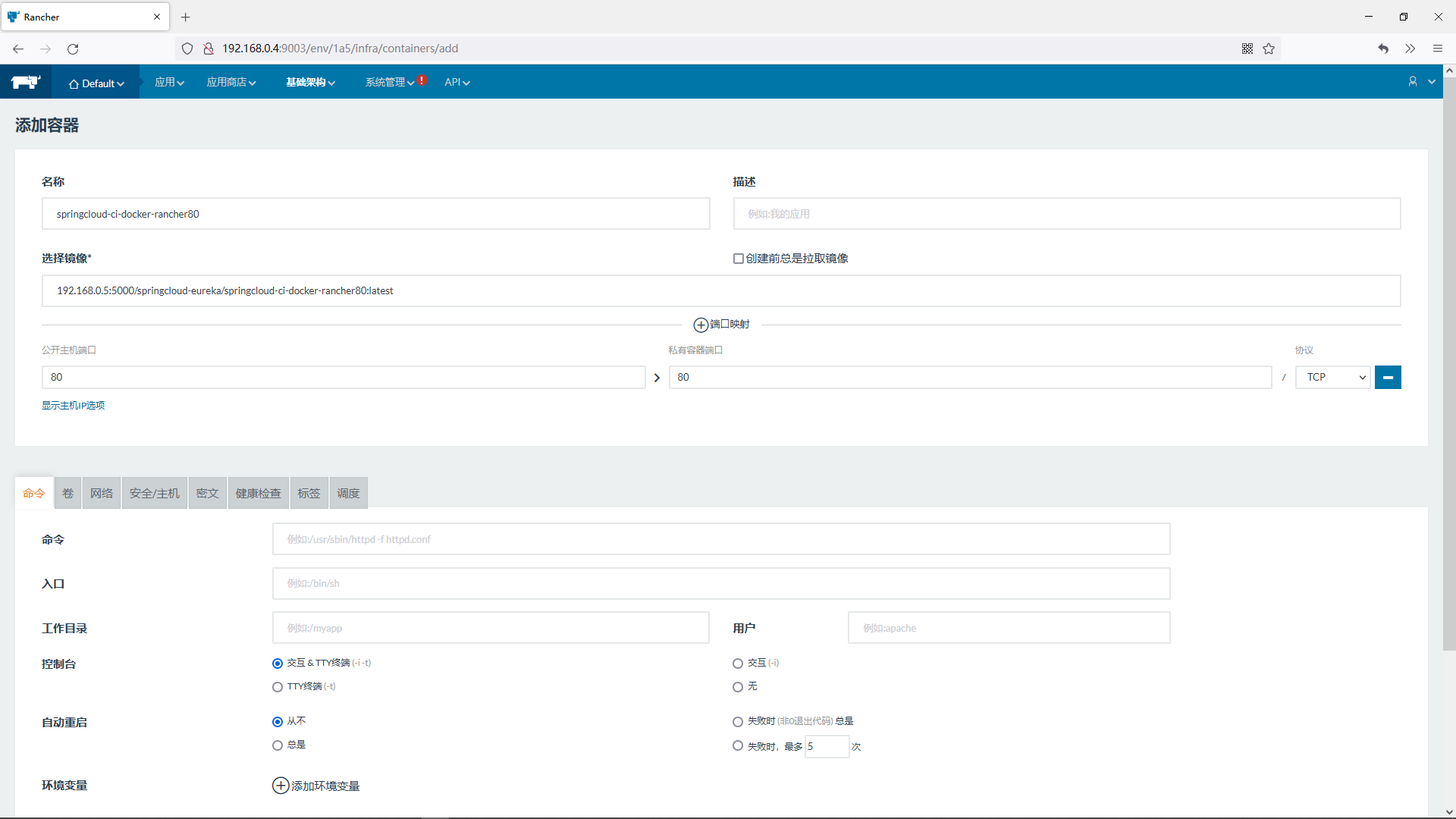

19.使用rancher管理docker和Kubernetes

20.综合案例

具体每个章节中包含的内容可使通过下面博客内容大纲进行查看。

博客内容大纲

简单版博客内容大纲

详细版博客内容大纲

1.微服务简介

1.1.章节内容概述

本章节涉及主要内容有:

1.1.章节内容概述

1.2.章节内容大纲

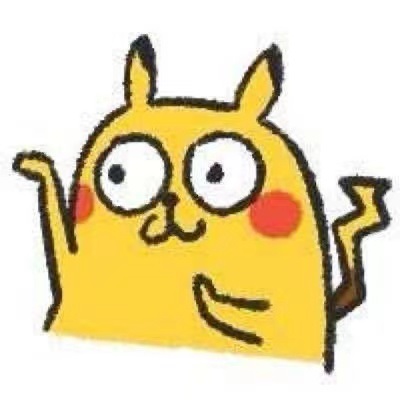

1.3.微服务架构图

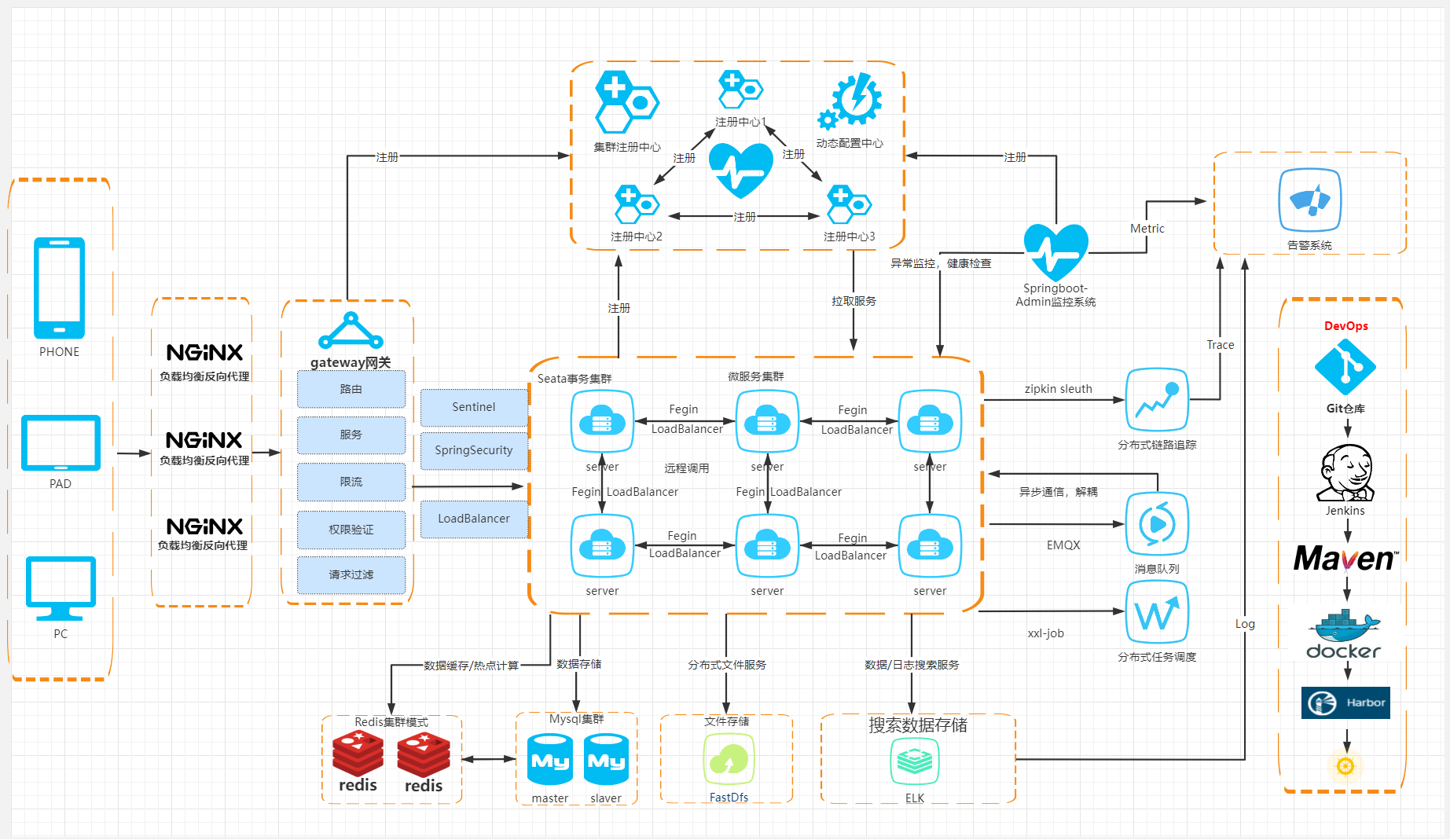

1.4.CAP中占据情况

1.3.微服务架构落地实现方案

具体每个小节中包含的内容可使通过下面的章节内容大纲进行查看。

1.2.章节内容大纲

1.1.Martin Fowler微服务论文英文原版

https://martinfowler.com/articles/microservices.html

1.2.Martin Fowler微服务论文国内译版

如需国内译版,请使用谷歌翻译插件翻译自行翻译

1.3.微服务架构图

1.4.CAP中占据情况

Eureka在CAP中占据AP

1.3.微服务架构落地实现方案

微服务架构落地实现有很多种方案,本次介绍的方案技术栈如下

注册中心: Eureka

远程调用: Ribbon/OpenFeign

客户端负载均衡: Ribbon/OpenFeign

服务熔断/服务降级: Hystrix

服务访问数据统计分析(单节点): Hystrix DashBoard

服务访问数据统计分析(多节点): Turbine

服务网关: Gateway

调用链路追踪: Zipkin + Sleuth

配置中心: Apollo

分布式事务控制: Seata

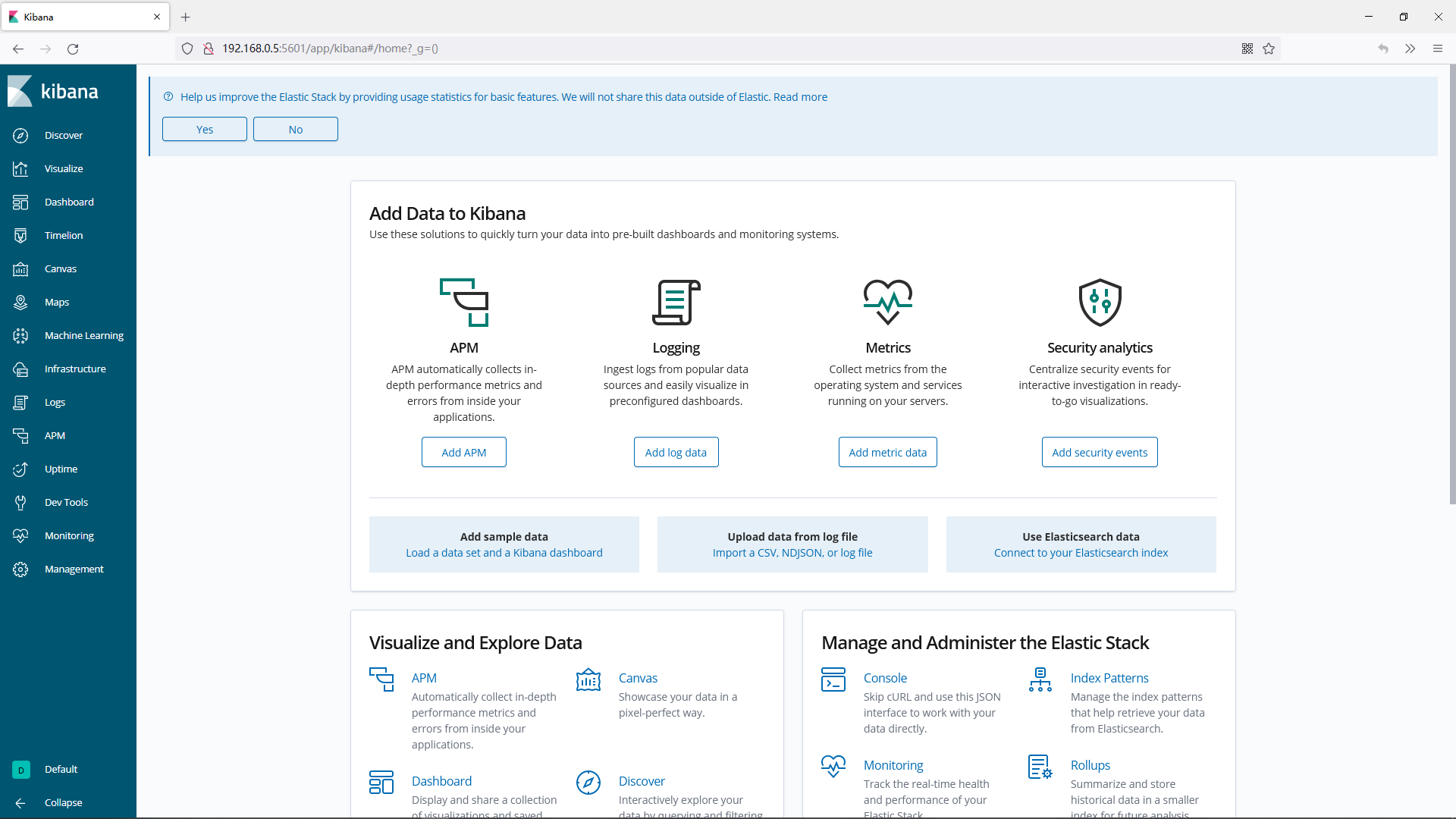

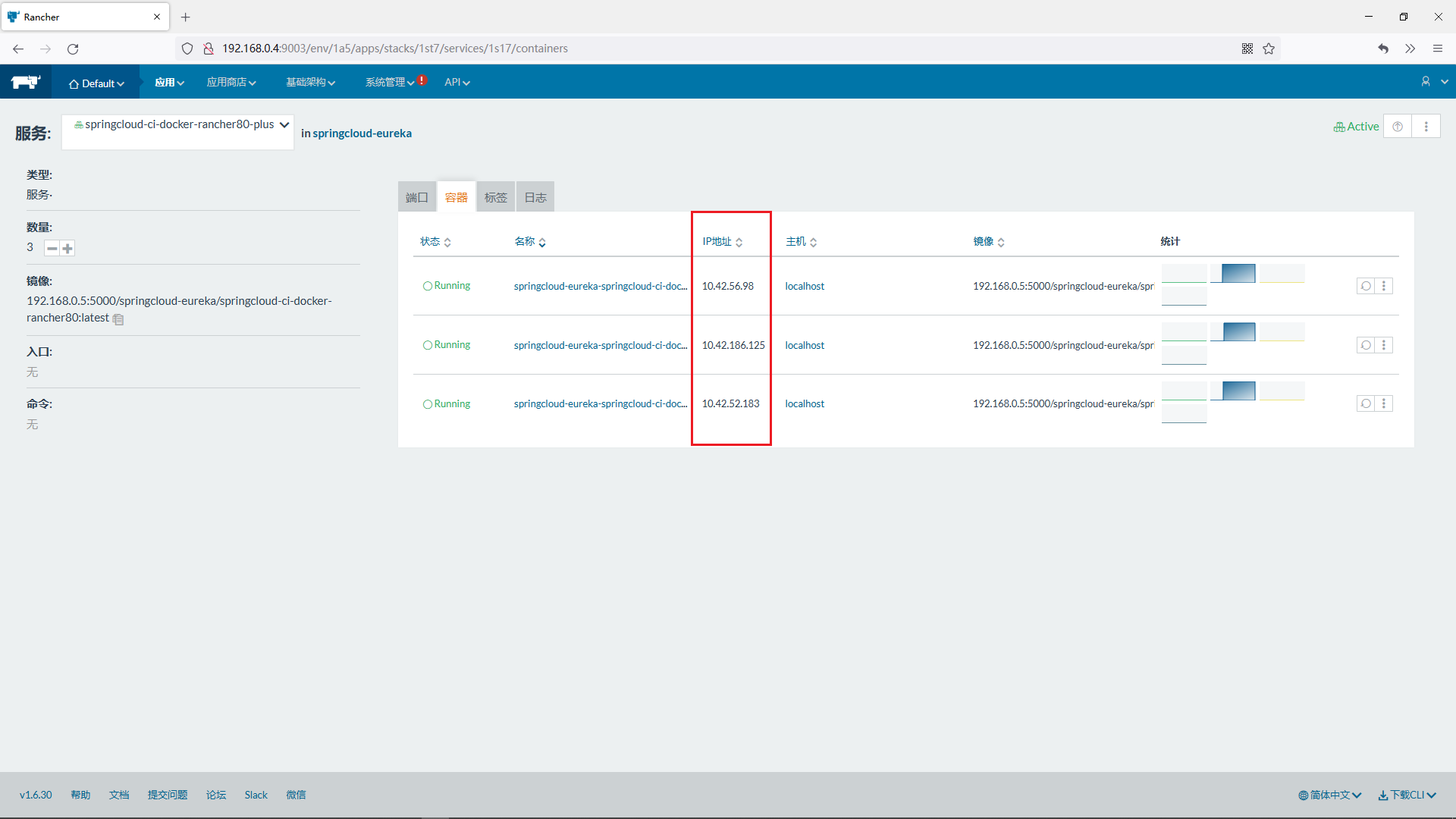

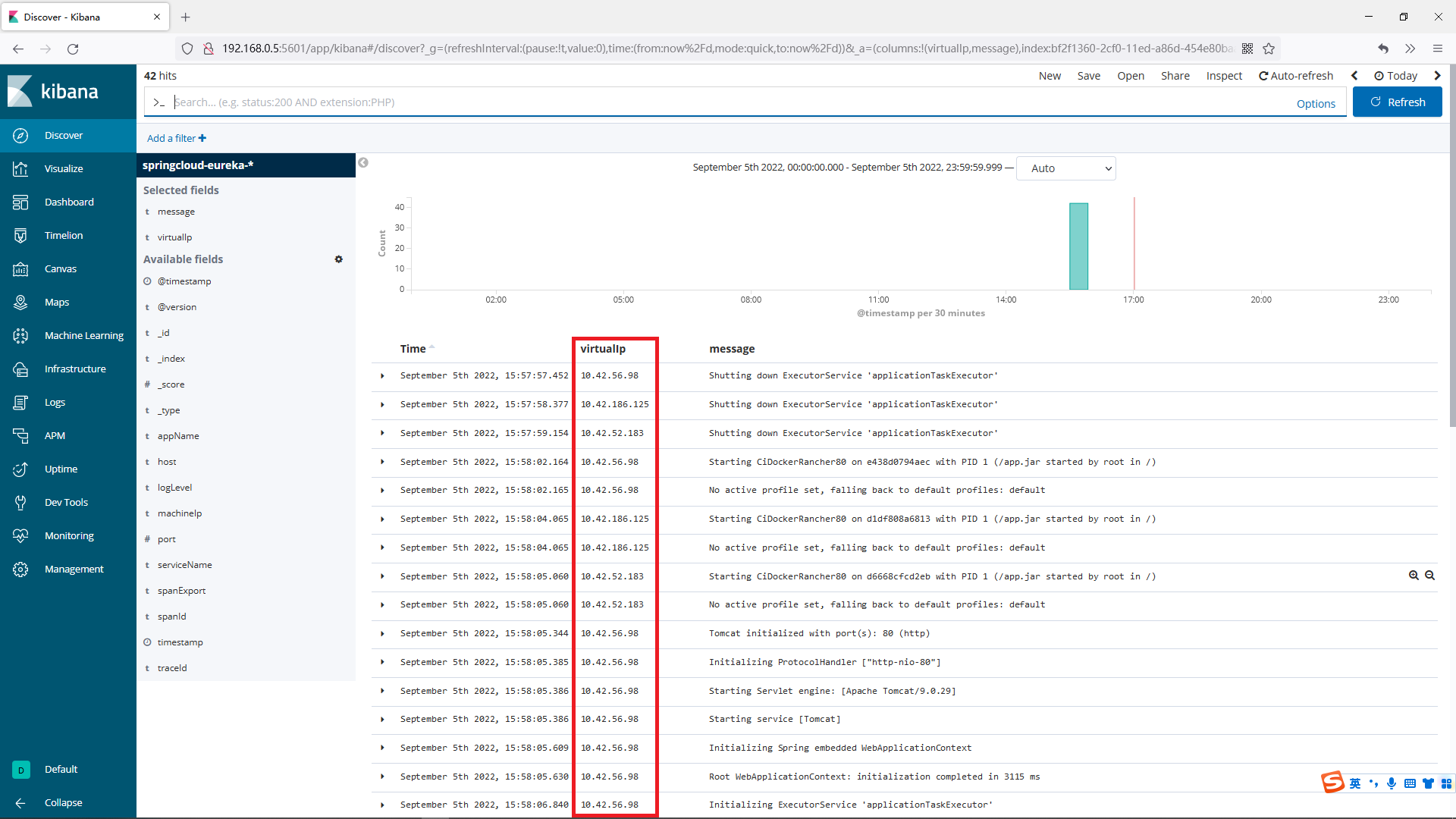

分布式日志系统: LogStash + ELK

服务监控: SpringBootAdmin

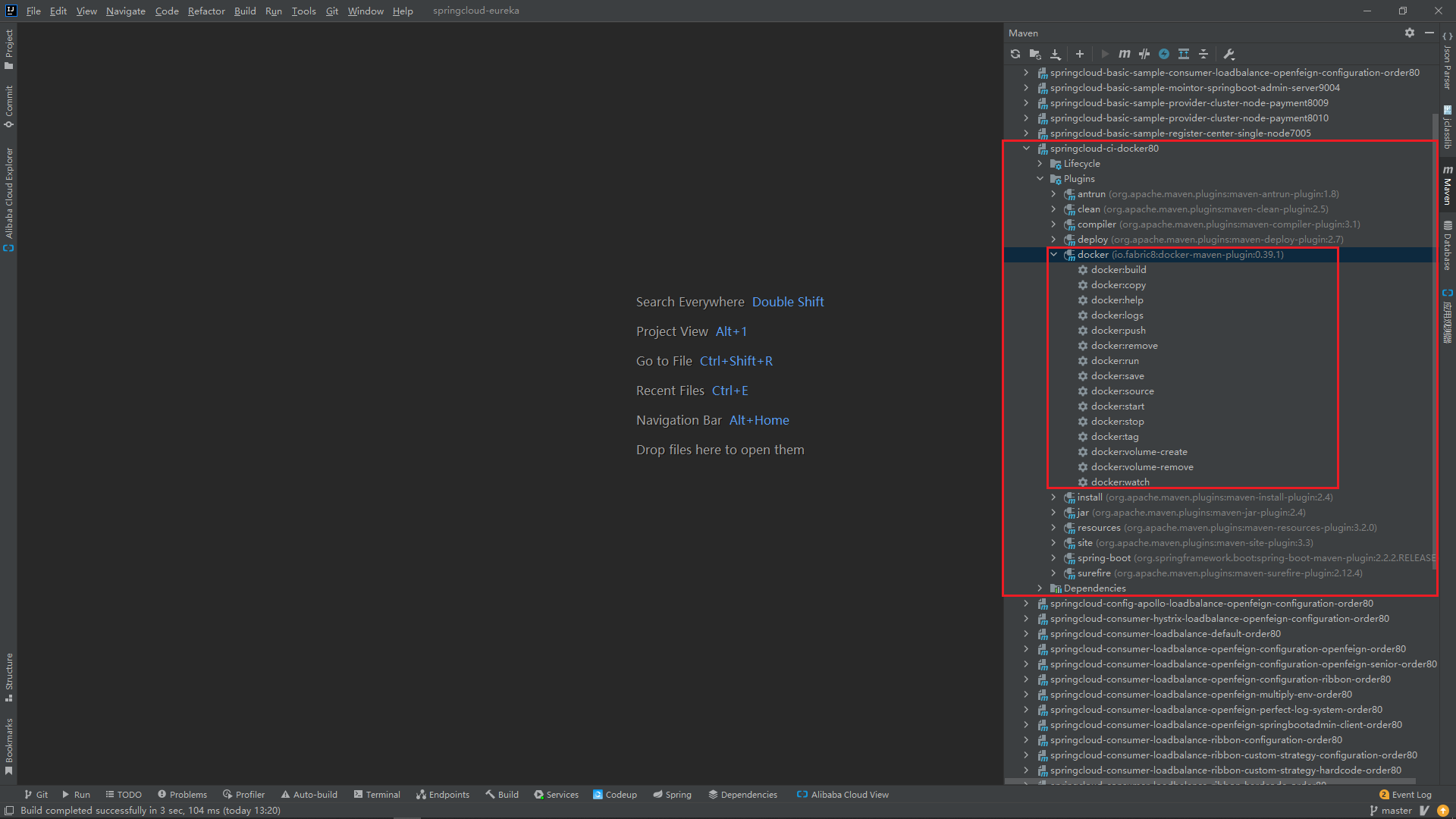

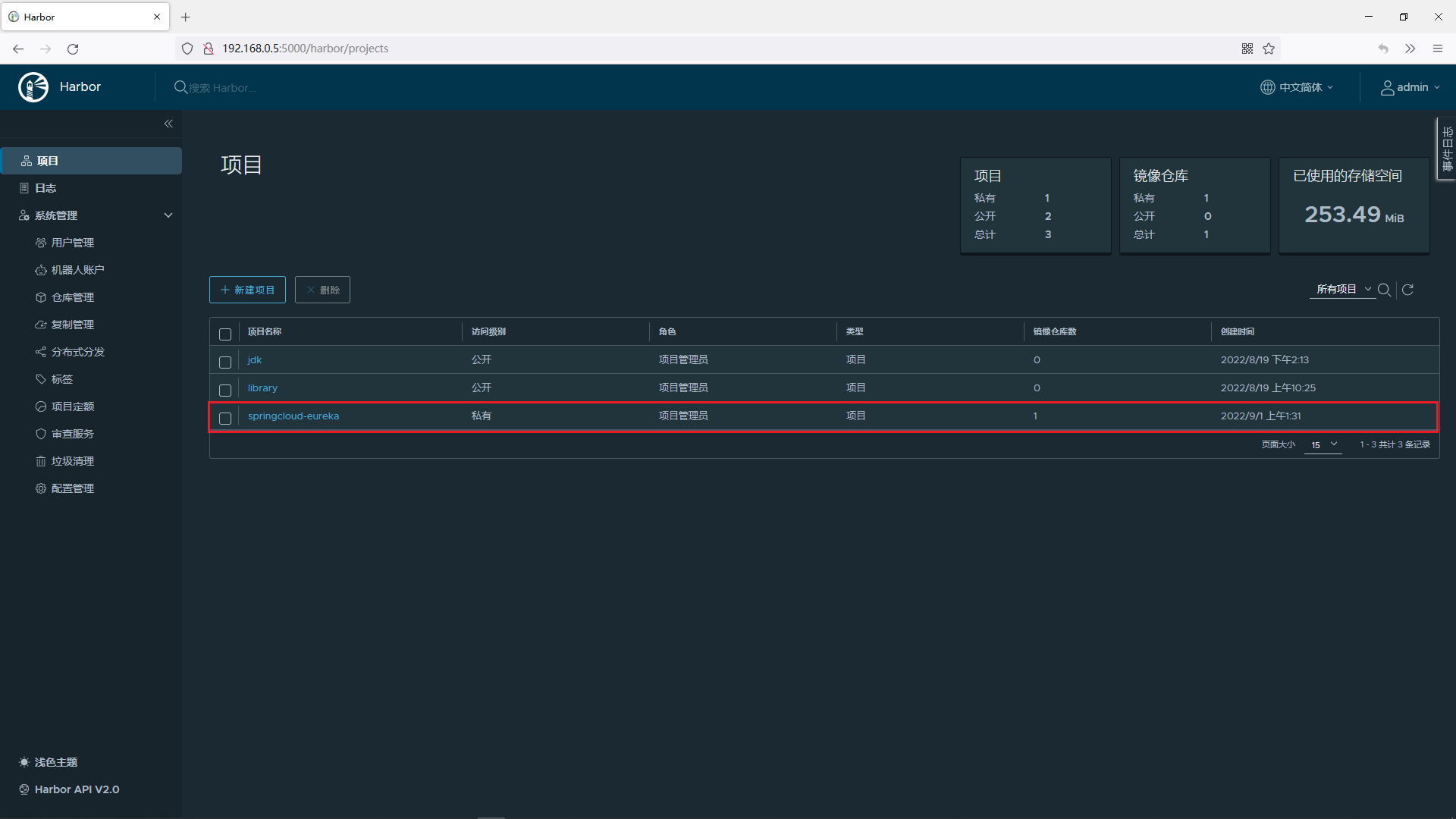

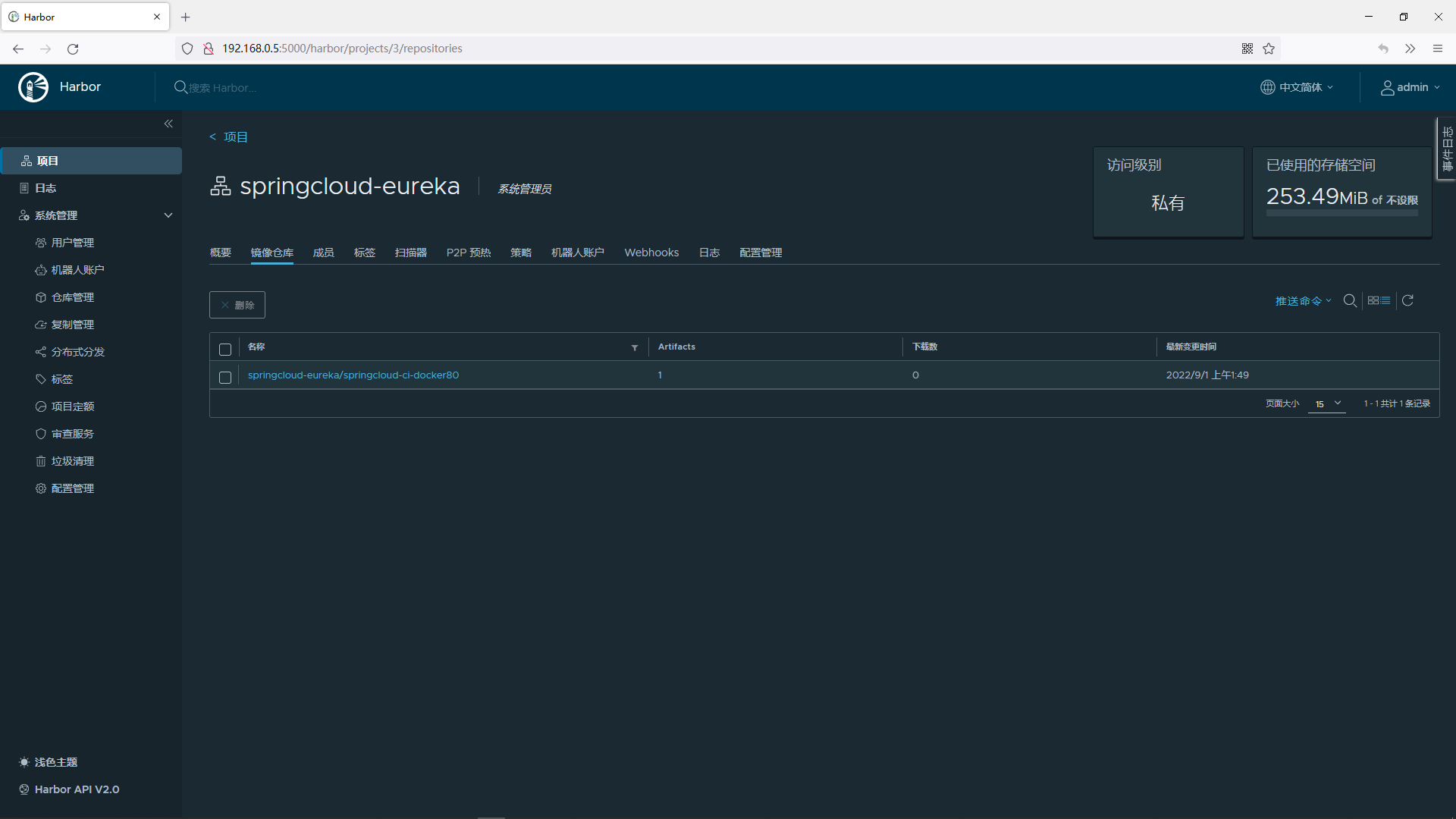

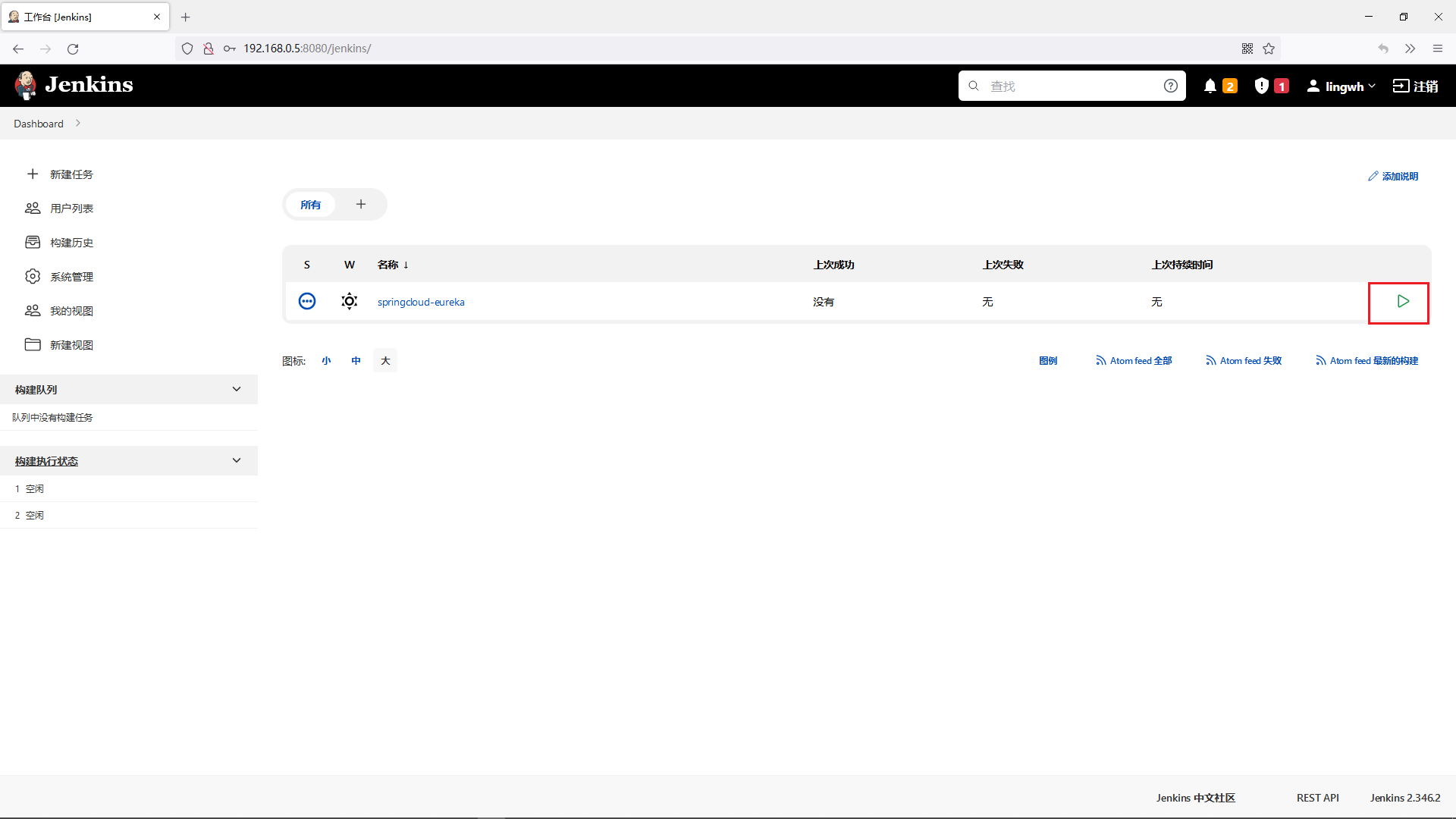

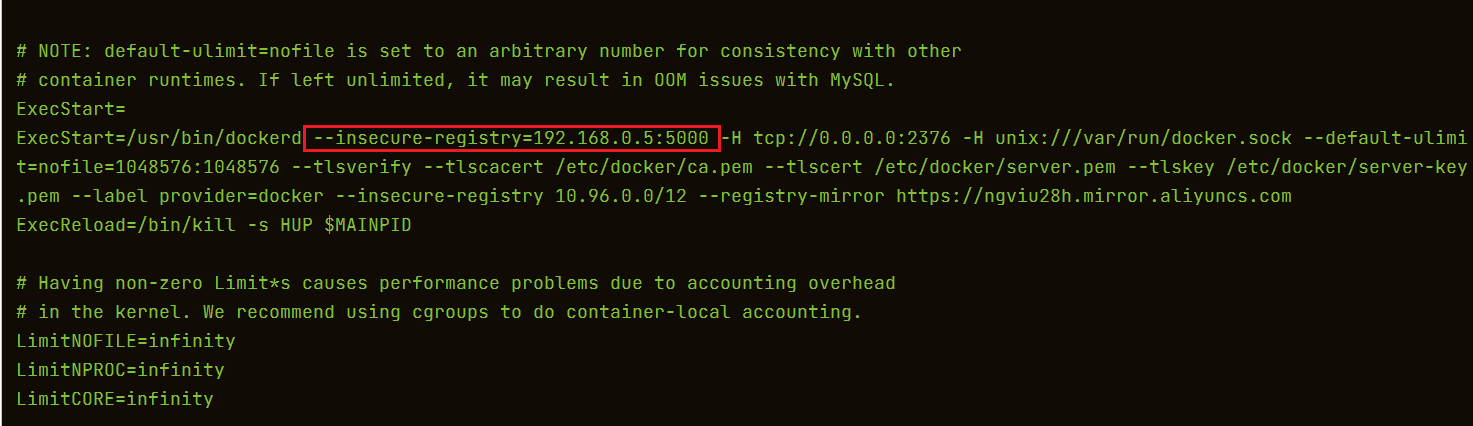

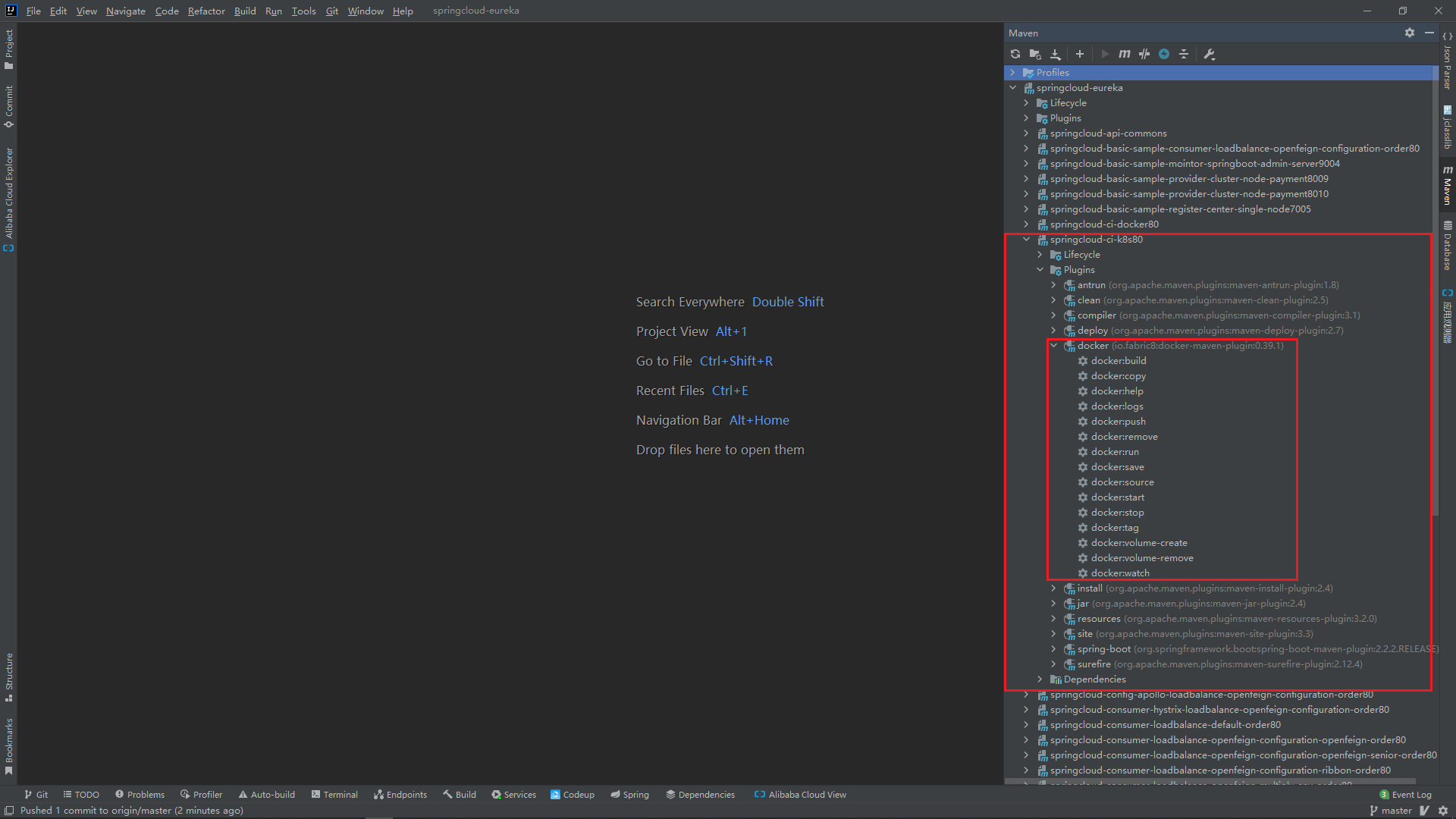

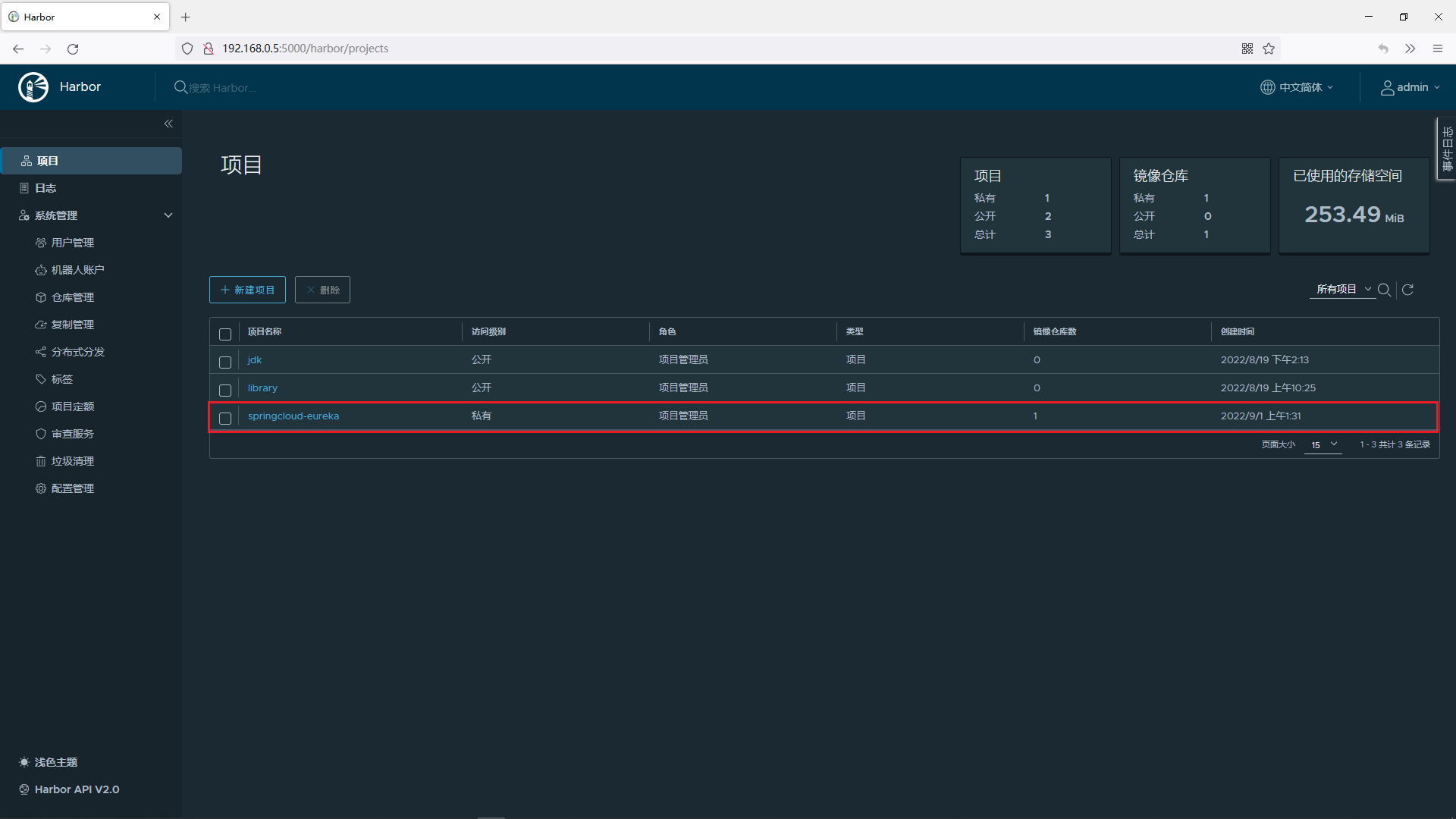

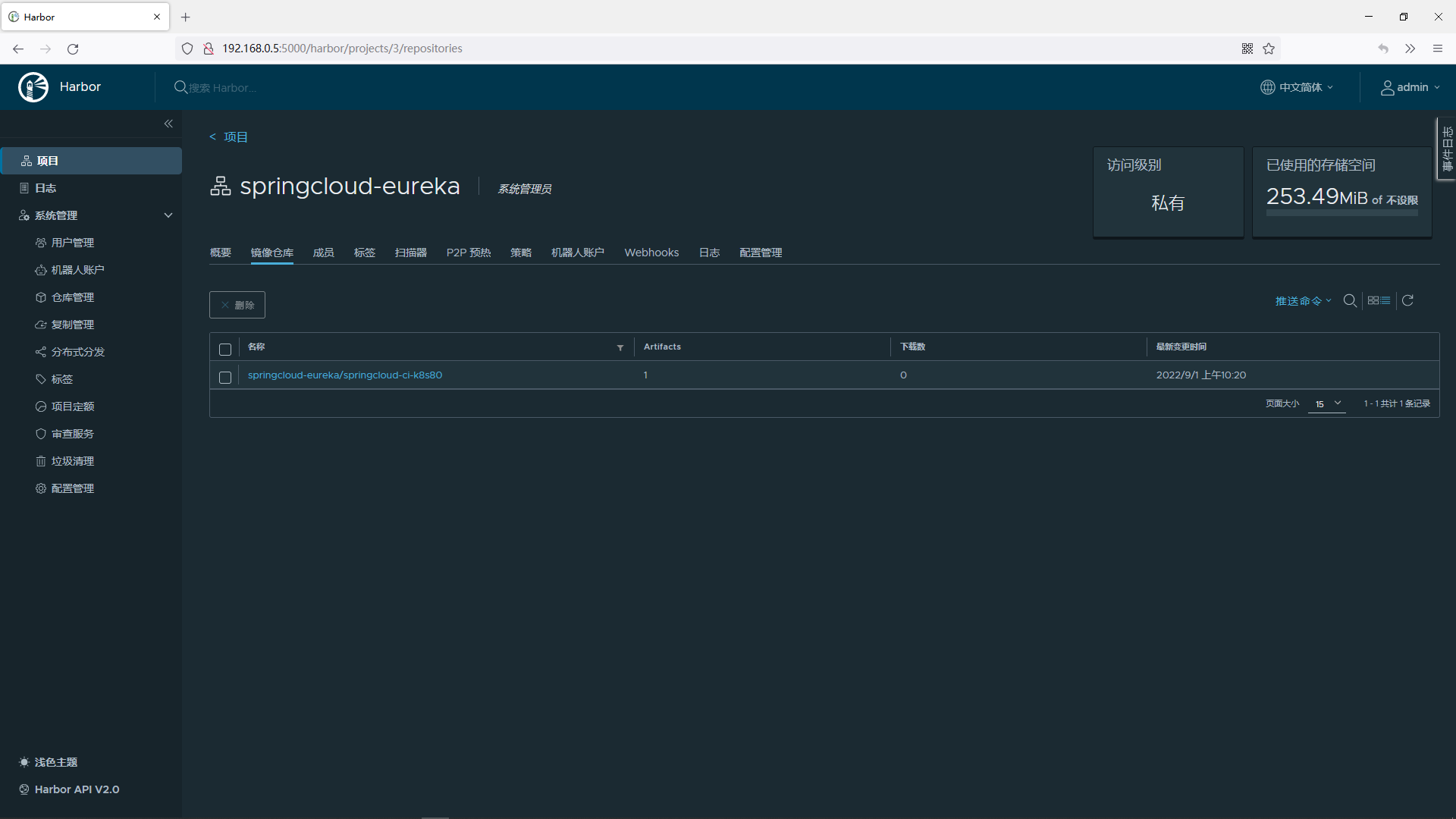

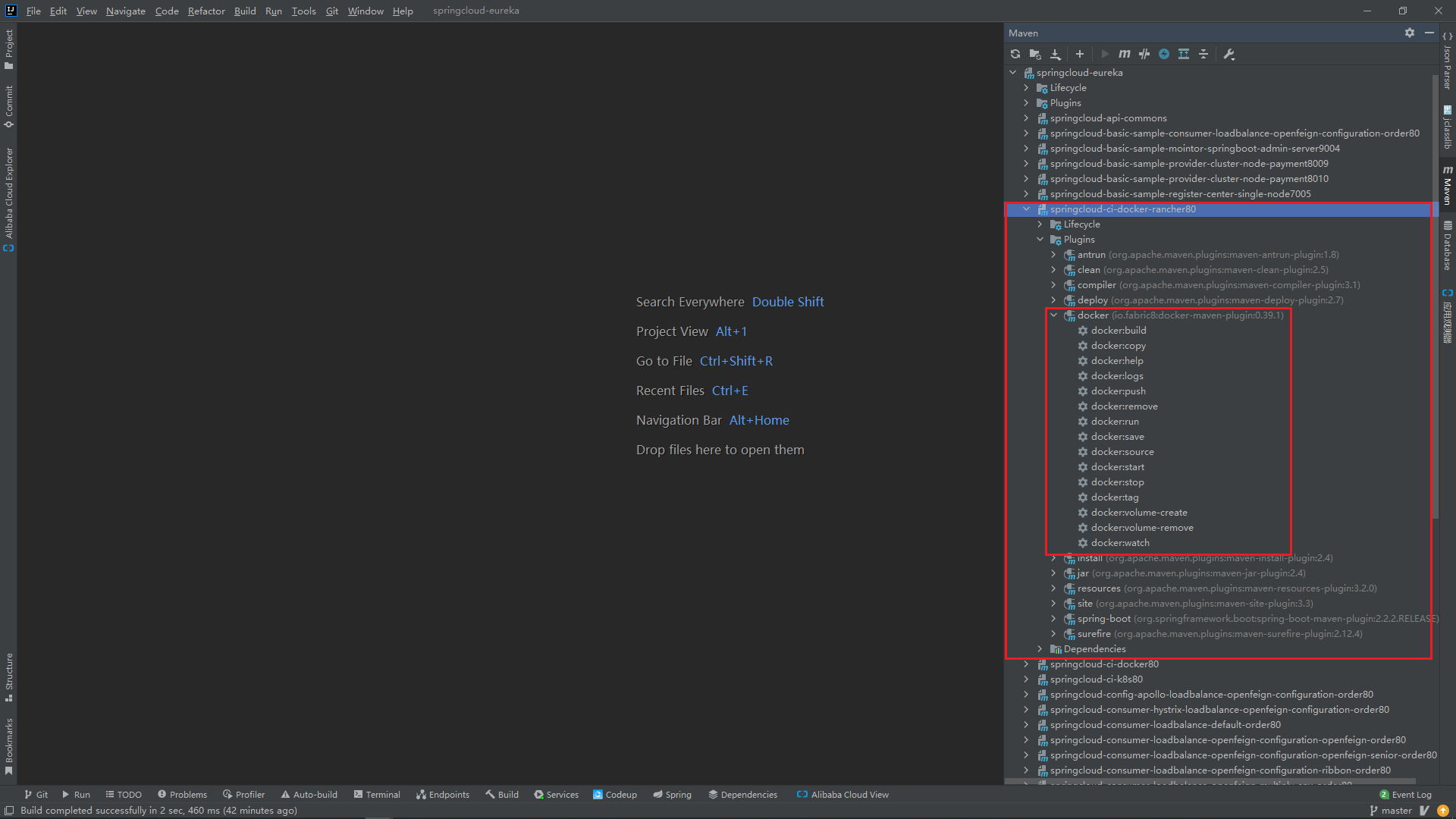

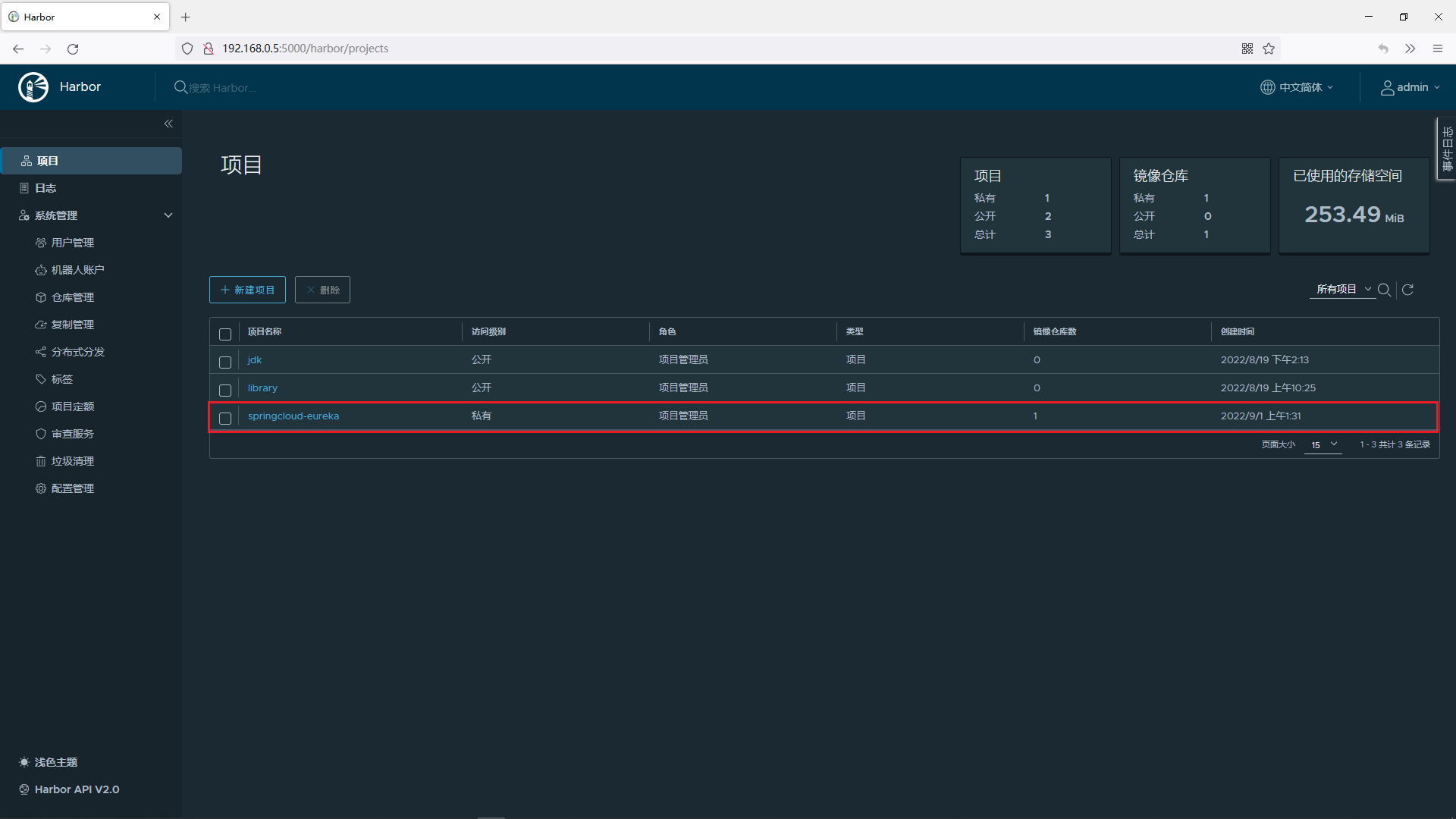

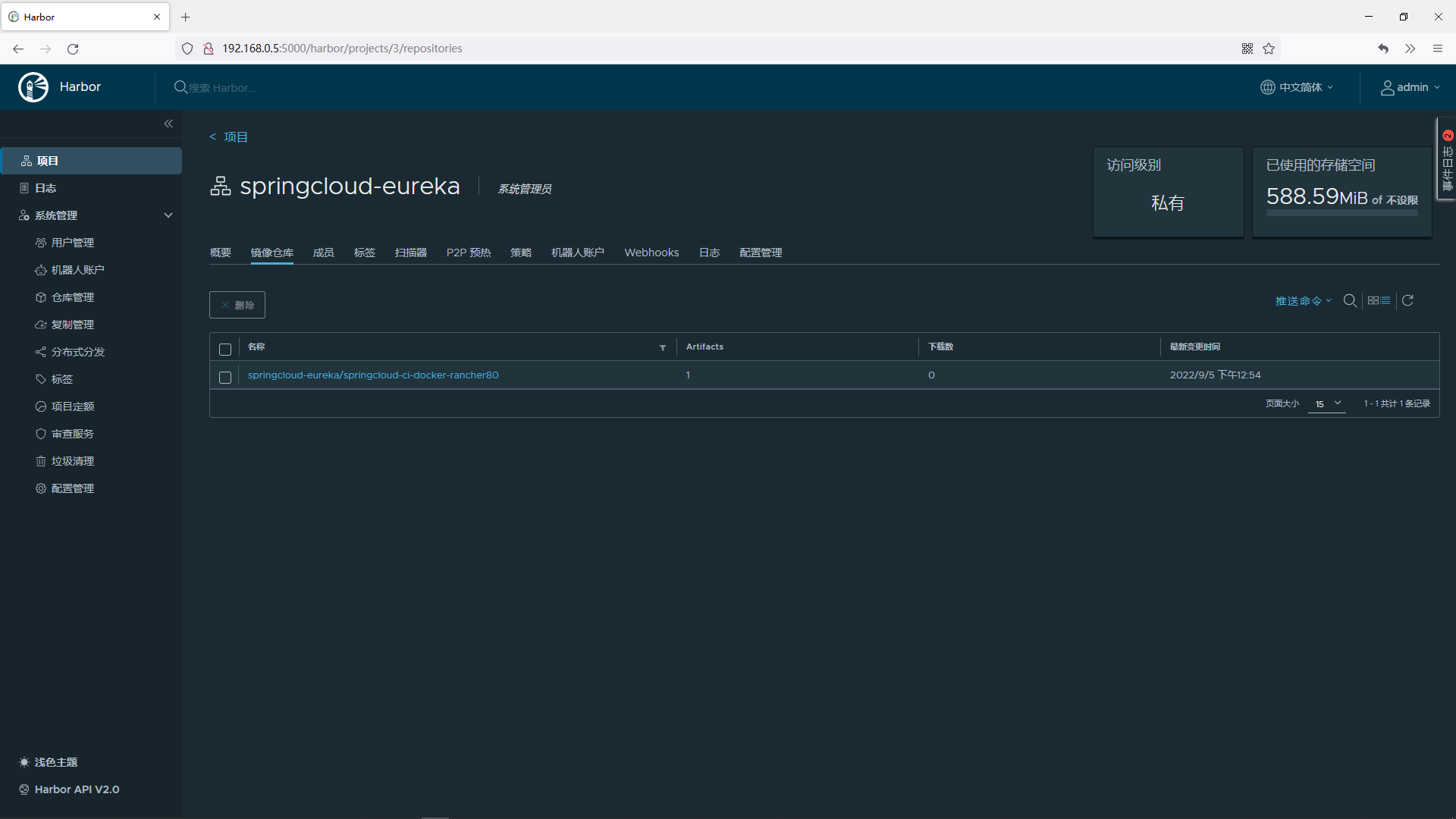

持续集成到Docker中: Docker的Maven插件 + Jenkins + Docker + Harbor

持续集成到K8s中: Docker的Maven插件 + Jenkins + Docker + Harbor + K8s

1.6.项目源代码

https://gitee.com/lingwh1995/springcloud-eureka.git

2.搭建项目基础设施

2.1.章节内容概述

本章节涉及主要内容有:

2.1.章节内容概述

2.2.章节内容大纲

2.3.创建项目父工程

2.4.创建项目依赖的公共模块

2.5.准备项目需要的数据库

2.6.配置使用热部署

具体每个小节中包含的内容可使通过下面的章节内容大纲进行查看。

2.2.章节内容大纲

2.3.创建项目父工程

2.3.1.创建父工程

在idea中创建一个名为springcloud-eureka的maven工程,创建完成后打开该工程,删除src文件夹

2.3.2.编写父工程pom.xml

pom.xml中配置主要包括两部分内容,第一是对子模块依赖的jar包和使用到的插件的版本的统一规定,第二是规定了四种不同的环境,分别是: 1.开发环境(dev) 2.测试环境(test) 3.生产环境(prod) 4.rancher测试专用环境(rancher),关于这四种环境的详细内容会在本博客的最后一部分进行详细解析说明

pom.xml

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0" xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<modelVersion>4.0.0</modelVersion>

<groupId>org.openatom</groupId>

<artifactId>springcloud-eureka</artifactId>

<version>1.0-SNAPSHOT</version>

<packaging>pom</packaging>

<!--引入所有模块:开始-->

<modules>

</modules>

<!--引入所有模块:结束-->

<!--统一定义依赖具体版本:开始 -->

<properties>

<!--依赖版本-->

<project.build.sourceEncoding>UTF-8</project.build.sourceEncoding>

<maven.compiler.source>1.8</maven.compiler.source>

<maven.compiler.target>1.8</maven.compiler.target>

<junit.version>4.12</junit.version>

<log4j.version>1.2.17</log4j.version>

<lombok.version>1.16.18</lombok.version>

<mysql.connector.version>8.0.28</mysql.connector.version>

<spring.boot.version>2.2.2.RELEASE</spring.boot.version>

<druid.spring.boot.version>1.1.10</druid.spring.boot.version>

<spring.cloud.version>Hoxton.SR1</spring.cloud.version>

<mybatis.spring.boot.version>1.3.0</mybatis.spring.boot.version>

<org.openatom.api.commons.version>1.0-SNAPSHOT</org.openatom.api.commons.version>

<com.ctrip.framework.apollo.apollo-client.version>2.0.1</com.ctrip.framework.apollo.apollo-client.version>

<io.seata.version>1.4.2</io.seata.version>

<spring.cloud.alibaba.version>2.2.0.RELEASE</spring.cloud.alibaba.version>

<net.logstash.logback.logstash-logback-encoder.version>5.2</net.logstash.logback.logstash-logback-encoder.version>

<spring.boot.admin.version>2.2.1</spring.boot.admin.version>

<!--插件版本-->

<org.springframework.boot.spring-boot-maven-plugin.version>2.2.2.RELEASE</org.springframework.boot.spring-boot-maven-plugin.version>

<org.apache.maven.plugins.maven-resources-plugin.version>3.2.0</org.apache.maven.plugins.maven-resources-plugin.version>

<io.fabric8.docker-maven-plugin.version>0.39.1</io.fabric8.docker-maven-plugin.version>

<org.apache.maven.plugins.maven-antrun-plugin.version>1.8</org.apache.maven.plugins.maven-antrun-plugin.version>

</properties>

<!--统一定义依赖具体版本:结束 -->

<!--统一定义依赖版本:开始-->

<dependencyManagement>

<dependencies>

<!--spring boot 2.2.2-->

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-dependencies</artifactId>

<version>${spring.boot.version}</version>

<type>pom</type>

<scope>import</scope>

</dependency>

<!--spring cloud Hoxton.SR1-->

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-dependencies</artifactId>

<version>${spring.cloud.version}</version>

<type>pom</type>

<scope>import</scope>

</dependency>

<!--spring cloud alibaba 2.1.0.RELEASE-->

<dependency>

<groupId>com.alibaba.cloud</groupId>

<artifactId>spring-cloud-alibaba-dependencies</artifactId>

<version>${spring.cloud.alibaba.version}</version>

<type>pom</type>

<scope>import</scope>

</dependency>

<dependency>

<groupId>mysql</groupId>

<artifactId>mysql-connector-java</artifactId>

<version>${mysql.connector.version}</version>

</dependency>

<dependency>

<groupId>org.mybatis.spring.boot</groupId>

<artifactId>mybatis-spring-boot-starter</artifactId>

<version>${mybatis.spring.boot.version}</version>

</dependency>

<dependency>

<groupId>com.alibaba</groupId>

<artifactId>druid-spring-boot-starter</artifactId>

<version>${druid.spring.boot.version}</version>

</dependency>

<dependency>

<groupId>junit</groupId>

<artifactId>junit</artifactId>

<version>${junit.version}</version>

</dependency>

<dependency>

<groupId>log4j</groupId>

<artifactId>log4j</artifactId>

<version>${log4j.version}</version>

</dependency>

<dependency>

<groupId>org.projectlombok</groupId>

<artifactId>lombok</artifactId>

<version>${lombok.version}</version>

</dependency>

<!--定义公共的工程版本-->

<dependency>

<groupId>org.openatom</groupId>

<artifactId>springcloud-api-commons</artifactId>

<version>${org.openatom.api.commons.version}</version>

</dependency>

<!--Apollo客户端-->

<dependency>

<groupId>com.ctrip.framework.apollo</groupId>

<artifactId>apollo-client</artifactId>

<version>${com.ctrip.framework.apollo.apollo-client.version}</version>

</dependency>

<!--Seata客户端-->

<dependency>

<groupId>io.seata</groupId>

<artifactId>seata-spring-boot-starter</artifactId>

<version>${io.seata.version}</version>

</dependency>

<!--springboot admin server端-->

<dependency>

<groupId>de.codecentric</groupId>

<artifactId>spring-boot-admin-starter-server</artifactId>

<version>${spring.boot.admin.version}</version>

</dependency>

<!--springboot admin client端-->

<dependency>

<groupId>de.codecentric</groupId>

<artifactId>spring-boot-admin-starter-client</artifactId>

<version>${spring.boot.admin.version}</version>

</dependency>

<!--logstah-->

<dependency>

<groupId>net.logstash.logback</groupId>

<artifactId>logstash-logback-encoder</artifactId>

<version>${net.logstash.logback.logstash-logback-encoder.version}</version>

</dependency>

</dependencies>

</dependencyManagement>

<!--统一定义依赖版本:结束-->

<!--统一定义插件版本:开始-->

<build>

<!--spring-boot-maven-plugin插件-->

<plugins>

<plugin>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-maven-plugin</artifactId>

<version>${org.springframework.boot.spring-boot-maven-plugin.version}</version>

</plugin>

<!--支持yaml读取pom的参数-->

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-resources-plugin</artifactId>

<version>${org.apache.maven.plugins.maven-resources-plugin.version}</version>

</plugin>

<!--执行maven命令时执行删除jar包和复制jar包操作-->

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-antrun-plugin</artifactId>

<version>${org.apache.maven.plugins.maven-antrun-plugin.version}</version>

</plugin>

<!--docker maven插件-->

<plugin>

<groupId>io.fabric8</groupId>

<artifactId>docker-maven-plugin</artifactId>

<version>${io.fabric8.docker-maven-plugin.version}</version>

</plugin>

</plugins>

</build>

<!--统一定义插件版本:结束-->

</project>

2.4.创建项目依赖的公共模块

2.4.1.模块目录结构

springcloud-api-commons

|-- src

| •-- main

| |-- java

| | •-- org

| | •-- openatom

| | •-- springcloud

| | •-- entities

| | |-- Account.java

| | |-- CommonResult.java

| | |-- Order.java

| | |-- Payment.java

| | •-- Storage.java

| •-- resources

| •-- application.yml

•-- pom.xml

2.4.2.创建模块

在父工程(springcloud-eureka)中创建一个名为springcloud-api-commons的maven模块,这个模块中包含了一些公共的Java实体和一些公共的插件,后面的每个模块都要引入这个公共模块,注意:当前模块创建成功后,在父工程pom.xml中<modules></modules>中会自动生成有关当前模块的信息

2.4.3.编写模块pom.xml

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<parent>

<artifactId>springcloud-eureka</artifactId>

<groupId>org.openatom</groupId>

<version>1.0-SNAPSHOT</version>

</parent>

<modelVersion>4.0.0</modelVersion>

<artifactId>springcloud-api-commons</artifactId>

<properties>

<maven.compiler.source>8</maven.compiler.source>

<maven.compiler.target>8</maven.compiler.target>

</properties>

<dependencies>

<dependency>

<groupId>org.projectlombok</groupId>

<artifactId>lombok</artifactId>

<!--是否依赖传递:true,依赖不传递,false:依赖传递-->

<optional>false</optional>

</dependency>

<!--热部署插件-->

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-devtools</artifactId>

<scope>runtime</scope>

<!--是否依赖传递:true,依赖不传递,false:依赖传递,这是maven的特性-->

<optional>false</optional>

</dependency>

</dependencies>

<!--热部署需要加这个-->

<build>

<plugins>

<plugin>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-maven-plugin</artifactId>

<configuration>

<fork>true</fork>

<addResources>true</addResources>

</configuration>

</plugin>

</plugins>

</build>

</project>

2.4.4.编写模块中实体类

Payment.java

package org.openatom.springcloud.entities;

import lombok.AllArgsConstructor;

import lombok.Data;

import lombok.NoArgsConstructor;

import java.io.Serializable;

@Data

@AllArgsConstructor

@NoArgsConstructor

public class Payment implements Serializable {

private Long id;

private String serial;

}

2.5.准备项目需要的数据库

2.5.1.安装mysql数据库

在192.168.0.5上安装mysql数据库

详细参考-> 安装mysql(8.x版本)

2.5.2.创建项目需要的数据库

导入数据库脚本(application.yml中数据库配置和mysql部署机器信息保持一致)

DROP DATABASE IF EXISTS `payment`;

CREATE DATABASE `payment`;

USE `payment`;

DROP TABLE IF EXISTS `payment`;

CREATE TABLE `payment` (

`id` bigint(20) NOT NULL AUTO_INCREMENT COMMENT 'ID',

`serial` varchar(200) DEFAULT '',

PRIMARY KEY (`id`)

) ENGINE=InnoDB AUTO_INCREMENT=2 DEFAULT CHARSET=utf8;

LOCK TABLES `payment` WRITE;

INSERT INTO `payment` VALUES (1,'15646546546');

UNLOCK TABLES;

2.6.配置使用热部署

在公共模块的pom.xml中添加热部署依赖和相关配置(上一步已经添加进去了,这里只是展示热部署部分的代码),将热部署相关插件和配置放在公共模块的好处是,其他的模块引用公共模块的时候就已经引入了热部署相关插件和配置,无需额外引入

<dependencies>

<!--热部署插件-->

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-devtools</artifactId>

<scope>runtime</scope>

<!--是否依赖传递:true,依赖不传递,false:依赖传递,这是maven的特性-->

<optional>false</optional>

</dependency>

</dependencies>

<!--热部署需要加这个-->

<build>

<plugins>

<plugin>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-maven-plugin</artifactId>

<configuration>

<fork>true</fork>

<addResources>true</addResources>

</configuration>

</plugin>

</plugins>

</build>

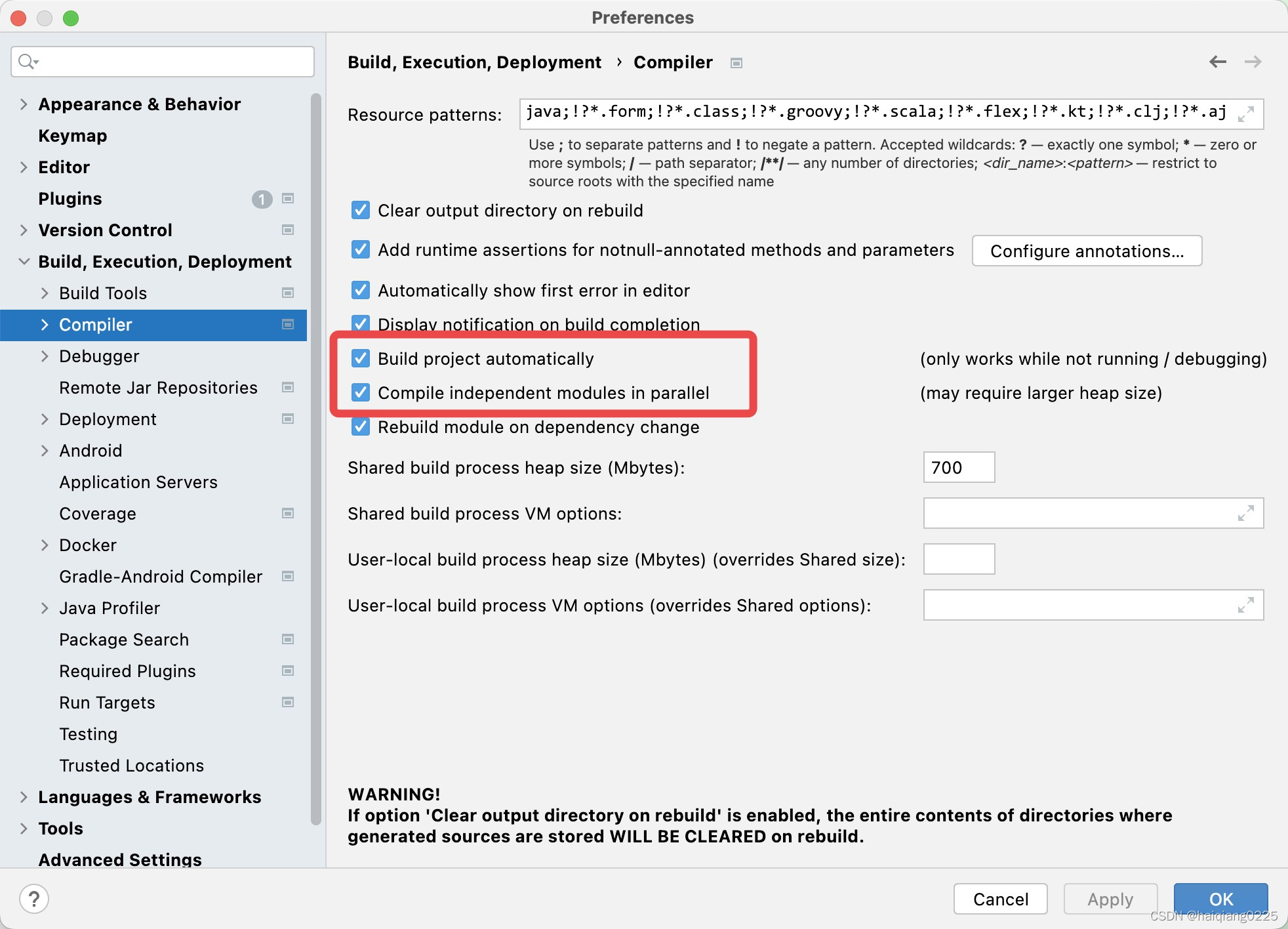

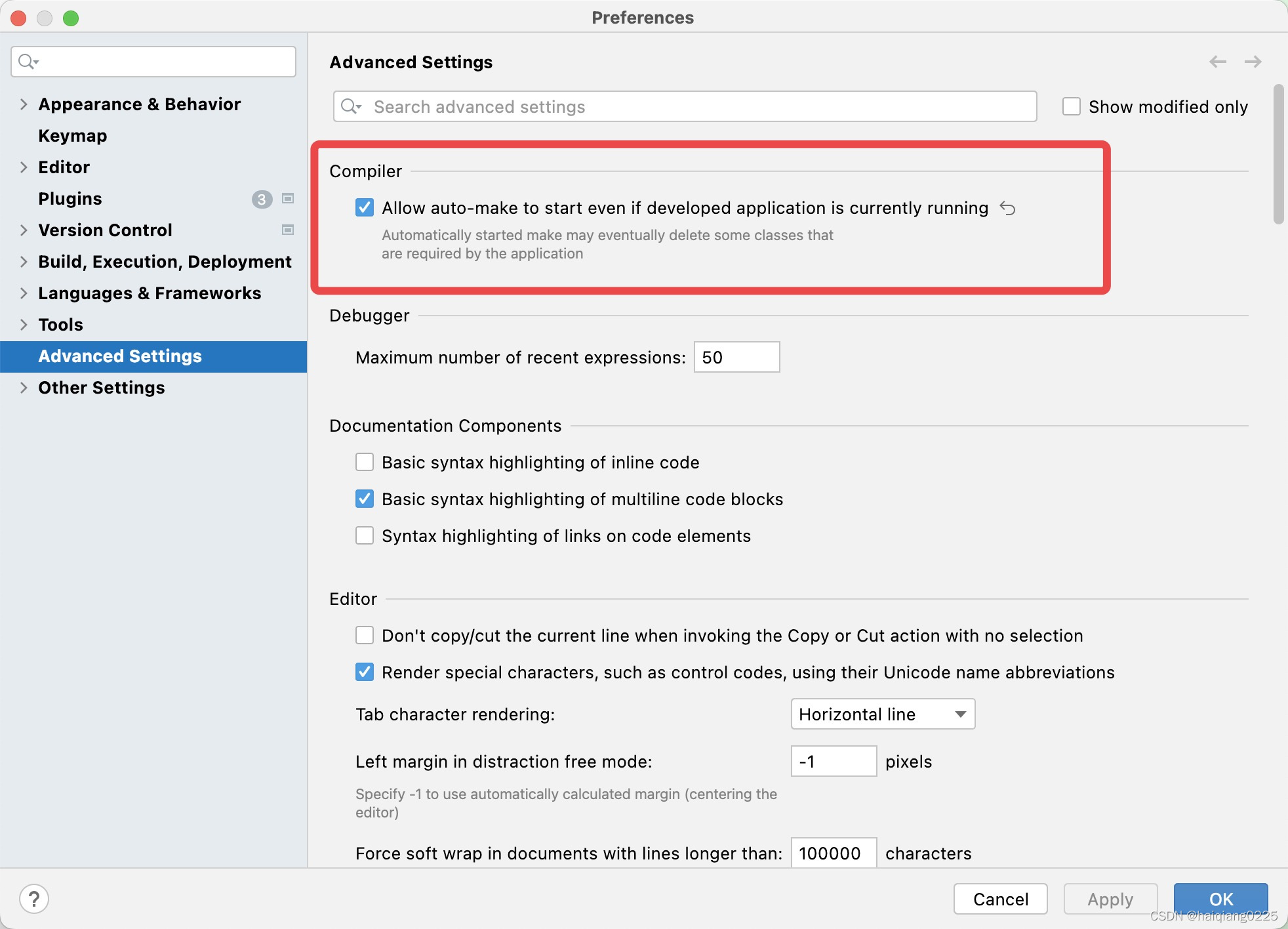

更改idea设置

热部署注意事项

开发阶段开启热部署,发布阶段一定要关闭热部署

开启热部署功能:spring.devtools.restart.enabled: true

关闭热部署功能:spring.devtools.restart.enabled: false

3.使用Eureka作为注册中心

3.1.章节内容概述

本章节涉及主要内容有:

3.1.章节内容概述

3.2.章节内容大纲

3.3.Eureka注册中心简介

3.4.搭建单节点版EUREKA注册中心

3.5.搭建集群(高可用)版EUREKA注册中心

具体每个小节中包含的内容可使通过下面的章节内容大纲进行查看。

3.2.章节内容大纲

3.3.Eureka注册中心简介

Eureka是Netflix公司开发的服务发现框架,Spring Cloud对它提供了支持,将它集成在了自己spring-cloud-netflix子项目中,用来实现Spring Cloud的服务发现功能,核心功能是为实现服务发现提供了基础支持。本次将搭建一个单节点版的Eureka注册中心和一个集群(高可用)版的Eureka注册中心,用来实现服务发现功能。

https://github.com/Netflix/eureka

https://spring.io/projects/spring-cloud-netflix

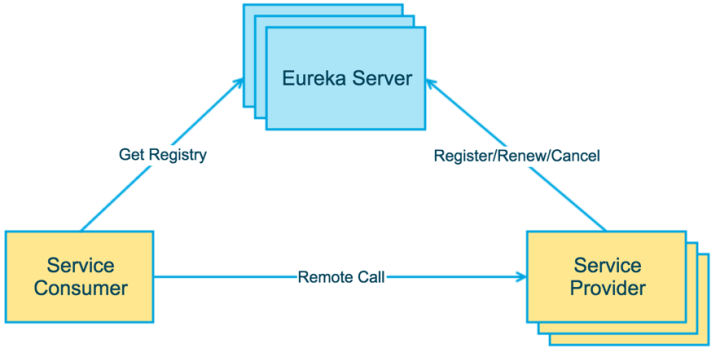

EUREKA架构图

Eureka的基础组件

服务提供者(Service Provide): 服务提供端将自身服务注册到Eureka,从而使服务消费端能够找到

服务消费者(Service Consumer): 服务消费端从Eureka获取注册服务列表,从而能够消费服务

服务中介(Eureka Server): 是服务提供者和服务消费者之间的桥梁,服务提供者可以把自己注册到服务中介那里,而服务消费者如需要消费一些服务(使用一些功能)就可以在服务中介中寻找注册在服务中介的服务提供者。

Eureka的提供了哪些功能?

服务注册(Service Register)

当Eureka客户端向Eureka Server注册时,它提供自身的元数据,比如IP地址、端口,运行状况指示符URL等

服务续约(Service Renew)

Eureka客户会每隔30秒(默认情况下)发送一次心跳来续约。通过续约来告知 Eureka Server该Eureka客户仍然存在,没有出现问题。正常情况下,如果 Eureka Server在90秒没有收到Eureka客户的续约,它会将实例从其注册表中删除

获取注册列表信息(Service Fetch Registries)

Eureka 客户端从服务器获取注册表信息,并将其缓存在本地。客户端会使用该信息查找其他服务,从而进行远程调用。该注册列表信息定期(每30 秒钟)更新一次。每次返回注册列表信息可能与Eureka客户端的缓存信息不同,Eureka客户端自动处理。如果由于某种原因导致注册列表信息不能及时匹配,Eureka 客户端则会重新获取整个注册表信息。Eureka 服务器缓存注册列表信息,整个注册表以及每个应用程序的信息进行了压缩,压缩内容和没有压缩的内容完全相同。Eureka客户端和Eureka服务器可以使用JSON/XML格式进行通讯。在默认的情况下 Eureka客户端使用压缩JSON 格式来获取注册列表的信息。

服务下线(Service Cancel)

Eureka 客户端在程序关闭时向 Eureka 服务器发送取消请求。发送请求后,该客户端实例信息将从服务器的实例注册表中删除。该下线请求不会自动完成,它需要调用以下内容:DiscoveryManager.getInstance().shutdownComponent();

服务剔除(Service Eviction)

在默认的情况下,当Eureka客户端连续90秒(3个续约周期)没有向Eureka服务器发送服务续约,即心跳,Eureka 服务器会将该服务实例从服务注册列表删除,即服务剔除。

3.4.搭建单节点版EUREKA注册中心

3.4.1.章节内容简介

搭建一个单节点版的Eureka注册中心

3.4.2.模块简介

单节点版Eureka注册中心,启动端口: 7001

3.4.3.模块目录结构

springcloud-register-center-single-node7001

|-- src

| •-- main

| |-- java

| | •-- org

| | •-- openatom

| | •-- springcloud

| | •-- RegisterCcenterSingleNode7001.java

| •-- resources

| •-- application.yml

•-- pom.xml

3.4.4.创建模块

在父工程(springcloud-eureka)中创建一个名为springcloud-register-center-single-node7001的maven模块,注意:当前模块创建成功后,在父工程pom.xml中<modules></modules>中会自动生成有关当前模块的信息

3.4.5.编写模块pom.xml

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<parent>

<artifactId>springcloud-eureka</artifactId>

<groupId>org.openatom</groupId>

<version>1.0-SNAPSHOT</version>

</parent>

<modelVersion>4.0.0</modelVersion>

<artifactId>springcloud-register-center-single-node7001</artifactId>

<properties>

<maven.compiler.source>8</maven.compiler.source>

<maven.compiler.target>8</maven.compiler.target>

</properties>

<dependencies>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-actuator</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-netflix-eureka-server</artifactId>

</dependency>

<!--引入公共的工程-->

<dependency>

<groupId>org.openatom</groupId>

<artifactId>springcloud-api-commons</artifactId>

</dependency>

</dependencies>

<!--热部署需要加这个-->

<build>

<finalName>${project.artifactId}</finalName>

<plugins>

<plugin>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-maven-plugin</artifactId>

<executions>

<execution>

<goals>

<goal>repackage</goal>

</goals>

</execution>

</executions>

<configuration>

<fork>true</fork>

<addResources>true</addResources>

</configuration>

</plugin>

</plugins>

<!--打包多环境-->

<resources>

<resource>

<directory>src/main/resources/</directory>

<includes>

<!--不区分环境:直接加载application.yml配置文件-->

<include>application.yml</include>

</includes>

</resource>

</resources>

</build>

</project>

3.4.6.编写模块application.yml

server:

port: 7001 #访问端口

spring:

application:

name: SPRINGCLOUD-REGISTER-CENTER-SINGLE-NODE7001 #注意:服务名不要出现_

devtools: #热部署开关

restart:

enabled: true

eureka:

instance:

hostname: localhost

client:

register-with-eureka: true #不向注册中心注册自己

fetch-registry: false #表示自己就是注册中心,我的职责就是维护实例,不需要去检索服务

service-url:

defaultZone: http://localhost:7001/eureka

server:

enable-self-preservation: true #是否开启自我保护,true:服务失效不直接剔除,false:服务失效直接剔除

eviction-interval-timer-in-ms: 2000 #默认发送心跳的时间间隔,单位为ms

3.4.7.编写模块主启动类

package org.openatom.springcloud;

import org.springframework.boot.SpringApplication;

import org.springframework.boot.autoconfigure.SpringBootApplication;

import org.springframework.cloud.netflix.eureka.server.EnableEurekaServer;

@SpringBootApplication

@EnableEurekaServer

public class RegisterCcenterSingleNode7001 {

public static void main(String[] args) {

SpringApplication.run(RegisterCcenterSingleNode7001.class,args);

}

}

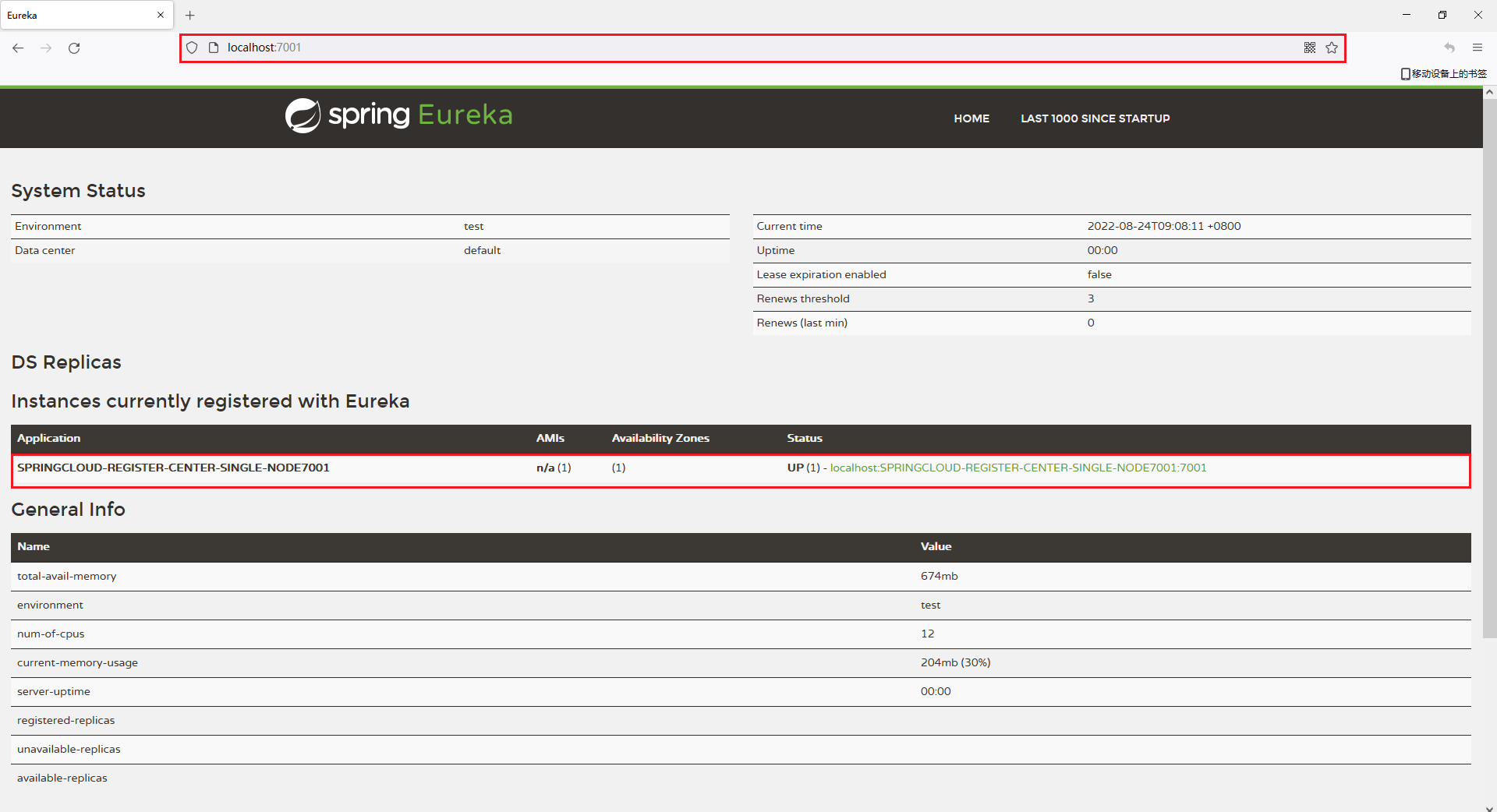

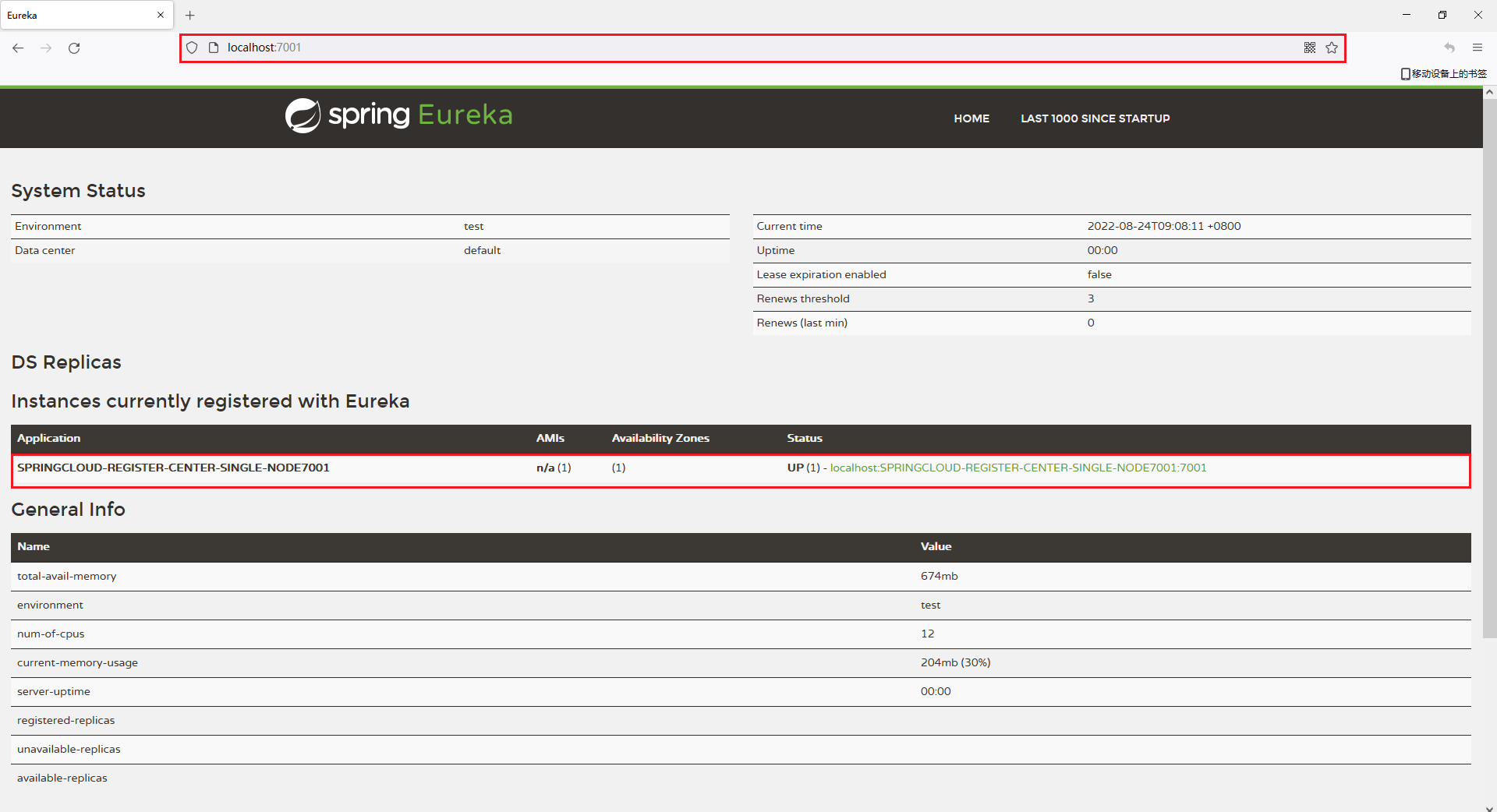

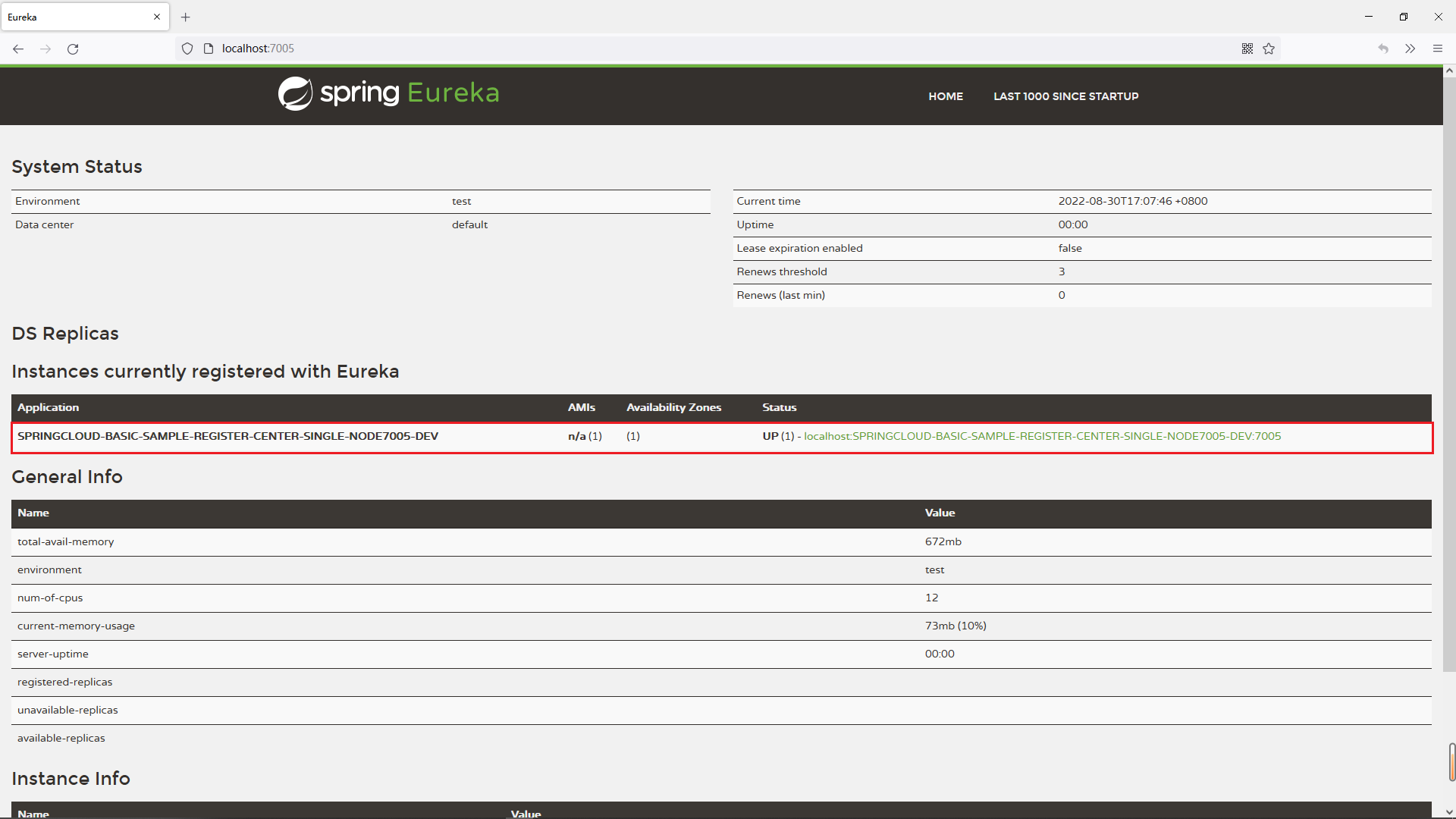

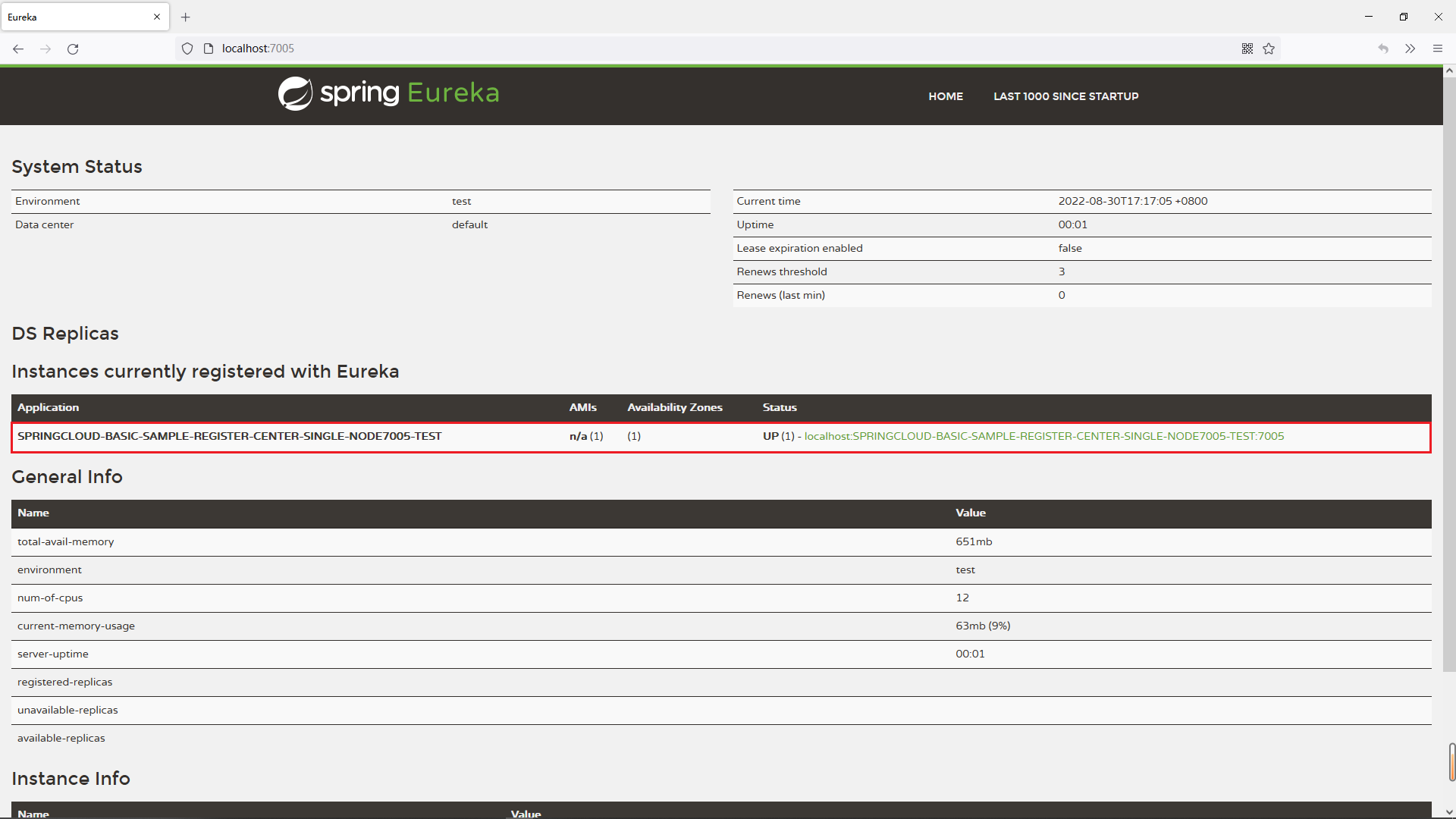

3.4.8.测试模块

在浏览器中访问

http://localhost:7001/

看到如下界面代表搭建成功

3.5.搭建集群(高可用)版EUREKA注册中心

3.5.1.章节内容简介

本章节会展示如何搭建一个集群(高可用)版的Eureka注册中心,共有三个节点,Eureka注册中心集群的原理是多个Eureka Server之间相互注册,从而组成一个集群。

3.5.2.搭建Eureka集群中第一个节点

模块简介

集群(高可用)版Eureka注册中心中第一个节点,启动端口: 7002

模块目录结构

springcloud-register-center-cluster-node7002

|-- src

| •-- main

| |-- java

| | •-- org

| | •-- openatom

| | •-- springcloud

| | •-- RegisterCcenterClusterNode7002.java

| •-- resources

| •-- application.yml

•-- pom.xml

创建模块

在父工程(springcloud-eureka)中创建一个名为springcloud-register-center-cluster-node7002的maven模块,注意:当前模块创建成功后,在父工程pom.xml中<modules></modules>中会自动生成有关当前模块的信息

编写模块pom.xml

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<parent>

<artifactId>springcloud-eureka</artifactId>

<groupId>org.openatom</groupId>

<version>1.0-SNAPSHOT</version>

</parent>

<modelVersion>4.0.0</modelVersion>

<artifactId>springcloud-register-center-cluster-node7002</artifactId>

<properties>

<maven.compiler.source>8</maven.compiler.source>

<maven.compiler.target>8</maven.compiler.target>

</properties>

<dependencies>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-actuator</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-netflix-eureka-server</artifactId>

</dependency>

<!--引入公共的工程-->

<dependency>

<groupId>org.openatom</groupId>

<artifactId>springcloud-api-commons</artifactId>

</dependency>

</dependencies>

<!--热部署需要加这个-->

<build>

<plugins>

<plugin>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-maven-plugin</artifactId>

<executions>

<execution>

<goals>

<goal>repackage</goal>

</goals>

</execution>

</executions>

<configuration>

<fork>true</fork>

<addResources>true</addResources>

</configuration>

</plugin>

</plugins>

<!--打包多环境-->

<resources>

<resource>

<directory>src/main/resources/</directory>

<includes>

<!--不区分环境:直接加载application.yml配置文件-->

<include>application.yml</include>

</includes>

</resource>

</resources>

</build>

</project>

编写模块application.yml

server:

port: 7002 #访问端口

spring:

application:

name: SPRINGCLOUD-REGISTER-CENTER-CLUSTER-NODE7002 #注意:服务名不要出现_

devtools: #热部署工具

restart:

enabled: true

eureka:

instance:

hostname: eureka7002

client:

register-with-eureka: false #不向注册中心注册自己

fetch-registry: false #表示自己就是注册中心,我的职责就是维护实例,不需要去检索服务

service-url: #把当前eureka7003注册到其他两个注册中心eureka7002、eureka7004中

defaultZone: http://eureka7003:7003/eureka,http://eureka7004:7004/eureka

server:

enable-self-preservation: false #是否开启自我保护,true:服务失效不直接剔除,false:服务失效直接剔除

eviction-interval-timer-in-ms: 2000 #默认发送心跳的时间间隔,单位为ms

编写模块主启动类

package org.openatom.springcloud;

import org.springframework.boot.SpringApplication;

import org.springframework.boot.autoconfigure.SpringBootApplication;

import org.springframework.cloud.netflix.eureka.server.EnableEurekaServer;

@SpringBootApplication

@EnableEurekaServer

public class RegisterCcenterClusterNode7002 {

public static void main(String[] args) {

SpringApplication.run(RegisterCcenterClusterNode7002.class,args);

}

}

3.5.3.搭建Eureka集群中第二个节点

模块简介

集群(高可用)版Eureka注册中心中第二个节点,启动端口: 7003

模块目录结构

springcloud-register-center-cluster-node7003

|-- src

| •-- main

| |-- java

| | •-- org

| | •-- openatom

| | •-- springcloud

| | •-- RegisterCcenterClusterNode7003.java

| •-- resources

| •-- application.yml

•-- pom.xml

创建模块

在父工程(springcloud-eureka)中创建一个名为springcloud-register-center-cluster-node7003的maven模块,注意:当前模块创建成功后,在父工程pom.xml中<modules></modules>中会自动生成有关当前模块的信息

编写模块pom.xml

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<parent>

<artifactId>springcloud-eureka</artifactId>

<groupId>org.openatom</groupId>

<version>1.0-SNAPSHOT</version>

</parent>

<modelVersion>4.0.0</modelVersion>

<artifactId>springcloud-register-center-cluster-node7003</artifactId>

<properties>

<maven.compiler.source>8</maven.compiler.source>

<maven.compiler.target>8</maven.compiler.target>

</properties>

<dependencies>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-actuator</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-netflix-eureka-server</artifactId>

</dependency>

<!--引入公共的工程-->

<dependency>

<groupId>org.openatom</groupId>

<artifactId>springcloud-api-commons</artifactId>

</dependency>

</dependencies>

<!--热部署需要加这个-->

<build>

<plugins>

<plugin>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-maven-plugin</artifactId>

<executions>

<execution>

<goals>

<goal>repackage</goal>

</goals>

</execution>

</executions>

<configuration>

<fork>true</fork>

<addResources>true</addResources>

</configuration>

</plugin>

</plugins>

<!--打包多环境-->

<resources>

<resource>

<directory>src/main/resources/</directory>

<includes>

<!--不区分环境:直接加载application.yml配置文件-->

<include>application.yml</include>

</includes>

</resource>

</resources>

</build>

</project>

编写模块application.yml

server:

port: 7003 #访问端口

spring:

application:

name: SPRINGCLOUD-REGISTER-CENTER-CLUSTER-NODE7003 #注意:服务名不要出现_

devtools: #热部署工具

restart:

enabled: true

eureka:

instance:

hostname: eureka7003

client:

register-with-eureka: false #不向注册中心注册自己

fetch-registry: false #表示自己就是注册中心,我的职责就是维护实例,不需要去检索服务

service-url: #把当前eureka7003注册到其他两个注册中心eureka7002、eureka7004中

defaultZone: http://eureka7002:7002/eureka,http://eureka7004:7004/eureka

server:

enable-self-preservation: false #是否开启自我保护,true:服务失效不直接剔除,false:服务失效直接剔除

eviction-interval-timer-in-ms: 2000 #默认发送心跳的时间间隔,单位为ms

编写模块主启动类

package org.openatom.springcloud;

import org.springframework.boot.SpringApplication;

import org.springframework.boot.autoconfigure.SpringBootApplication;

import org.springframework.cloud.netflix.eureka.server.EnableEurekaServer;

@SpringBootApplication

@EnableEurekaServer

public class RegisterCcenterClusterNode7003 {

public static void main(String[] args) {

SpringApplication.run(RegisterCcenterClusterNode7003.class,args);

}

}

3.5.4.搭建Eureka集群中第三个节点

模块简介

集群(高可用)版Eureka注册中心中第三个节点,启动端口: 7004

模块目录结构

springcloud-register-center-cluster-node7004

|-- src

| •-- main

| |-- java

| | •-- org

| | •-- openatom

| | •-- springcloud

| | •-- RegisterCcenterClusterNode7004.java

| •-- resources

| •-- application.yml

•-- pom.xml

创建模块

在父工程(springcloud-eureka)中创建一个名为springcloud-register-center-cluster-node7004的maven模块,注意:当前模块创建成功后,在父工程pom.xml中<modules></modules>中会自动生成有关当前模块的信息

编写模块pom.xml

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<parent>

<artifactId>springcloud-eureka</artifactId>

<groupId>org.openatom</groupId>

<version>1.0-SNAPSHOT</version>

</parent>

<modelVersion>4.0.0</modelVersion>

<artifactId>springcloud-register-center-cluster-node7004</artifactId>

<properties>

<maven.compiler.source>8</maven.compiler.source>

<maven.compiler.target>8</maven.compiler.target>

</properties>

<dependencies>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-actuator</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-netflix-eureka-server</artifactId>

</dependency>

<!--引入公共的工程-->

<dependency>

<groupId>org.openatom</groupId>

<artifactId>springcloud-api-commons</artifactId>

</dependency>

</dependencies>

<!--热部署需要加这个-->

<build>

<plugins>

<plugin>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-maven-plugin</artifactId>

<executions>

<execution>

<goals>

<goal>repackage</goal>

</goals>

</execution>

</executions>

<configuration>

<fork>true</fork>

<addResources>true</addResources>

</configuration>

</plugin>

</plugins>

<!--打包多环境-->

<resources>

<resource>

<directory>src/main/resources/</directory>

<includes>

<!--不区分环境:直接加载application.yml配置文件-->

<include>application.yml</include>

</includes>

</resource>

</resources>

</build>

</project>

编写模块application.yml

server:

port: 7004 #访问端口

spring:

application:

name: SPRINGCLOUD-REGISTER-CENTER-CLUSTER-NODE7004 #注意:服务名不要出现_

devtools: #热部署工具

restart:

enabled: true

eureka:

instance:

hostname: eureka7004

client:

register-with-eureka: false #不向注册中心注册自己

fetch-registry: false #表示自己就是注册中心,我的职责就是维护实例,不需要去检索服务

service-url: #把当前eureka7004注册到其他两个注册中心eureka7002、eureka7003中

defaultZone: http://eureka7002:7002/eureka,http://eureka7003:7003/eureka

server:

enable-self-preservation: false #是否开启自我保护,true:服务失效不直接剔除,false:服务失效直接剔除

eviction-interval-timer-in-ms: 10000 #默认发送心跳的时间间隔,单位为ms

编写模块主启动类

package org.openatom.springcloud;

import org.springframework.boot.SpringApplication;

import org.springframework.boot.autoconfigure.SpringBootApplication;

import org.springframework.cloud.netflix.eureka.server.EnableEurekaServer;

@SpringBootApplication

@EnableEurekaServer

public class RegisterCcenterClusterNode7004 {

public static void main(String[] args) {

SpringApplication.run(RegisterCcenterClusterNode7004.class,args);

}

}

3.5.5.配置host

修改host文件,C:\Windows\System32\drivers\etc\host

添加如下内容:

127.0.0.1 eureka7002

127.0.0.1 eureka7003

127.0.0.1 eureka7004

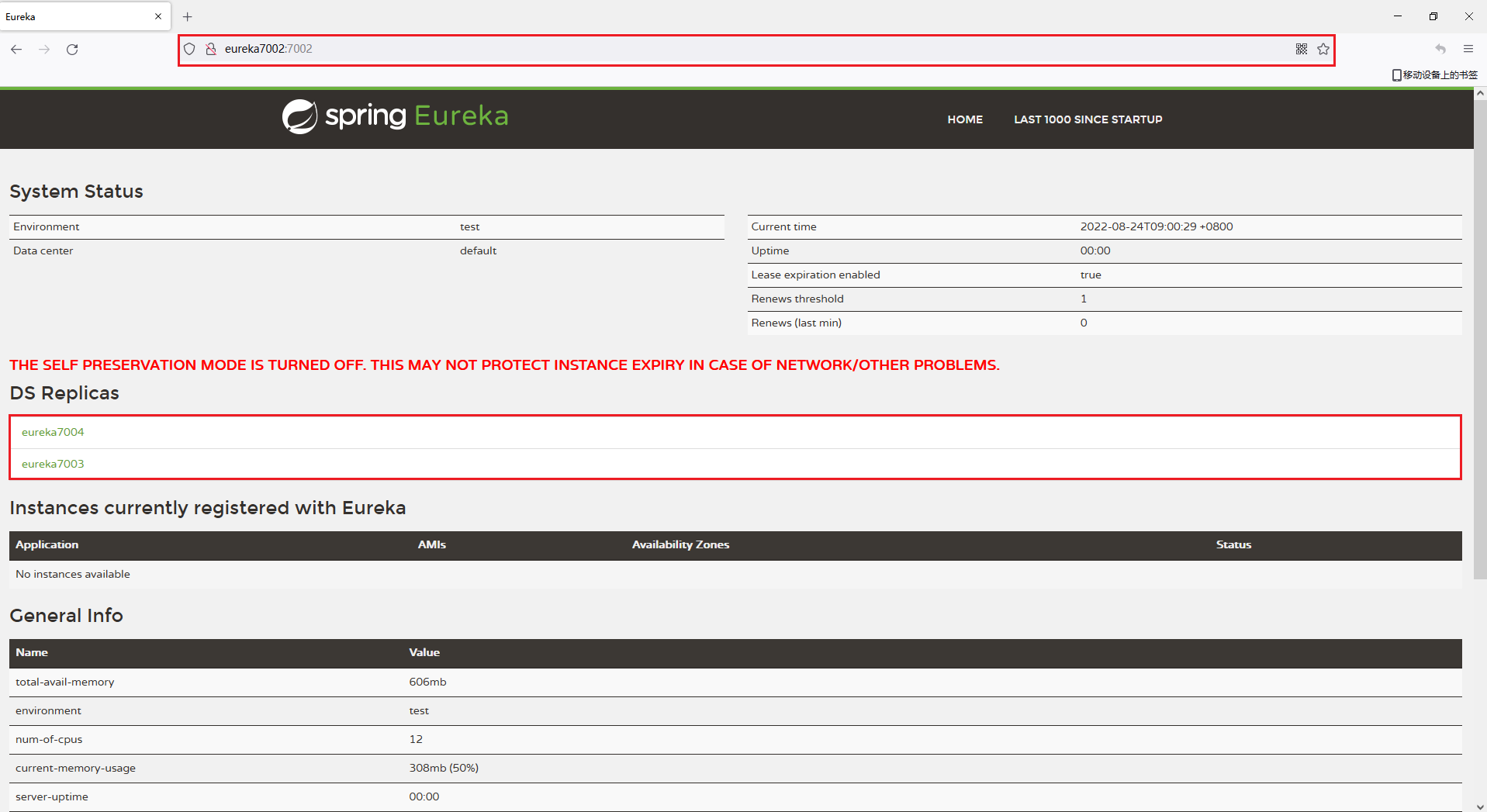

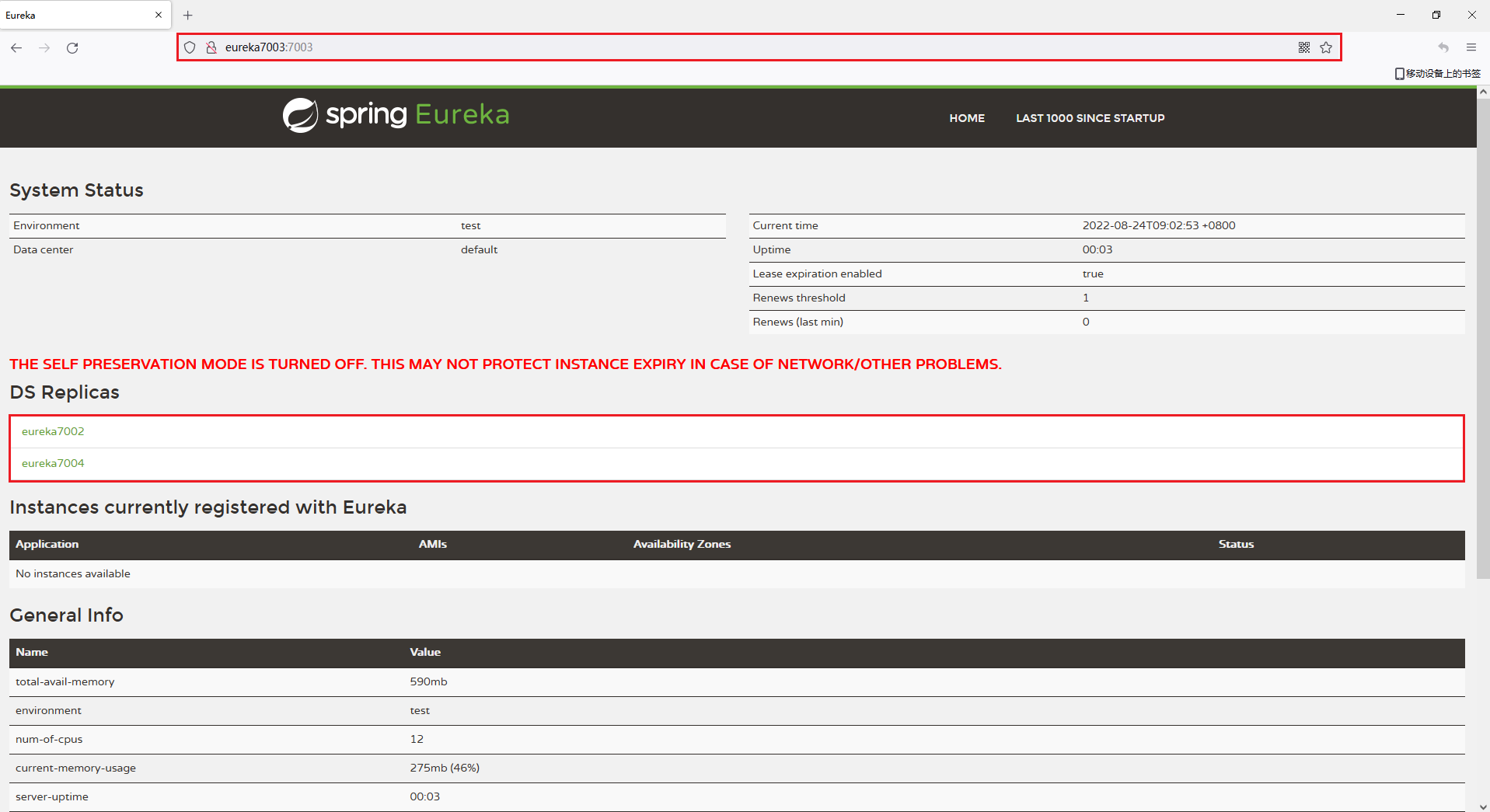

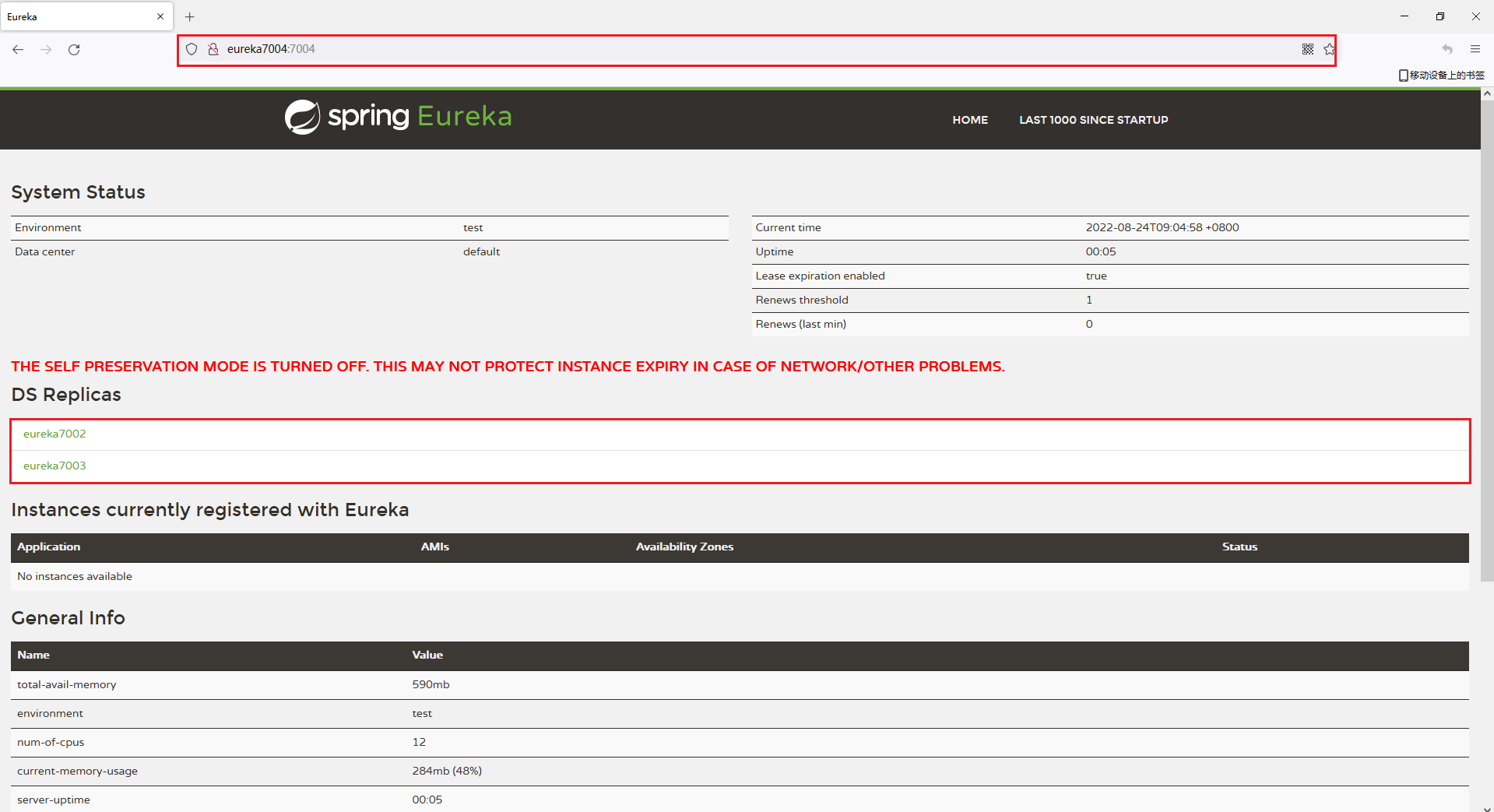

3.5.6.测试集群模块

测试集群中的第一个节点(7002),浏览器访问

http://eureka7002:7002/

测试集群中的第二个节点(7003),浏览器访问

http://eureka7003:7003/

测试集群中的第三个节点(7004),浏览器访问

http://eureka7004:7004/

可以看到,在每个节点和都和其他两个节点相互注册,这代表集群搭建成功

4.搭建第一个微服务应用

4.1.章节内容概述

本章节涉及主要内容有:

4.1.章节内容概述

4.2.章节内容大纲

4.3.第一个微服务应用简介

4.4.搭建服务提供者第一个节点

4.5.搭建服务提供者第二个节点

4.6.搭建服务消费者

4.7.启动并测试第一个微服务应用

具体每个小节中包含的内容可使通过下面的章节内容大纲进行查看。

4.2.章节内容大纲

4.3.第一个微服务应用简介

第一个微服务应用由四部分组成,分别是注册中心(单节点)、服务消费者(单节点)、服务提供者(两个节点)、运行所需要的数据库环境,这里的注册中心使用单节点版注册中心,如果需要使用集群版注册中心,只需要在application.yml将defaultZone的配置切换为集群版配置即可,服务提供者第一个节点和第二个节点是除了端口和模块名称之外其他所有代码均是相同的,之所以要创建两个相同的模块是为了模拟生产环境中一个服务部署在多个节点的情况,这里为了查看日志方便,直接创建了两个相同的服务提供者模块。

4.4.搭建服务提供者第一个节点

4.4.1.模块简介

服务提供者第一个节点,启动端口: 8001

4.4.2.模块目录结构

springcloud-provider-cluster-node-payment8001

|-- src

| •-- main

| |-- java

| | •-- org

| | •-- openatom

| | •-- springcloud

| | |-- controller

| | | •-- PaymentController.java

| | |-- dao

| | | •-- PaymentDao.java

| | |-- service

| | | |-- impl

| | | | •-- PaymentServiceImpl.java

| | | •-- PaymentService.java

| | •-- PaymentServiceProviderClusterNode8001.java

| •-- resources

| |-- mapper

| | •-- PaymentMapper.xml

| •-- application.yml

•-- pom.xml

4.4.3.创建模块

在父工程(springcloud-eureka)中创建一个名为springcloud-provider-cluster-node-payment8001的maven模块,注意:当前模块创建成功后,在父工程pom.xml中<modules></modules>中会自动生成有关当前模块的信息

4.4.4.编写模块pom.xml

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<parent>

<artifactId>springcloud-eureka</artifactId>

<groupId>org.openatom</groupId>

<version>1.0-SNAPSHOT</version>

</parent>

<modelVersion>4.0.0</modelVersion>

<artifactId>springcloud-provider-cluster-node-payment8001</artifactId>

<properties>

<maven.compiler.source>8</maven.compiler.source>

<maven.compiler.target>8</maven.compiler.target>

</properties>

<dependencies>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-actuator</artifactId>

</dependency>

<dependency>

<groupId>com.alibaba</groupId>

<artifactId>druid-spring-boot-starter</artifactId>

</dependency>

<dependency>

<groupId>org.mybatis.spring.boot</groupId>

<artifactId>mybatis-spring-boot-starter</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-jdbc</artifactId>

</dependency>

<dependency>

<groupId>mysql</groupId>

<artifactId>mysql-connector-java</artifactId>

</dependency>

<!--引入公共的工程-->

<dependency>

<groupId>org.openatom</groupId>

<artifactId>springcloud-api-commons</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-netflix-eureka-client</artifactId>

</dependency>

</dependencies>

<!--热部署需要加这个-->

<build>

<plugins>

<plugin>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-maven-plugin</artifactId>

<executions>

<execution>

<goals>

<goal>repackage</goal>

</goals>

</execution>

</executions>

<configuration>

<fork>true</fork>

<addResources>true</addResources>

</configuration>

</plugin>

</plugins>

<!--打包多环境-->

<resources>

<resource>

<directory>src/main/resources/</directory>

<includes>

<!--不区分环境:直接加载application.yml配置文件-->

<include>application.yml</include>

<!--不区分环境:直接加载PaymentMapper.xml配置文件-->

<include>mapper/*.xml</include>

</includes>

</resource>

</resources>

</build>

</project>

4.4.5.编写模块application.yml

server:

port: 8001 #访问端口

spring:

application:

name: SPRINGCLOUD-PROVIDER-PAYMENT-SERVICE-CLUSTER #注意:服务名不要出现_

devtools: #热部署开关

restart:

enabled: true

logging:

level: info

datasource:

type: com.alibaba.druid.pool.DruidDataSource # 当前数据源操作类型

driver-class-name: com.mysql.cj.jdbc.Driver # mysql驱动包

url: jdbc:mysql://192.168.0.5:3306/payment?useUnicode=true&characterEncoding=utf-8&useSSL=false&allowPublicKeyRetrieval=true

username: root

password: Mysql123456_

eureka:

client:

register-with-eureka: true #表示是否将自己注册进EurekaServer默认为true。

fetchRegistry: true #是否从EurekaServer抓取已有的注册信息,默认为true。单节点无所谓,集群必须设置为true才能配合ribbon使用负载均衡

service-url:

#单机版

defaultZone: http://localhost:7001/eureka

#集群版

#defaultZone: http://eureka7002:7002/eureka,http://eureka7003:7003/eureka,http://eureka7004:7004/eureka

instance:

instance-id: SPRINGCLOUD-PROVIDER-PAYMENT-SERVICE-CLUSTER-NODE-PAYMENT8001 #Eureka仪表盘中Instances currently registered with Eureka.Status显示的内容

prefer-ip-address: true #访问路径可以显示IP地址,点击Eureka仪表盘中Instances currently registered with Eureka.Status显示的内容地址栏是否显示IP地址

lease-renewal-interval-in-seconds: 30 #Eureka客户端向服务端发送心跳的时间间隔,单位为秒(默认是30秒)

lease-expiration-duration-in-seconds: 90 #Eureka服务端在收到最后一次心跳后等待时间上限,单位为秒(默认是90秒),超时将剔除服务

mybatis:

mapperLocations: classpath:mapper/*.xml

type-aliases-package: org.openatom.springcloud.entities # 所有Entity别名类所在包

4.4.6.编写模块Mybatis配置文件

<?xml version="1.0" encoding="UTF-8" ?>

<!DOCTYPE mapper PUBLIC "-//mybatis.org//DTD Mapper 3.0//EN" "http://mybatis.org/dtd/mybatis-3-mapper.dtd" >

<mapper namespace="org.openatom.springcloud.dao.PaymentDao">

<!--第一种写法:parameterType不写全路径-->

<insert id="create" parameterType="Payment" useGeneratedKeys="true" keyProperty="id">

insert into payment(serial) values(#{serial});

</insert>

<resultMap id="BaseResultMap" type="Payment">

<id column="id" property="id" jdbcType="BIGINT"/>

<id column="serial" property="serial" jdbcType="VARCHAR"/>

</resultMap>

<select id="getPaymentById" parameterType="Long" resultMap="BaseResultMap">

select * from payment where id=#{id};

</select>

<!--第二种写法:parameterType的写法与第一种有区别-->

<!--

<insert id="create" parameterType="org.openatom.springcloud.entities.Payment" useGeneratedKeys="true" keyProperty="id">

insert into payment(serial) values(#{serial});

</insert>

<resultMap id="BaseResultMap" type="org.openatom.springcloud.entities.Payment">

<id column="id" property="id" jdbcType="BIGINT"/>

<id column="serial" property="serial" jdbcType="VARCHAR"/>

</resultMap>

<select id="getPaymentById" parameterType="Long" resultMap="BaseResultMap">

select * from payment where id=#{id};

</select>

-->

</mapper>

4.4.7.编写模块dao

package org.openatom.springcloud.dao;

import org.apache.ibatis.annotations.Mapper;

import org.apache.ibatis.annotations.Param;

import org.openatom.springcloud.entities.Payment;

@Mapper

public interface PaymentDao {

int create(Payment payment);

Payment getPaymentById(@Param("id") Long id);

}

4.4.8.编写模块service

package org.openatom.springcloud.service;

import org.apache.ibatis.annotations.Param;

import org.openatom.springcloud.entities.Payment;

public interface PaymentService {

int create(Payment payment);

Payment getPaymentById(@Param("id") Long id);

}

4.4.9.编写模块service实现类

package org.openatom.springcloud.service.impl;

import org.openatom.springcloud.dao.PaymentDao;

import org.openatom.springcloud.service.PaymentService;

import org.springframework.stereotype.Service;

import org.openatom.springcloud.entities.Payment;

import javax.annotation.Resource;

@Service

public class PaymentServiceImpl implements PaymentService {

@Resource

private PaymentDao paymentDao;

public int create(Payment payment) {

return paymentDao.create(payment);

}

public Payment getPaymentById(Long id) {

return paymentDao.getPaymentById(id);

}

}

4.4.10.编写模块controller

package org.openatom.springcloud.controller;

import lombok.extern.slf4j.Slf4j;

import org.openatom.springcloud.service.PaymentService;

import org.springframework.beans.factory.annotation.Value;

import org.springframework.cloud.client.ServiceInstance;

import org.springframework.cloud.client.discovery.DiscoveryClient;

import org.springframework.web.bind.annotation.*;

import org.openatom.springcloud.entities.CommonResult;

import org.openatom.springcloud.entities.Payment;

import javax.annotation.Resource;

import java.util.List;

import java.util.concurrent.TimeUnit;

@RestController

@Slf4j

public class PaymentController {

@Resource

private PaymentService paymentService;

@Value("${server.port}")

private String serverPort;

//从配置文件中动态获取服务名称

@Value("${spring.application.name}")

private String APPLICATION_NAME;

@PostMapping(value = "/provider/payment/create")

public CommonResult create(@RequestBody Payment payment) {

int result = paymentService.create(payment);

log.info("*****插入结果:"+result);

if(result > 0) {

return new CommonResult(200,"插入数据库成功,serverPort: "+serverPort,result);

}else{

return new CommonResult(444,"插入数据库失败",null);

}

}

@GetMapping(value = "/provider/payment/get/{id}")

public CommonResult<Payment> getPaymentById(@PathVariable("id") Long id) {

log.info(APPLICATION_NAME + serverPort);

Payment payment = paymentService.getPaymentById(id);

if(payment != null){

return new CommonResult(200,"查询成功,serverPort: "+serverPort,payment);

}else{

return new CommonResult(444,"没有对应记录,查询ID: "+id,null);

}

}

/**

* 用来测试OpenFeign远程调用超时报异常的方法

* @return

*/

@GetMapping(value = "/provider/payment/openfeign/timeout")

public String getPaymentByIdOpenFeignTimeout() {

// 业务逻辑处理正确,但是需要耗费3秒钟

try {

TimeUnit.SECONDS.sleep(3);

} catch (InterruptedException e) {

e.printStackTrace();

}

return serverPort;

}

}

4.4.11.编写模块主启动类

package org.openatom.springcloud;

import org.springframework.boot.SpringApplication;

import org.springframework.boot.autoconfigure.SpringBootApplication;

import org.springframework.cloud.netflix.eureka.EnableEurekaClient;

/**

* 支付接口提供端

* 使用Eureka作为注册中心

*/

@EnableEurekaClient

@SpringBootApplication

public class PaymentServiceProviderClusterNode8001 {

public static void main(String[] args) {

SpringApplication.run(PaymentServiceProviderClusterNode8001.class, args);

}

}

4.5.搭建服务提供者第二个节点

4.5.1.模块简介

服务提供者第二个节点,启动端口: 8002

4.5.2.模块目录结构

springcloud-provider-cluster-node-payment8002

|-- src

| •-- main

| |-- java

| | •-- org

| | •-- openatom

| | •-- springcloud

| | |-- controller

| | | •-- PaymentController.java

| | |-- dao

| | | •-- PaymentDao.java

| | |-- service

| | | |-- impl

| | | | •-- PaymentServiceImpl.java

| | | •-- PaymentService.java

| | •-- PaymentServiceProviderClusterNode8002.java

| •-- resources

| |-- mapper

| | •-- PaymentMapper.xml

| •-- application.yml

•-- pom.xml

4.5.3.创建模块

在父工程(springcloud-eureka)中创建一个名为springcloud-provider-cluster-node-payment8002的maven模块,注意:当前模块创建成功后,在父工程pom.xml中<modules></modules>中会自动生成有关当前模块的信息

4.5.4.编写模块pom.xml

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<parent>

<artifactId>springcloud-eureka</artifactId>

<groupId>org.openatom</groupId>

<version>1.0-SNAPSHOT</version>

</parent>

<modelVersion>4.0.0</modelVersion>

<artifactId>springcloud-provider-cluster-node-payment8002</artifactId>

<properties>

<maven.compiler.source>8</maven.compiler.source>

<maven.compiler.target>8</maven.compiler.target>

</properties>

<dependencies>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-actuator</artifactId>

</dependency>

<dependency>

<groupId>com.alibaba</groupId>

<artifactId>druid-spring-boot-starter</artifactId>

</dependency>

<dependency>

<groupId>org.mybatis.spring.boot</groupId>

<artifactId>mybatis-spring-boot-starter</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-jdbc</artifactId>

</dependency>

<dependency>

<groupId>mysql</groupId>

<artifactId>mysql-connector-java</artifactId>

</dependency>

<!--引入公共的工程-->

<dependency>

<groupId>org.openatom</groupId>

<artifactId>springcloud-api-commons</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-netflix-eureka-client</artifactId>

</dependency>

</dependencies>

<!--热部署需要加这个-->

<build>

<plugins>

<plugin>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-maven-plugin</artifactId>

<executions>

<execution>

<goals>

<goal>repackage</goal>

</goals>

</execution>

</executions>

<configuration>

<fork>true</fork>

<addResources>true</addResources>

</configuration>

</plugin>

</plugins>

<!--打包多环境-->

<resources>

<resource>

<directory>src/main/resources/</directory>

<includes>

<!--不区分环境:直接加载application.yml配置文件-->

<include>application.yml</include>

<!--不区分环境:直接加载PaymentMapper.xml配置文件-->

<include>mapper/*.xml</include>

</includes>

</resource>

</resources>

</build>

</project>

4.5.5.编写模块application.yml

server:

port: 8002

spring:

application:

name: SPRINGCLOUD-PROVIDER-PAYMENT-SERVICE-CLUSTER #注意:服务名不要出现_

devtools:

restart:

enabled: true

logging:

level: info

datasource:

type: com.alibaba.druid.pool.DruidDataSource # 当前数据源操作类型

driver-class-name: com.mysql.cj.jdbc.Driver # mysql驱动包

url: jdbc:mysql://192.168.0.5:3306/payment?useUnicode=true&characterEncoding=utf-8&useSSL=false&allowPublicKeyRetrieval=true

username: root

password: Mysql123456_

eureka:

client:

register-with-eureka: true #表示是否将自己注册进EurekaServer默认为true。

fetchRegistry: true #是否从EurekaServer抓取已有的注册信息,默认为true。单节点无所谓,集群必须设置为true才能配合ribbon使用负载均衡

service-url:

#单机版

defaultZone: http://localhost:7001/eureka

#集群版

#defaultZone: http://eureka7002:7002/eureka,http://eureka7003:7003/eureka,http://eureka7004:7004/eureka

instance:

instance-id: SPRINGCLOUD-PROVIDER-PAYMENT-SERVICE-CLUSTER-NODE-PAYMENT8002 #Eureka仪表盘中Instances currently registered with Eureka.Status显示的内容

prefer-ip-address: true #访问路径可以显示IP地址,点击Eureka仪表盘中Instances currently registered with Eureka.Status显示的内容地址栏是否显示IP地址

lease-renewal-interval-in-seconds: 30 #Eureka客户端向服务端发送心跳的时间间隔,单位为秒(默认是30秒)

lease-expiration-duration-in-seconds: 90 #Eureka服务端在收到最后一次心跳后等待时间上限,单位为秒(默认是90秒),超时将剔除服务

mybatis:

mapperLocations: classpath:mapper/*.xml

type-aliases-package: org.openatom.springcloud.entities # 所有Entity别名类所在包

4.5.6.编写模块Mybatis配置文件

<?xml version="1.0" encoding="UTF-8" ?>

<!DOCTYPE mapper PUBLIC "-//mybatis.org//DTD Mapper 3.0//EN" "http://mybatis.org/dtd/mybatis-3-mapper.dtd" >

<mapper namespace="org.openatom.springcloud.dao.PaymentDao">

<!--第一种写法:parameterType不写全路径-->

<insert id="create" parameterType="Payment" useGeneratedKeys="true" keyProperty="id">

insert into payment(serial) values(#{serial});

</insert>

<resultMap id="BaseResultMap" type="Payment">

<id column="id" property="id" jdbcType="BIGINT"/>

<id column="serial" property="serial" jdbcType="VARCHAR"/>

</resultMap>

<select id="getPaymentById" parameterType="Long" resultMap="BaseResultMap">

select * from payment where id=#{id};

</select>

<!--第二种写法:parameterType的写法与第一种有区别-->

<!--

<insert id="create" parameterType="org.openatom.springcloud.entities.Payment" useGeneratedKeys="true" keyProperty="id">

insert into payment(serial) values(#{serial});

</insert>

<resultMap id="BaseResultMap" type="org.openatom.springcloud.entities.Payment">

<id column="id" property="id" jdbcType="BIGINT"/>

<id column="serial" property="serial" jdbcType="VARCHAR"/>

</resultMap>

<select id="getPaymentById" parameterType="Long" resultMap="BaseResultMap">

select * from payment where id=#{id};

</select>

-->

</mapper>

4.5.7.编写模块dao

package org.openatom.springcloud.dao;

import org.apache.ibatis.annotations.Mapper;

import org.apache.ibatis.annotations.Param;

import org.openatom.springcloud.entities.Payment;

@Mapper

public interface PaymentDao {

int create(Payment payment);

Payment getPaymentById(@Param("id") Long id);

}

4.5.8.编写模块service

package org.openatom.springcloud.service;

import org.apache.ibatis.annotations.Param;

import org.openatom.springcloud.entities.Payment;

public interface PaymentService {

int create(Payment payment);

Payment getPaymentById(@Param("id") Long id);

}

4.5.9.编写模块service实现类

package org.openatom.springcloud.service.impl;

import org.openatom.springcloud.dao.PaymentDao;

import org.openatom.springcloud.service.PaymentService;

import org.springframework.stereotype.Service;

import org.openatom.springcloud.entities.Payment;

import javax.annotation.Resource;

@Service

public class PaymentServiceImpl implements PaymentService {

@Resource

private PaymentDao paymentDao;

public int create(Payment payment) {

return paymentDao.create(payment);

}

public Payment getPaymentById(Long id) {

return paymentDao.getPaymentById(id);

}

}

4.5.10.编写模块controller

package org.openatom.springcloud.controller;

import lombok.extern.slf4j.Slf4j;

import org.openatom.springcloud.service.PaymentService;

import org.springframework.beans.factory.annotation.Value;

import org.springframework.cloud.client.ServiceInstance;

import org.springframework.cloud.client.discovery.DiscoveryClient;

import org.springframework.web.bind.annotation.*;

import org.openatom.springcloud.entities.CommonResult;

import org.openatom.springcloud.entities.Payment;

import javax.annotation.Resource;

import java.util.List;

import java.util.concurrent.TimeUnit;

@RestController

@Slf4j

public class PaymentController {

@Resource

private PaymentService paymentService;

@Value("${server.port}")

private String serverPort;

//从配置文件中动态获取服务名称

@Value("${spring.application.name}")

private String APPLICATION_NAME;

@PostMapping(value = "/provider/payment/create")

public CommonResult create(@RequestBody Payment payment) {

int result = paymentService.create(payment);

log.info("*****插入结果:"+result);

if(result > 0) {

return new CommonResult(200,"插入数据库成功,serverPort: "+serverPort,result);

}else{

return new CommonResult(444,"插入数据库失败",null);

}

}

@GetMapping(value = "/provider/payment/get/{id}")

public CommonResult<Payment> getPaymentById(@PathVariable("id") Long id) {

log.info(APPLICATION_NAME + serverPort);

Payment payment = paymentService.getPaymentById(id);

if(payment != null){

return new CommonResult(200,"查询成功,serverPort: "+serverPort,payment);

}else{

return new CommonResult(444,"没有对应记录,查询ID: "+id,null);

}

}

/**

* 用来测试OpenFeign远程调用超时报异常的方法

* @return

*/

@GetMapping(value = "/provider/payment/openfeign/timeout")

public String getPaymentByIdOpenFeignTimeout() {

// 业务逻辑处理正确,但是需要耗费3秒钟

try {

TimeUnit.SECONDS.sleep(3);

} catch (InterruptedException e) {

e.printStackTrace();

}

return serverPort;

}

}

4.5.11.编写模块主启动类

package org.openatom.springcloud;

import org.springframework.boot.SpringApplication;

import org.springframework.boot.autoconfigure.SpringBootApplication;

import org.springframework.cloud.netflix.eureka.EnableEurekaClient;

/**

* 支付接口提供端

* 使用Eureka作为注册中心

*/

@EnableEurekaClient

@SpringBootApplication

public class PaymentServiceProviderClusterNode8002 {

public static void main(String[] args) {

SpringApplication.run(PaymentServiceProviderClusterNode8002.class, args);

}

}

4.6.搭建服务消费者

4.6.1.模块简介

基于SpringCloud官方默认组件实现的服务消费者,启动端口: 80

4.6.2.模块目录结构

@include(./projects/springcloud-eureka/springcloud-consumer-loadbalance-default-order80/tree.md)

4.6.3.创建模块

在父工程(springcloud-eureka)中创建一个名为springcloud-consumer-loadbalance-default-order80的maven模块,注意:当前模块创建成功后,在父工程pom.xml中<modules></modules>中会自动生成有关当前模块的信息

4.6.4.编写模块pom.xml

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<parent>

<artifactId>springcloud-eureka</artifactId>

<groupId>org.openatom</groupId>

<version>1.0-SNAPSHOT</version>

</parent>

<modelVersion>4.0.0</modelVersion>

<artifactId>springcloud-consumer-loadbalance-default-order80</artifactId>

<properties>

<maven.compiler.source>8</maven.compiler.source>

<maven.compiler.target>8</maven.compiler.target>

</properties>

<dependencies>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-actuator</artifactId>

</dependency>

<!--引入公共的工程-->

<dependency>

<groupId>org.openatom</groupId>

<artifactId>springcloud-api-commons</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-netflix-eureka-client</artifactId>

</dependency>

</dependencies>

<!--热部署需要加这个-->

<build>

<plugins>

<plugin>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-maven-plugin</artifactId>

<executions>

<execution>

<goals>

<goal>repackage</goal>

</goals>

</execution>

</executions>

<configuration>

<fork>true</fork>

<addResources>true</addResources>

</configuration>

</plugin>

</plugins>

<!--打包多环境-->

<resources>

<resource>

<directory>src/main/resources/</directory>

<includes>

<!--不区分环境:直接加载application.yml配置文件-->

<include>application.yml</include>

</includes>

</resource>

</resources>

</build>

</project>

4.6.5.编写模块application.yml

server:

port: 80

spring:

application:

name: SPRINGCLOUD-CONSUMER-LOADBALANCE-DEFAULT-ORDER80 #注意:服务名不要出现_

devtools:

restart:

enabled: true

logging:

level: info

eureka:

client:

register-with-eureka: true #表示是否将自己注册进EurekaServer默认为true。

fetchRegistry: true #是否从EurekaServer抓取已有的注册信息,默认为true。服务提供端是单节点无所谓,是集群必须设置为true才能配合ribbon使用负载均衡,否则报异常No instances available for SPRINGCLOUD-PROVIDER-PAYMENT-SERVICE-CLUSTER

service-url:

#单机版

defaultZone: http://localhost:7001/eureka

#集群版

#defaultZone: http://eureka7002:7002/eureka,http://eureka7003:7003/eureka,http://eureka7004:7004/eureka

instance:

instance-id: ${spring.application.name} #Eureka仪表盘中Instances currently registered with Eureka.Status显示的内容

prefer-ip-address: false #访问路径可以显示IP地址,点击Eureka仪表盘中Instances currently registered with Eureka.Status显示的内容地址栏是否显示IP地址

#服务提供端信息

service:

provider:

name: SPRINGCLOUD-PROVIDER-PAYMENT-SERVICE-CLUSTER #服务提供端名称

url: http://${service.provider.name} #服务提供端调用地址

4.6.6.编写模块config

package org.openatom.springcloud.config;

import org.springframework.cloud.client.loadbalancer.LoadBalanced;

import org.springframework.context.annotation.Bean;

import org.springframework.context.annotation.Configuration;

import org.springframework.web.client.RestTemplate;

@Configuration

public class ApplicationContextConfig {

@Bean

//必须加这个注解,不加这个注解访问会报错

@LoadBalanced

public RestTemplate getRestTemplate() {

return new RestTemplate();

}

}

4.6.7.编写模块controller

package org.openatom.springcloud.controller;

import lombok.extern.slf4j.Slf4j;

import org.springframework.beans.factory.annotation.Value;

import org.springframework.http.ResponseEntity;

import org.springframework.web.bind.annotation.GetMapping;

import org.springframework.web.bind.annotation.PathVariable;

import org.springframework.web.bind.annotation.RestController;

import org.springframework.web.client.RestTemplate;

import org.openatom.springcloud.entities.CommonResult;

import org.openatom.springcloud.entities.Payment;

import javax.annotation.Resource;

@RestController

@Slf4j

public class OrderConsumerController {

//单机版

// public static final String PAYMENT_URL = "http://localhost:8001";

// public static final String PAYMENT_URL = "http://localhost:8002";

//集群版

//从配置文件中动态获取远程调用地址

@Value("${service.provider.url}")

private String SERVICE_PROVIDER_URL;

//从配置文件中动态获服务提供端名称

@Value("${service.provider.name}")

private String SERVICE_PROVIDER_NAME;

@Resource

private RestTemplate restTemplate;

@GetMapping("/consumer/payment/create")

public CommonResult<Payment> create(Payment payment) {

return restTemplate.postForObject(SERVICE_PROVIDER_URL +"/provider/payment/create",payment, CommonResult.class);

}

@GetMapping("/consumer/payment/get/{id}")

public CommonResult<Payment> getPaymentByIdReturnObject(@PathVariable("id") Long id){

return restTemplate.getForObject(SERVICE_PROVIDER_URL+"/provider/payment/get/"+id,CommonResult.class);

}

@GetMapping("/consumer/payment/getForEntity/{id}")

public CommonResult<Payment> getPaymentByIdReturnResponseEntity(@PathVariable("id") Long id) {

ResponseEntity<CommonResult> entity = restTemplate.getForEntity(SERVICE_PROVIDER_URL+"/provider/payment/get/"+id,CommonResult.class);

if(entity.getStatusCode().is2xxSuccessful()){

return entity.getBody();

}else{

return new CommonResult<>(444,"操作失败");

}

}

}

4.6.8.编写模块主启动类

package org.openatom.springcloud;

import org.springframework.boot.SpringApplication;

import org.springframework.boot.autoconfigure.SpringBootApplication;

import org.springframework.cloud.netflix.eureka.EnableEurekaClient;

/**

* 使用SpringCloud自带的负载均衡组件

* 1.每个节点处理请求的权重相同,SpringCloud自带的负载均衡组件只有轮询这一种负载均衡算法

* 2.使用时只需要在注入RestTemplate时加上@LoadBalanced这个注解,不加这个注解会报错

*/

@SpringBootApplication

@EnableEurekaClient

public class OrderServiceConsumerLoadBalanceDefault80 {

public static void main(String[] args) {

SpringApplication.run(OrderServiceConsumerLoadBalanceDefault80.class, args);

}

}

4.7.启动并测试第一个微服务应用

4.7.1.启动第一个微服务应用

4.7.2.测试第一个微服务应用

在浏览器中访问

http://localhost/consumer/payment/get/1

第一次访问返回结果

{"code":200,"message":"查询成功,serverPort: 8001","data":{"id":1,"serial":"15646546546"}}

第二次访问返回结果

{"code":200,"message":"查询成功,serverPort: 8002","data":{"id":1,"serial":"15646546546"}}

第三次访问返回结果

{"code":200,"message":"查询成功,serverPort: 8001","data":{"id":1,"serial":"15646546546"}}

第四次访问返回结果

{"code":200,"message":"查询成功,serverPort: 8002","data":{"id":1,"serial":"15646546546"}}

可以看到四次访问返回的结果中,第一次和第三次是相同的,第二次和第四次是相同的,之所以会出现这样的结果,是因为上面编写RestTemplate时使用了默认的配置,默认的配置使用负载均衡策略是轮询策略,所以接连访问该服务四次会出现上面的情况。

5.使用Ribbon实现客户端负载均衡

5.1.章节内容概述

本章节涉及主要内容有:

5.1.章节内容概述

5.2.章节内容大纲

5.3.Ribbon简介

5.4.硬编码配置方式使用Ribbon实现负载均衡(使用Ribbon自带的负载均衡策略)

5.5.声明式配置方式使用Ribbon实现负载均衡(使用Ribbon自带的负载均衡策略)

5.6.硬编码配置方式使用Ribbon实现负载均衡(使用自定义的Ribbon负载均衡策略)

5.7.声明式配置方式使用Ribbon实现负载均衡(使用自定义的Ribbon负载均衡策略)

具体每个小节中包含的内容可使通过下面的章节内容大纲进行查看。

5.2.章节内容大纲

5.3.Ribbon简介

Ribbon是Netflix发布的开源项目,主要功能是提供客户端的软件负载均衡算法,将Netflix的中间层服务连接在一起。Ribbon客户端组件提供一系列完善的配置项如连接超时,重试等。简单的说,就是在配置文件中列出Load Balancer(简称LB)后面所有的机器,Ribbon会自动的帮助你基于某种规则(如简单轮询,随即连接等)去连接这些机器,也可以使用Ribbon实现自定义的负载均衡算法。

https://github.com/Netflix/ribbon

5.4.硬编码配置方式使用Ribbon实现负载均衡(使用Ribbon自带的负载均衡策略)

5.4.1.模块简介

基于Ribbon以硬编码配置方式实现的服务消费者,使用Ribbon自带的负载均衡策略,启动端口: 80

5.4.2.模块目录结构

springcloud-consumer-loadbalance-ribbon-hardcode-order80

|-- src

| •-- main

| |-- java

| | •-- org

| | •-- openatom

| | |-- myrule

| | | •-- MySelfRule.java

| | •-- springcloud

| | |-- config

| | | •-- ApplicationContextConfig.java

| | |-- controller

| | | •-- OrderConsumerController.java

| | •-- OrderServiceConsumerLoadBalanceRibbonHardcode80.java

| •-- resources

| •-- application.yml

•-- pom.xml

5.4.3.创建模块

在父工程(springcloud-eureka)中创建一个名为springcloud-consumer-loadbalance-ribbon-hardcode-order80的maven模块,注意:当前模块创建成功后,在父工程pom.xml中<modules></modules>中会自动生成有关当前模块的信息

5.4.4.编写模块pom.xml

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<parent>

<artifactId>springcloud-eureka</artifactId>

<groupId>org.openatom</groupId>

<version>1.0-SNAPSHOT</version>

</parent>

<modelVersion>4.0.0</modelVersion>

<artifactId>springcloud-consumer-loadbalance-ribbon-hardcode-order80</artifactId>

<properties>

<maven.compiler.source>8</maven.compiler.source>

<maven.compiler.target>8</maven.compiler.target>

</properties>

<dependencies>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-actuator</artifactId>

</dependency>

<!--引入公共的工程-->

<dependency>

<groupId>org.openatom</groupId>

<artifactId>springcloud-api-commons</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-netflix-eureka-client</artifactId>

</dependency>

</dependencies>

<build>

<plugins>

<!--热部署需要加这个-->

<plugin>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-maven-plugin</artifactId>

<executions>

<execution>

<goals>

<goal>repackage</goal>

</goals>

</execution>

</executions>

<configuration>

<fork>true</fork>

<addResources>true</addResources>

</configuration>

</plugin>

</plugins>

<!--打包多环境-->

<resources>

<resource>

<directory>src/main/resources/</directory>

<includes>

<!--不区分环境:直接加载application.yml配置文件-->

<include>application.yml</include>

</includes>

</resource>

</resources>

</build>

</project>

5.4.5.编写模块application.yml

server:

port: 80

spring:

application:

name: SPRINGCLOUD-CONSUMER-LOADBALANCE-RIBBON-HARDCODE-ORDER80 #注意:服务名不要出现_

devtools:

restart:

enabled: true

logging:

level: info

eureka:

client:

register-with-eureka: true #表示是否将自己注册进EurekaServer默认为true。

fetchRegistry: true #是否从EurekaServer抓取已有的注册信息,默认为true。服务提供端是单节点无所谓,是集群必须设置为true才能配合ribbon使用负载均衡,否则报异常No instances available for SPRINGCLOUD-PROVIDER-PAYMENT-SERVICE-CLUSTER

service-url:

#单机版

defaultZone: http://localhost:7001/eureka

#集群版

#defaultZone: http://eureka7002:7002/eureka,http://eureka7003:7003/eureka,http://eureka7004:7004/eureka

instance:

instance-id: ${spring.application.name} #Eureka仪表盘中Instances currently registered with Eureka.Status显示的内容

prefer-ip-address: false #访问路径可以显示IP地址,点击Eureka仪表盘中Instances currently registered with Eureka.Status显示的内容地址栏是否显示IP地址

#服务提供端信息

service:

provider:

name: SPRINGCLOUD-PROVIDER-PAYMENT-SERVICE-CLUSTER

url: http://${service.provider.name} #服务提供端名称

5.4.6.编写模块config

package org.openatom.springcloud.config;

import org.springframework.cloud.client.loadbalancer.LoadBalanced;

import org.springframework.context.annotation.Bean;

import org.springframework.context.annotation.Configuration;

import org.springframework.web.client.RestTemplate;

@Configuration

public class ApplicationContextConfig {

@Bean

//必须加这个注解,不加这个注解访问会报错

@LoadBalanced

public RestTemplate getRestTemplate() {

return new RestTemplate();

}

}

5.4.7.编写模块controller

package org.openatom.springcloud.controller;

import lombok.extern.slf4j.Slf4j;

import org.springframework.beans.factory.annotation.Value;

import org.springframework.http.ResponseEntity;

import org.springframework.web.bind.annotation.GetMapping;

import org.springframework.web.bind.annotation.PathVariable;

import org.springframework.web.bind.annotation.RestController;

import org.springframework.web.client.RestTemplate;

import org.openatom.springcloud.entities.CommonResult;

import org.openatom.springcloud.entities.Payment;

import javax.annotation.Resource;

@RestController

@Slf4j

public class OrderConsumerController {

//单机版

// public static final String PAYMENT_URL = "http://localhost:8001";

// public static final String PAYMENT_URL = "http://localhost:8002";

//集群版

//从配置文件中动态获取远程调用地址

@Value("${service.provider.url}")

private String SERVICE_PROVIDER_URL;

//从配置文件中动态获服务提供端名称

@Value("${service.provider.name}")

private String SERVICE_PROVIDER_NAME;

@Resource

private RestTemplate restTemplate;

@GetMapping("/consumer/payment/create")

public CommonResult<Payment> create(Payment payment) {

return restTemplate.postForObject(SERVICE_PROVIDER_URL +"/provider/payment/create",payment, CommonResult.class);

}

@GetMapping("/consumer/payment/get/{id}")

public CommonResult<Payment> getPaymentByIdReturnObject(@PathVariable("id") Long id){

return restTemplate.getForObject(SERVICE_PROVIDER_URL+"/provider/payment/get/"+id,CommonResult.class);

}

@GetMapping("/consumer/payment/getForEntity/{id}")

public CommonResult<Payment> getPaymentByIdReturnResponseEntity(@PathVariable("id") Long id) {

ResponseEntity<CommonResult> entity = restTemplate.getForEntity(SERVICE_PROVIDER_URL+"/provider/payment/get/"+id,CommonResult.class);

if(entity.getStatusCode().is2xxSuccessful()){

return entity.getBody();

}else{

return new CommonResult<>(444,"操作失败");

}

}

}

5.4.8.编写负载均衡规则配置类

package org.openatom.myrule;

import com.netflix.loadbalancer.IRule;

import com.netflix.loadbalancer.RandomRule;

import org.springframework.context.annotation.Bean;

import org.springframework.context.annotation.Configuration;

/**

* 自定义Ribbon负载均衡规则,这个MySelfRule编写后在主启动类使用

*/

@Configuration

public class MySelfRule {

@Bean

public IRule myRule() {

return new RandomRule();//定义为随机

}

}

这里使用return new RandomRule();,这代表使用的负载均衡算法是RandomRule,Ribbon默认提供了七种负载均衡的算法策略,具体使用哪一种,请根据实际需求灵活选择,这里提供关于七种负载均衡算法的介绍

RoundRobinRule(轮询策略,轮询是Ribbon默认使用的负载均衡算法)

第一次到A,第二次就到B,第三次又到A,第四次又到B......

具体实现是一个负载均衡算法: 第N次请求 % 服务器集群的总数 = 实际调用服务器位置的下标

RandomRule(随机策略)

从服务提供者的列表中随机选择一个服务实例进行调用

RetryRule(轮询重试策略)

按照轮询策略来获取服务,如果获取的服务实例为null或已经失效,则在指定的时间之内不断地进行重试来获取服务,如果超过指定时间依然没获取到服务实例则返回null。

WeightedResponseTimeRule(响应速度决定权重策略)

根据每个服务提供者的响应时间分配一个权重,响应时间越长,权重越小,被选中的可能性也就越低。它的实现原理是,刚开始使用轮询策略并开启一个计时器,每一段时间收集一次所有服务提供者的平均响应时间,然后再给每个服务提供者附上一个权重,权重越高被选中的概率也越大。

BestAvailableRule(最优可用策略)

判断最优其实用的是并发连接数。选择并发连接数较小的server发送请求。

AvailabilityFilteringRule(可用性敏感策略)

先过滤掉非健康的服务实例,然后再选择连接数较小的服务实例。

ZoneAvoidanceRule(区域内可用性能最优策略)

基于AvailabilityFilteringRule基础上做的,首先判断一个zone的运行性能是否可用.剔除不可用的区域zone的所有server,然后再利用AvailabilityPredicate过滤并发连接过多的server。

5.4.9.编写模块主启动类

package org.openatom.springcloud;

import org.openatom.myrule.MySelfRule;

import org.springframework.boot.SpringApplication;

import org.springframework.boot.autoconfigure.SpringBootApplication;

import org.springframework.cloud.netflix.eureka.EnableEurekaClient;

import org.springframework.cloud.netflix.ribbon.RibbonClient;

/**

* 使用Ribbon实现负载均衡:Java硬编码方式

*/

@SpringBootApplication

@EnableEurekaClient

@RibbonClient(name = "SPRINGCLOUD-PROVIDER-PAYMENT-SERVICE-CLUSTER",configuration= MySelfRule.class)

public class OrderServiceConsumerLoadBalanceRibbonHardcode80 {

public static void main(String[] args) {

SpringApplication.run(OrderServiceConsumerLoadBalanceRibbonHardcode80.class, args);

}

}

5.4.10.测试模块

启动相关服务

测试硬编码配置方式使用Ribbon实现负载均衡(使用Ribbon自带的负载均衡策略)

在浏览器中访问

http://localhost/consumer/payment/get/1

第一次访问返回结果

{"code":200,"message":"查询成功,serverPort: 8001","data":{"id":1,"serial":"15646546546"}}

第二次访问返回结果

{"code":200,"message":"查询成功,serverPort: 8002","data":{"id":1,"serial":"15646546546"}}

第二次访问返回结果

{"code":200,"message":"查询成功,serverPort: 8002","data":{"id":1,"serial":"15646546546"}}

第四次访问返回结果

{"code":200,"message":"查询成功,serverPort: 8001","data":{"id":1,"serial":"15646546546"}}

可以看到四次访问返回的结果中,四次返回结果是没有规律的,因为采用的RandomRule(随机策略),实际返回结果可能不是上面的情况,但是一定是随机进行服务调用的

5.5.声明式配置方式使用Ribbon实现负载均衡(使用Ribbon自带的负载均衡策略)

5.5.1.模块简介

基于Ribbon以声明式配置方式实现的服务消费者,使用Ribbon自带的负载均衡策略,启动端口: 80

5.5.2.模块目录结构

springcloud-consumer-loadbalance-ribbon-configuration-order80

|-- src

| •-- main

| |-- java

| | •-- org

| | •-- openatom

| | •-- springcloud

| | |-- config

| | | •-- ApplicationContextConfig.java

| | |-- controller

| | | •-- OrderConsumerController.java

| | •-- OrderServiceConsumerLoadBalanceRibbonConfiguration80.java

| •-- resources

| •-- application.yml

•-- pom.xml

5.5.3.创建模块

在父工程(springcloud-eureka)中创建一个名为springcloud-consumer-loadbalance-ribbon-configuration-order80的maven模块,注意:当前模块创建成功后,在父工程pom.xml中<modules></modules>中会自动生成有关当前模块的信息

5.5.4.编写模块pom.xml

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<parent>

<artifactId>springcloud-eureka</artifactId>

<groupId>org.openatom</groupId>

<version>1.0-SNAPSHOT</version>

</parent>

<modelVersion>4.0.0</modelVersion>

<artifactId>springcloud-consumer-loadbalance-ribbon-configuration-order80</artifactId>

<properties>

<maven.compiler.source>8</maven.compiler.source>

<maven.compiler.target>8</maven.compiler.target>

</properties>

<dependencies>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-actuator</artifactId>

</dependency>

<!--引入公共的工程-->

<dependency>

<groupId>org.openatom</groupId>

<artifactId>springcloud-api-commons</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-netflix-eureka-client</artifactId>

</dependency>

</dependencies>

<!--热部署需要加这个-->

<build>

<plugins>

<plugin>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-maven-plugin</artifactId>

<executions>

<execution>

<goals>

<goal>repackage</goal>

</goals>

</execution>

</executions>

<configuration>

<fork>true</fork>

<addResources>true</addResources>

</configuration>

</plugin>

</plugins>

<!--打包多环境-->

<resources>

<resource>

<directory>src/main/resources/</directory>

<includes>

<!--不区分环境:直接加载application.yml配置文件-->

<include>application.yml</include>

</includes>

</resource>

</resources>

</build>

</project>

5.5.5.编写模块application.yml

server:

port: 80

spring:

application:

name: SPRINGCLOUD-CONSUMER-LOADBALANCE-RIBBON-CONFIGURATION-ORDER80 #注意:服务名不要出现_

devtools:

restart:

enabled: true

logging:

level: info

eureka:

client:

register-with-eureka: true #表示是否将自己注册进EurekaServer默认为true。

fetchRegistry: true #是否从EurekaServer抓取已有的注册信息,默认为true。服务提供端是单节点无所谓,是集群必须设置为true才能配合ribbon使用负载均衡,否则报异常No instances available for SPRINGCLOUD-PROVIDER-PAYMENT-SERVICE-CLUSTER

service-url:

#单机版

defaultZone: http://localhost:7001/eureka

#集群版

#defaultZone: http://eureka7002:7002/eureka,http://eureka7003:7003/eureka,http://eureka7004:7004/eureka

instance:

instance-id: ${spring.application.name} #Eureka仪表盘中Instances currently registered with Eureka.Status显示的内容

prefer-ip-address: false #访问路径可以显示IP地址,点击Eureka仪表盘中Instances currently registered with Eureka.Status显示的内容地址栏是否显示IP地址

#某个/某些服务的Ribbon配置

SPRINGCLOUD-PROVIDER-PAYMENT-SERVICE-CLUSTER: #服务提供端名称

ribbon:

NFLoadBalancerRuleClassName: com.netflix.loadbalancer.RandomRule #Ribbon负载均衡规则类所在的路径,自带七种规则,也可以是自定位规则的类所在的路径

#服务提供端信息

service:

provider:

name: SPRINGCLOUD-PROVIDER-PAYMENT-SERVICE-CLUSTER #服务提供端名称

url: http://${service.provider.name} #服务提供端调用地址

yml中关于Ribbon负载均衡策略的配置

SPRINGCLOUD-PROVIDER-PAYMENT-SERVICE-CLUSTER:

ribbon:

NFLoadBalancerRuleClassName: com.netflix.loadbalancer.RandomRule

这里使用com.netflix.loadbalancer.RandomRule ,这代表使用的负载均衡算法是RandomRule,Ribbon默认提供了七种负载均衡的算法策略,具体使用哪一种,请根据实际需求灵活选择,这里提供关于七种负载均衡算法的介绍

RoundRobinRule(轮询策略,轮询是Ribbon默认使用的负载均衡算法)

第一次到A,第二次就到B,第三次又到A,第四次又到B......

具体实现是一个负载均衡算法: 第N次请求 % 服务器集群的总数 = 实际调用服务器位置的下标

RandomRule(随机策略)

从服务提供者的列表中随机选择一个服务实例进行调用

RetryRule(轮询重试策略)

按照轮询策略来获取服务,如果获取的服务实例为null或已经失效,则在指定的时间之内不断地进行重试来获取服务,如果超过指定时间依然没获取到服务实例则返回null。

WeightedResponseTimeRule(响应速度决定权重策略)

根据每个服务提供者的响应时间分配一个权重,响应时间越长,权重越小,被选中的可能性也就越低。它的实现原理是,刚开始使用轮询策略并开启一个计时器,每一段时间收集一次所有服务提供者的平均响应时间,然后再给每个服务提供者附上一个权重,权重越高被选中的概率也越大。

BestAvailableRule(最优可用策略)

判断最优其实用的是并发连接数。选择并发连接数较小的server发送请求。

AvailabilityFilteringRule(可用性敏感策略)

先过滤掉非健康的服务实例,然后再选择连接数较小的服务实例。

ZoneAvoidanceRule(区域内可用性能最优策略)

基于AvailabilityFilteringRule基础上做的,首先判断一个zone的运行性能是否可用.剔除不可用的区域zone的所有server,然后再利用AvailabilityPredicate过滤并发连接过多的server。

5.5.6.编写模块config

package org.openatom.springcloud.config;

import org.springframework.cloud.client.loadbalancer.LoadBalanced;

import org.springframework.context.annotation.Bean;

import org.springframework.context.annotation.Configuration;

import org.springframework.web.client.RestTemplate;

@Configuration

public class ApplicationContextConfig {

@Bean

//必须加这个注解,不加这个注解访问会报错

@LoadBalanced

public RestTemplate getRestTemplate(){

return new RestTemplate();

}

}

5.5.7.编写模块controller

package org.openatom.springcloud.controller;

import lombok.extern.slf4j.Slf4j;

import org.springframework.beans.factory.annotation.Value;

import org.springframework.http.ResponseEntity;

import org.springframework.web.bind.annotation.GetMapping;

import org.springframework.web.bind.annotation.PathVariable;

import org.springframework.web.bind.annotation.RestController;

import org.springframework.web.client.RestTemplate;

import org.openatom.springcloud.entities.CommonResult;

import org.openatom.springcloud.entities.Payment;

import javax.annotation.Resource;

@RestController

@Slf4j

public class OrderConsumerController {

//单机版

// public static final String PAYMENT_URL = "http://localhost:8001";

// public static final String PAYMENT_URL = "http://localhost:8002";

//集群版

//从配置文件中动态获取远程调用地址

@Value("${service.provider.url}")

private String SERVICE_PROVIDER_URL;

//从配置文件中动态获服务提供端名称

@Value("${service.provider.name}")

private String SERVICE_PROVIDER_NAME;

@Resource

private RestTemplate restTemplate;

@GetMapping("/consumer/payment/create")

public CommonResult<Payment> create(Payment payment) {

return restTemplate.postForObject(SERVICE_PROVIDER_URL +"/provider/payment/create",payment, CommonResult.class);

}

@GetMapping("/consumer/payment/get/{id}")

public CommonResult<Payment> getPaymentByIdReturnObject(@PathVariable("id") Long id) {

return restTemplate.getForObject(SERVICE_PROVIDER_URL+"/provider/payment/get/"+id,CommonResult.class);

}

@GetMapping("/consumer/payment/getForEntity/{id}")

public CommonResult<Payment> getPaymentByIdReturnResponseEntity(@PathVariable("id") Long id) {

ResponseEntity<CommonResult> entity = restTemplate.getForEntity(SERVICE_PROVIDER_URL+"/provider/payment/get/"+id,CommonResult.class);

if(entity.getStatusCode().is2xxSuccessful()){

return entity.getBody();

}else{

return new CommonResult<>(444,"操作失败");

}

}

}

5.5.8.编写模块主启动类

package org.openatom.springcloud;